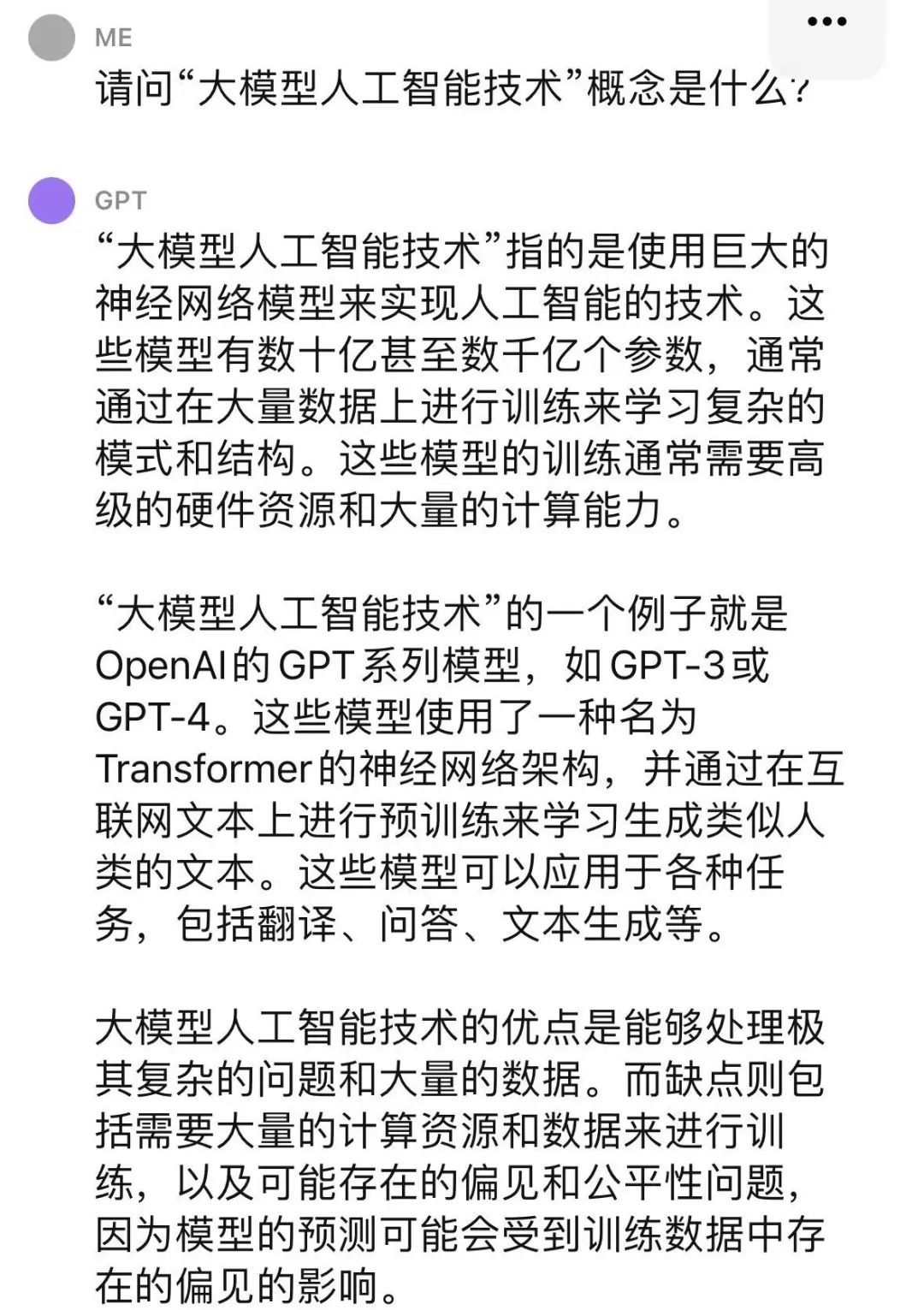

今年年初,美国人工智能公司OpenAI推出的大语言模型ChatGPT登上全球热门应用榜单。强大的自然语言处理和对话交互功能,使其在包括医疗服务在内的诸多领域展示出广泛的应用前景。随后,百度、谷歌等国内外企业相继发布类似产品。以ChatGPT为代表的多种大语言模型的推出,势必会将大模型人工智能技术的应用推上一个高峰。然而,科学的进步必须要有法律和伦理的规制,ChatGPT有时会“一本正经地胡说八道”等问题必须加以重视并有效规避,从而真正推动技术赋能医疗。 人工智能赋能医疗服务 人工智能技术在医疗服务领域具有巨大的应用潜力,可行性已经得到充分证实。自问世以来,人工智能技术先后应用于多个医疗场景,如医疗影像、辅助诊断、药物研发、健康管理、疾病预测、医院管理以及虚拟助理、医疗机器人、医学研究平台等。以ChatGPT为代表的大模型人工智能技术的诞生,则意味着人工智能技术迎来了革命性的转折点。何谓“大模型人工智能技术”?既然是ChatGPT带热的名词,不妨让ChatGPT自己来回答。在ChatGPT问答界面,大模型人工智能技术指的是使用巨大的神经网络模型来实现人工智能的技术。这些模型有数十亿甚至数千亿个参数,通常通过大量数据训练来学习复杂的模式和结构。 大模型通过学习大量数据中的模式,在很多任务上表现得比小模型更好。中国医学科学院医学信息研究所医疗卫生法制研究室主任曹艳林接受记者专访时说,类似ChatGPT这样的大模型在自然语言处理任务上展现出了卓越的性能,已经开始尝试应用于病历书写、报告生成、病例归纳、辅助决策、论文润色等医疗场景,未来可能进一步应用于病例记录、医疗咨询、科普教育、患者管理、学术交流等医疗场景。包容审慎拥抱新技术医学是科学与艺术的结合,大模型人工智能技术同样如此。技术进步可以推动人类发展、创造美好生活,同时也需要感情、伦理和法律的规制来引导其朝着好的方向发展。曹艳林说,要以平和、开放的心态看待以ChatGPT为代表的大模型人工智能技术,更要持包容审慎的态度推动其在医疗服务领域的应用和发展。遵纪守法是对所有公司、机构和公民的基本要求,也是保障社会正常运行的基础。在医疗服务领域的创新和发展中,人工智能技术也必须在法治轨道上前行。曹艳林提出,大模型人工智能技术的开发和使用,首先必须严格遵守所在国家或地区的网络、信息、医疗相关法律法规。具体到医疗服务领域,应遵守辅助可控、患者安全、隐私保护及公序良俗等伦理原则,同时应关注训练数据中存在的偏见,特别是涉及老年人、儿童、妇女、残障人士和“数字贫民”等弱势群体的不利数据。可以预见,大模型人工智能技术在应用和发展的过程中,难免会冲击现有的法律规则、社会秩序、伦理道德等。“尽管法律制修订可能滞后,但对大模型人工智能技术相关立法的思考和研究应具有前瞻性,从而发挥引领、规范、促进和保障作用。”曹艳林认为,对于大模型人工智能技术在医疗服务领域的应用,应采取风险分级的监管策略。为避免过度监管限制技术发展,应以最低限度、必要手段应对不同级别的风险和问题,进而实现规范约束与创新发展之间的平衡。积极应对事实性错误大模型人工智能技术的优点是能够处理极其复杂的问题和大量的数据。缺点则包括需要大量的数据来进行训练,以及可能受数据中存在的偏见影响而出现事实性错误、知识盲区和常识偏差等问题。而且面临训练数据来源合规性、版权争议等人工智能技术的通用风险。记者了解到,由于缺乏医学服务领域大规模高质量的训练数据,以ChatGPT为代表的大语言模型在医学专业领域存在一些“一本正经地胡说八道”和引用错误信息等问题。例如,ChatGPT会就某些疾病症状给出看起来“近乎完美”的治疗方案,并且非常确定方案的科学性;但在专业医生的判断中,该方案简直是“错得离谱”。高质量数据是人工智能技术的发展之本。缺乏大规模高质量的标注训练数据,成为大模型人工智能技术临床应用、研究发展的瓶颈。某医疗科技股份有限公司副总裁陈炳澍介绍,医疗数据标准化程度不高,医疗机构间缺乏数据共建共享机制等,均限制了医疗数据的有效利用。她建议,医疗机构应积极参与人工智能技术研究,积累更多高质量数据,并在国家数据局的统筹下开展数据确权、共享和安全防护等机制的研究,进而推动人工智能技术在医疗服务领域的深度应用。同时,大模型人工智能技术公司应公开训练数据来源,证明其普适性和专业性,并进行公开测试和验证,确保方法开放透明;使用公开数据进行训练时,则应遵守知识产权保护制度。此外,陈炳澍提出,大模型人工智能技术在医疗服务领域的应用,应保持训练数据的多样性、公平性和包容性。一要促进多语言模型的应用,推动语言文字的多样性;二要确保公平,避免对特殊人群或个人造成偏见和歧视,避免对处于科技不利地位的人造成更不利的影响;三要为中医药赋能,推动病证诊疗结合、中西数据汇通,提升中医诊疗规律总结,推动中医现代化发展。规范医生使用行为医疗服务领域非常特殊,事关公民身体健康和生命安全。人工智能技术,尤其是大模型人工智能技术应用到医疗服务领域后,一旦所提供的信息出现错误,很有可能导致无法挽回的严重后果。“一定要关注医疗相关人工智能技术的专业性、可靠性。”首都医科大学附属北京朝阳医院医学伦理委员会办公室主任钟光珍对记者说,对于大模型人工智能技术在医疗服务领域的应用,应制定审批制度,通过评估训练数据的来源及质量、算法的科学性、结论的可解释性,尽可能地规避技术发展带来的潜在风险,进而推动医疗相关人工智能技术的良性发展。同时,应加强医务人员使用行为的监管和指导,建立合理的责任认定规则,特别是在某些容易产生误导信息的个性化诊疗领域。对于广大临床医生、医技人员以及在校医学生来说,大模型人工智能技术的关注热点还在于其论文写作的功能。记者了解到,不只是国外,国内一些高校的不少学生已经开始尝试利用ChatGPT等大语言模型撰写论文,甚至国内网络平台还存在“如何用ChatGPT写论文?简单5步教你搞定!”的“攻略”文章。确实,刚问世不久,ChatGPT作为共同作者,曾出现在已发表的论文和预印本中,其中就包括医学研究期刊。但紧接着,国际知名期刊《科学》《自然》以及爱思唯尔(Elsevier)等医学研究出版机构先后规范了医学研究创新领域使用ChatGPT的情况,提出不接受ChatGPT作为共同作者的文献发表,并要求在文献中介绍ChatGPT的使用情况。国内诸如《暨南学报(哲学社会科学版)》《天津师范大学学报(基础教育版)》等也发布相关声明,表述类似观点。“医学研究必须依靠真实数据,不能主观臆想,容不得半点作假。对于以ChatGPT为代表的大模型人工智能技术在医学研究创新领域的应用,必须慎之又慎。”曹艳林说,面对大模型人工智能技术在医疗领域的深度应用,在关注署名权、文献说明等表观层面问题的同时,也应关注学术期刊编辑策略和工具的更新完善。近日,北京卫生法学会大数据与互联网人工智能医疗专业委员会联合中国生物医学工程学会医学人工智能分会法律伦理专家组,集合14名高校、科研机构、医疗机构、法律以及产业界的专家,编写了《大模型人工智能技术在医疗服务领域应用的专家共识》。作为执笔人之一的曹艳林介绍,《专家共识》在“规范AI与学术出版”方面提出,学术期刊应关注以ChatGPT为代表的大模型人工智能技术的应用,并采取必要应对措施;学术期刊编辑需要新工具辨别基于ChatGPT产生或修订的内容。

大模型通过学习大量数据中的模式,在很多任务上表现得比小模型更好。中国医学科学院医学信息研究所医疗卫生法制研究室主任曹艳林接受记者专访时说,类似ChatGPT这样的大模型在自然语言处理任务上展现出了卓越的性能,已经开始尝试应用于病历书写、报告生成、病例归纳、辅助决策、论文润色等医疗场景,未来可能进一步应用于病例记录、医疗咨询、科普教育、患者管理、学术交流等医疗场景。包容审慎拥抱新技术医学是科学与艺术的结合,大模型人工智能技术同样如此。技术进步可以推动人类发展、创造美好生活,同时也需要感情、伦理和法律的规制来引导其朝着好的方向发展。曹艳林说,要以平和、开放的心态看待以ChatGPT为代表的大模型人工智能技术,更要持包容审慎的态度推动其在医疗服务领域的应用和发展。遵纪守法是对所有公司、机构和公民的基本要求,也是保障社会正常运行的基础。在医疗服务领域的创新和发展中,人工智能技术也必须在法治轨道上前行。曹艳林提出,大模型人工智能技术的开发和使用,首先必须严格遵守所在国家或地区的网络、信息、医疗相关法律法规。具体到医疗服务领域,应遵守辅助可控、患者安全、隐私保护及公序良俗等伦理原则,同时应关注训练数据中存在的偏见,特别是涉及老年人、儿童、妇女、残障人士和“数字贫民”等弱势群体的不利数据。可以预见,大模型人工智能技术在应用和发展的过程中,难免会冲击现有的法律规则、社会秩序、伦理道德等。“尽管法律制修订可能滞后,但对大模型人工智能技术相关立法的思考和研究应具有前瞻性,从而发挥引领、规范、促进和保障作用。”曹艳林认为,对于大模型人工智能技术在医疗服务领域的应用,应采取风险分级的监管策略。为避免过度监管限制技术发展,应以最低限度、必要手段应对不同级别的风险和问题,进而实现规范约束与创新发展之间的平衡。积极应对事实性错误大模型人工智能技术的优点是能够处理极其复杂的问题和大量的数据。缺点则包括需要大量的数据来进行训练,以及可能受数据中存在的偏见影响而出现事实性错误、知识盲区和常识偏差等问题。而且面临训练数据来源合规性、版权争议等人工智能技术的通用风险。记者了解到,由于缺乏医学服务领域大规模高质量的训练数据,以ChatGPT为代表的大语言模型在医学专业领域存在一些“一本正经地胡说八道”和引用错误信息等问题。例如,ChatGPT会就某些疾病症状给出看起来“近乎完美”的治疗方案,并且非常确定方案的科学性;但在专业医生的判断中,该方案简直是“错得离谱”。高质量数据是人工智能技术的发展之本。缺乏大规模高质量的标注训练数据,成为大模型人工智能技术临床应用、研究发展的瓶颈。某医疗科技股份有限公司副总裁陈炳澍介绍,医疗数据标准化程度不高,医疗机构间缺乏数据共建共享机制等,均限制了医疗数据的有效利用。她建议,医疗机构应积极参与人工智能技术研究,积累更多高质量数据,并在国家数据局的统筹下开展数据确权、共享和安全防护等机制的研究,进而推动人工智能技术在医疗服务领域的深度应用。同时,大模型人工智能技术公司应公开训练数据来源,证明其普适性和专业性,并进行公开测试和验证,确保方法开放透明;使用公开数据进行训练时,则应遵守知识产权保护制度。此外,陈炳澍提出,大模型人工智能技术在医疗服务领域的应用,应保持训练数据的多样性、公平性和包容性。一要促进多语言模型的应用,推动语言文字的多样性;二要确保公平,避免对特殊人群或个人造成偏见和歧视,避免对处于科技不利地位的人造成更不利的影响;三要为中医药赋能,推动病证诊疗结合、中西数据汇通,提升中医诊疗规律总结,推动中医现代化发展。规范医生使用行为医疗服务领域非常特殊,事关公民身体健康和生命安全。人工智能技术,尤其是大模型人工智能技术应用到医疗服务领域后,一旦所提供的信息出现错误,很有可能导致无法挽回的严重后果。“一定要关注医疗相关人工智能技术的专业性、可靠性。”首都医科大学附属北京朝阳医院医学伦理委员会办公室主任钟光珍对记者说,对于大模型人工智能技术在医疗服务领域的应用,应制定审批制度,通过评估训练数据的来源及质量、算法的科学性、结论的可解释性,尽可能地规避技术发展带来的潜在风险,进而推动医疗相关人工智能技术的良性发展。同时,应加强医务人员使用行为的监管和指导,建立合理的责任认定规则,特别是在某些容易产生误导信息的个性化诊疗领域。对于广大临床医生、医技人员以及在校医学生来说,大模型人工智能技术的关注热点还在于其论文写作的功能。记者了解到,不只是国外,国内一些高校的不少学生已经开始尝试利用ChatGPT等大语言模型撰写论文,甚至国内网络平台还存在“如何用ChatGPT写论文?简单5步教你搞定!”的“攻略”文章。确实,刚问世不久,ChatGPT作为共同作者,曾出现在已发表的论文和预印本中,其中就包括医学研究期刊。但紧接着,国际知名期刊《科学》《自然》以及爱思唯尔(Elsevier)等医学研究出版机构先后规范了医学研究创新领域使用ChatGPT的情况,提出不接受ChatGPT作为共同作者的文献发表,并要求在文献中介绍ChatGPT的使用情况。国内诸如《暨南学报(哲学社会科学版)》《天津师范大学学报(基础教育版)》等也发布相关声明,表述类似观点。“医学研究必须依靠真实数据,不能主观臆想,容不得半点作假。对于以ChatGPT为代表的大模型人工智能技术在医学研究创新领域的应用,必须慎之又慎。”曹艳林说,面对大模型人工智能技术在医疗领域的深度应用,在关注署名权、文献说明等表观层面问题的同时,也应关注学术期刊编辑策略和工具的更新完善。近日,北京卫生法学会大数据与互联网人工智能医疗专业委员会联合中国生物医学工程学会医学人工智能分会法律伦理专家组,集合14名高校、科研机构、医疗机构、法律以及产业界的专家,编写了《大模型人工智能技术在医疗服务领域应用的专家共识》。作为执笔人之一的曹艳林介绍,《专家共识》在“规范AI与学术出版”方面提出,学术期刊应关注以ChatGPT为代表的大模型人工智能技术的应用,并采取必要应对措施;学术期刊编辑需要新工具辨别基于ChatGPT产生或修订的内容。 文:本刊记者 宁艳阳审核:孔令敏 张士国制作:中小卫2号

文:本刊记者 宁艳阳审核:孔令敏 张士国制作:中小卫2号