Information Fusion:GPT-4V with Emotion(下篇)论文链接:https://arxiv.org/pdf/2312.04293.pdf代码链接:https://github.com/zeroQiaoba/gpt4v-emotionGPT-4V with Emotion(上篇):https://mp.weixin.qq.com/s/yPirDU6bxAA-UoEwnFzKkQ论文作者:连政1、孙立才1、孙海洋1、陈康2、温卓凡1、顾浩1、刘斌1、陶建华3

Information Fusion:GPT-4V with Emotion(下篇)论文链接:https://arxiv.org/pdf/2312.04293.pdf代码链接:https://github.com/zeroQiaoba/gpt4v-emotionGPT-4V with Emotion(上篇):https://mp.weixin.qq.com/s/yPirDU6bxAA-UoEwnFzKkQ论文作者:连政1、孙立才1、孙海洋1、陈康2、温卓凡1、顾浩1、刘斌1、陶建华3

单位:1中国科学院自动化研究所,2北京大学,3清华大学

摘要

最近,GPT-4V在多种任务上展现出了卓越的能力,但其在情感识别方面的表现尚未得到充分验证。为此,本文展示了GPT-4V在21个基准情感数据集上的定量评估结果,涵盖6个任务:视觉情感分析、推文情感分析、微表情识别、面部情感识别、动态面部情感识别、多模态情感识别。本文将这些任务统称为“广义情感识别(GER)”。通过实验分析,我们发现GPT-4V在GER任务中表现出了强大的视觉理解能力。与此同时,GPT-4V显示出了多模态融合以及时序建模能力。然而,目前GPT-4V主要适用于通用领域,在需要专业知识的微表情识别任务上性能不佳。本文提供了GPT-4V在GER任务中的首个定量评估结果。我们已经开源了代码,并希望后续的研究者拓展评估范围,囊括更多任务和更多数据集。

引言

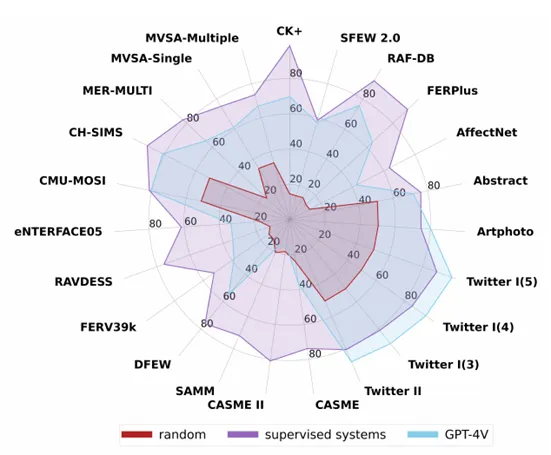

情感因其在人机交互中的重要性引起了研究人员的广泛关注。当前情感识别研究主要集中在两个层面:一个是识别外部刺激诱发的情感;另一个是分析人类通过各种模态传达的情感。我们将这些任务统称为“广义情感识别”。情感与视觉、听觉、文本等信息密切关联。其中,视觉信息(如色彩、亮度、表情、行为等)包含了丰富的情感关联成分。最近,GPT-4V在各种任务中展示出了强大的视觉理解能力。那么,GPT-4V能否在一定程度上解决GER问题?如果可以,那么在GPT-4V出现后,情感计算领域未来需要关注的方向是什么?在2023年9月,GPT-4V被整合到了ChatGPT中。当时,OpenAI尚未发布GPT-4V API,用户只能手动上传测试样本。由于需要大量人力,当时的评测报告通常只为每个任务选择有限数量的样本,仅提供了GPT-4V的定性评估结果。在2023年11月,OpenAI发布GPT-4V API,但限制每天只能访问100次,依然很难在基准数据集上比较GPT-4V与目前最先进系统的性能差距。2023年12月,OpenAI增加了每日限额,使我们能够进行更全面的评估。在本文中,我们提供了GPT-4V在GER任务上的定量评估结果,涵盖了视觉情感分析、推文情感分析、微表情识别、面部情感识别、动态面部情感识别、多模态情感识别。图1显示了GPT-4V的整体结果。我们还展示了随机猜测和监督系统的结果。为了公平比较,我们在基准数据集上进行评估,并使用了一致的评估指标。整体上,GPT-4V优于随机猜测,但仍落后于监督系统。为了找出背后的原因,我们进一步对GPT-4V的多方面能力进行了分析,包括多模态融合、时间建模、鲁棒性、稳定性等。

图1 GPT-4V在GER任务上的定量评估结果

任务描述

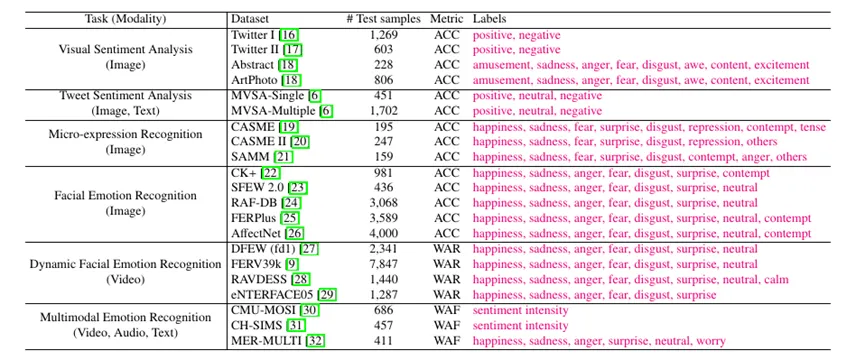

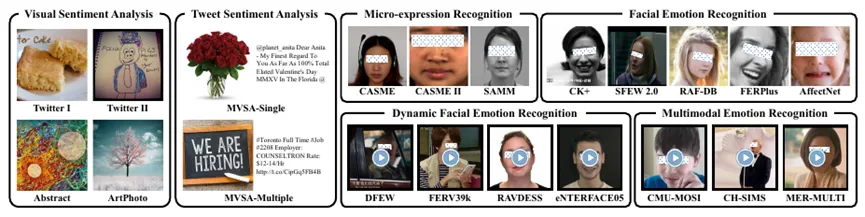

我们详细描述了每个任务的评估数据集。本次评测涵盖6种GER任务共计21个基准数据集。表1汇总了不同数据集的统计信息。为了与监督系统公平比较,我们在官方测试集上评估性能,并选择最常用的评估指标。图 2展示了数据类型的多样性。一些数据集是面向自然场景的(如AffectNet),而另一些是实验室环境下的(如CASME和CK+)。同时,不同数据集存在色彩空间差异。一些数据集使用灰度图像(如CK+),而另一些使用RGB图像(如CASME和AffectNet)。不同数据集的预处理过程详见原始论文。 表1 数据集统计量:测试样本量、评价指标、以及数据集候选标签

表1 数据集统计量:测试样本量、评价指标、以及数据集候选标签

图2 评测数据样例

GPT-4V调用策略

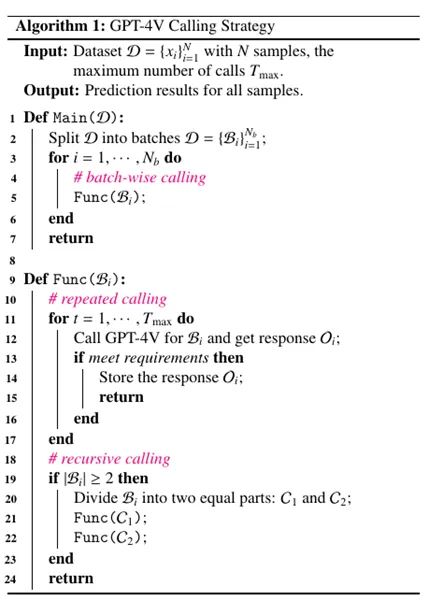

本文评估了GPT-4V API,即“gpt-4-vision-preview”的性能。GER任务涉及多种模态,包括图像、文本、视频、音频。然而,GPT-4V只支持图像和文本。为了处理视频,我们对视频进行采样将其转换为多张图像。为了处理音频,我们尝试将音频转换为梅尔频谱图。然而,GPT-4V未能基于梅尔频谱图生成正确的响应。因此,本文主要关注图像、文本、视频。在本节中,我们为GER任务设计了专门的调用策略,包含batch-wise、repeated和recursive调用模块。具体伪代码详见算法1。(1) Batch-wise CallingGPT-4V API有三个请求限制:每分钟的token数(TPM)、每分钟的请求数(RPM)和每天的请求数(RPD)。为了满足RPM和RPD,我们采用batch-wise输入。具体而言,我们将多个样本同时输入,并在一次请求中生成所有结果。然而,batch size太大可能导致token总数超过TPM限制。此外,它增加了任务难度,可能导致不正确的响应结果。因此,我们将图像的batch size设置为20,视频的batch size设置为6,以同时满足TPM、RPM和RPD的限制。(2) Repeated CallingGER任务经常触发安全检查,导致GPT-4V拒绝提供回复。这主要是因为GER任务包含视觉情感分析和人类情感识别。前者包含暴力和血腥的图像。在后者,人类身份也被视为敏感信息。为了减少拒识情况,我们要求GPT-4V忽略身份信息,但它仍会触发安全检查。有趣的是,这些错误有时是比较随机的。例如,尽管所有图像都是以人为中心,但有些通过了安全检查,而有些则未通过。或者,一个样本可能最初未通过检查,但在重试后通过了。因此,我们对拒识批次进行多次重复调用,直到调用次数上限。(3) Recursive Calling在评估过程中,我们发现批次输入可能会触发安全检查,但将其拆分为更小的批次有时可以通过检查。因此,对于持续拒识的批次,我们将其分成两个较小的批次,然后分别将它们输入GPT-4V中获取相应。(4) 组合策略我们的策略结合了批次调用、重复调用和递归调用。更多细节详见算法1。正确的响应需要满足两个条件。首先,它不应触发安全检查。其次,它应包含正确数量的预测结果。

算法1 GPT-4V调用策略

结果与分析

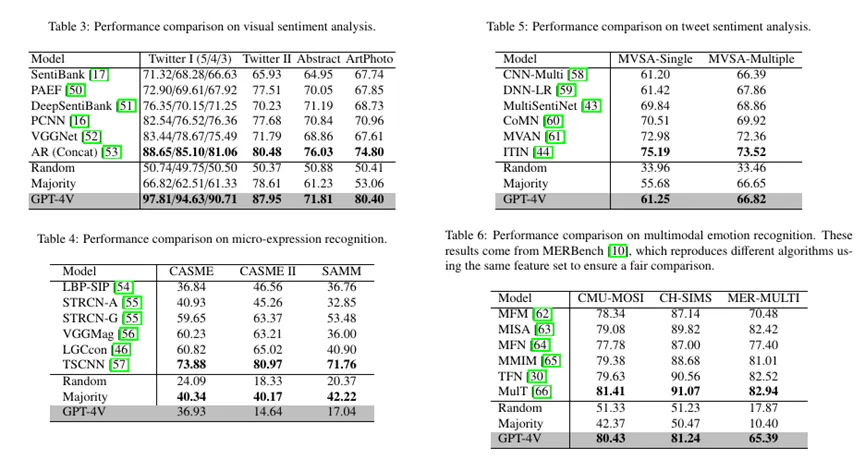

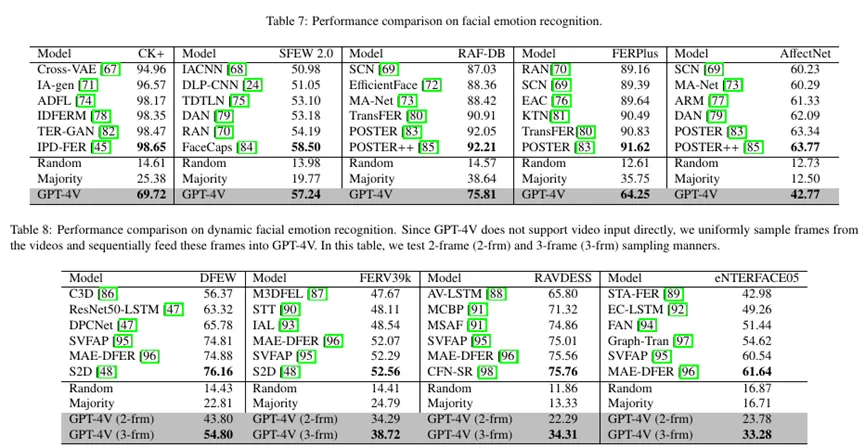

本文从三个层面进行结果分析:数据集层、情感类别层和样本层。我们仅展示部分实验结果。完整的分析报告详见原始论文。(1)数据集层表3展示了视觉情感分析的结果。我们观察到GPT-4V在大多数数据集上优于监督系统。这归因于GPT-4V强大的视觉理解能力,加上其推理能力,使得GPT-4V能够准确推断出图像诱发的情感状态。但对于微表情识别(见表4),GPT-4V表现不佳,甚至有时比随机猜测更差。这些结果表明,GPT-4V主要为通用领域设计。它不适用于需要专业知识的微表情识别。表5~8展示了推文情感分析、多模态情感识别、面部情感识别和动态面部情感识别的结果。为了处理视频,我们对视频进行均匀采样,并将这些采样图像按顺序输入GPT-4V。为了降低调用成本,我们最多采样三帧。实验结果表明,尽管GPT-4V与监督系统之间仍然存在着性能差距,但GPT-4V显著优于启发式基线,显示了其在情感识别任务中的潜力。

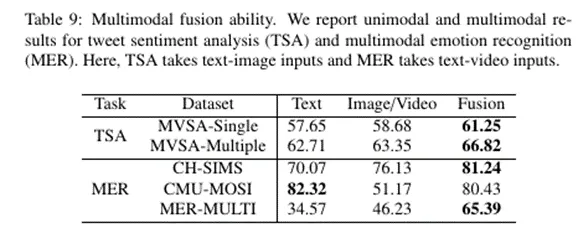

(2)时序建模能力分析为了减少GPT-4V的调用成本,本文限制每个视频最多采样三帧。在本节,我们进一步分析了采样数量的影响。在表8中,当我们将采样数量从两帧增加到三帧时,情感识别性能有所提高。此外,值得注意的是,尽管将采样数量设置为三帧,仍可能会忽略一些关键帧信息。因此,采样更多帧可能会进一步提升情感识别结果,我们将其作为后续工作。(3)多模态融合能力分析本节评估了GPT-4V的多模态融合能力。在所有任务中,推文情感识别和多模态情感识别提供了两种或两种以上模态信息。因此,我们在这些任务上进行了实验分析。表9显示了单模态和多模态结果。整体上,多模态结果优于单模态结果,这展示了GPT-4V整合和利用多模态信息的能力。但对于CMU-MOSI,我们注意到多模态结果略微低于单模态结果。这可能是因为CMU-MOSI主要依赖文本来传达情感,增加额外的视觉线索可能会引入干扰信息,进而影响模型判断。

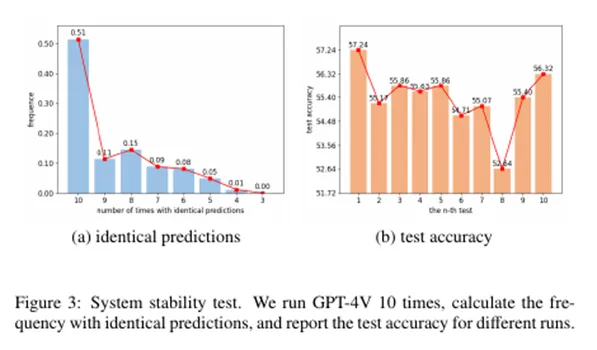

(2)时序建模能力分析为了减少GPT-4V的调用成本,本文限制每个视频最多采样三帧。在本节,我们进一步分析了采样数量的影响。在表8中,当我们将采样数量从两帧增加到三帧时,情感识别性能有所提高。此外,值得注意的是,尽管将采样数量设置为三帧,仍可能会忽略一些关键帧信息。因此,采样更多帧可能会进一步提升情感识别结果,我们将其作为后续工作。(3)多模态融合能力分析本节评估了GPT-4V的多模态融合能力。在所有任务中,推文情感识别和多模态情感识别提供了两种或两种以上模态信息。因此,我们在这些任务上进行了实验分析。表9显示了单模态和多模态结果。整体上,多模态结果优于单模态结果,这展示了GPT-4V整合和利用多模态信息的能力。但对于CMU-MOSI,我们注意到多模态结果略微低于单模态结果。这可能是因为CMU-MOSI主要依赖文本来传达情感,增加额外的视觉线索可能会引入干扰信息,进而影响模型判断。 (4)系统稳定性分析本节评估了GPT-4V的预测结果稳定性。我们用GPT-4V对SFEW 2.0中的每个样本预测了10次结果。图3a展示了相同预测结果出现的频率。具体而言,我们假设对于一个样本,GPT-4V有8次预测为负向情绪,2次预测为正向情绪。那么,它预测为相同标签的次数为$c=8$。然后,我们计算所有样本的 $c$ 并统计其频率。在图3b中,我们展示了每次运行的测试准确率。我们观察到,尽管超过50%的样本在10次测试中表现出相同的结果,但也有一些样本在不同测试中表现出不同的结果,导致测试准确率的波动。与此同时,我们观察到最佳和最差结果之间存在着4.60%的差距。因此,GPT-4V表现出一定的不稳定性。我们建议后续研究者对GPT-4V进行多次评估,并使用多数投票来获得最终预测结果。

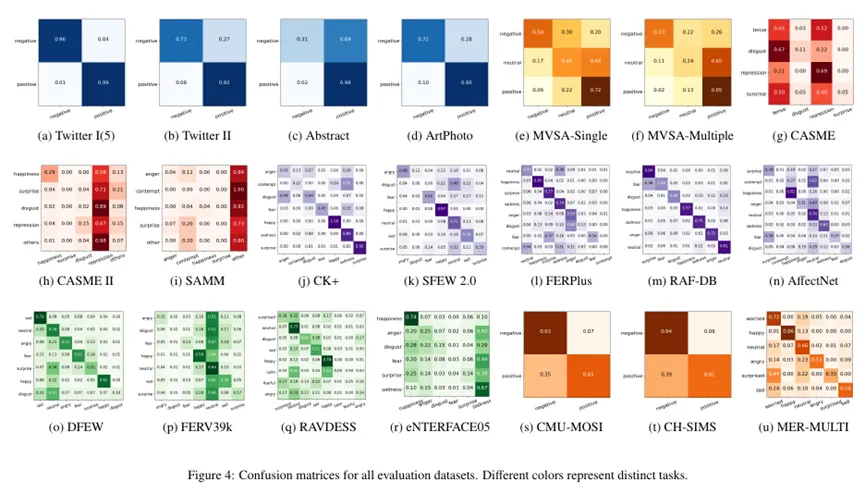

(4)系统稳定性分析本节评估了GPT-4V的预测结果稳定性。我们用GPT-4V对SFEW 2.0中的每个样本预测了10次结果。图3a展示了相同预测结果出现的频率。具体而言,我们假设对于一个样本,GPT-4V有8次预测为负向情绪,2次预测为正向情绪。那么,它预测为相同标签的次数为$c=8$。然后,我们计算所有样本的 $c$ 并统计其频率。在图3b中,我们展示了每次运行的测试准确率。我们观察到,尽管超过50%的样本在10次测试中表现出相同的结果,但也有一些样本在不同测试中表现出不同的结果,导致测试准确率的波动。与此同时,我们观察到最佳和最差结果之间存在着4.60%的差距。因此,GPT-4V表现出一定的不稳定性。我们建议后续研究者对GPT-4V进行多次评估,并使用多数投票来获得最终预测结果。 (5)情感类别层面分析在图 4中,我们可视化了混淆矩阵并进行情感类别层面分析。对于视觉情感分析,GPT-4V在Abstract数据集中的结果较低。这可能是因为GPT-4V主要在自然图像上进行训练。抽象图像和自然图像之间的领域差异导致了GPT-4V有限的性能。对于推文情感分析,GPT-4V在识别 neutral 方面表现相对较差,经常将其错误分类为 positive或 negative。这可能是由于GPT-4V能够在图像–文本对中检测到细微情绪线索,从而导致其做出情感倾向性的判断。对于微表情识别,GPT-4V更偏爱tense 和 repression。与其他标签(如 surprise和 disgust)相比,tense 和 repression更不明显且更接近 neutral。这些结果表明,GPT-4V倾向于将微表情视为 neutral,导致其在这项任务上表现不佳。对于动态面部情感识别,大多数样本倾向于被预测为 neutral,这种现象在FERV39数据集中更为明显。我们将其归因于视频采样操作。对于每个视频,我们最多采样三帧。如果这三帧中没有情感相关的信息,GPT-4V往往会将情感预测为 neutral。

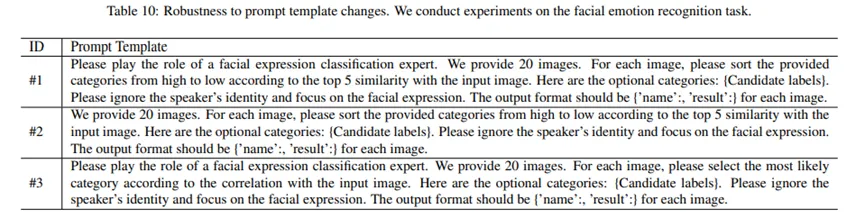

(5)情感类别层面分析在图 4中,我们可视化了混淆矩阵并进行情感类别层面分析。对于视觉情感分析,GPT-4V在Abstract数据集中的结果较低。这可能是因为GPT-4V主要在自然图像上进行训练。抽象图像和自然图像之间的领域差异导致了GPT-4V有限的性能。对于推文情感分析,GPT-4V在识别 neutral 方面表现相对较差,经常将其错误分类为 positive或 negative。这可能是由于GPT-4V能够在图像–文本对中检测到细微情绪线索,从而导致其做出情感倾向性的判断。对于微表情识别,GPT-4V更偏爱tense 和 repression。与其他标签(如 surprise和 disgust)相比,tense 和 repression更不明显且更接近 neutral。这些结果表明,GPT-4V倾向于将微表情视为 neutral,导致其在这项任务上表现不佳。对于动态面部情感识别,大多数样本倾向于被预测为 neutral,这种现象在FERV39数据集中更为明显。我们将其归因于视频采样操作。对于每个视频,我们最多采样三帧。如果这三帧中没有情感相关的信息,GPT-4V往往会将情感预测为 neutral。 (6)提示模版鲁棒性先前的研究指出,预训练语言模型(如BERT和RoBERTa)对提示模板敏感,不同的模板会产生不同的结果。那么,GPT-4V是否也对模板敏感呢?在本节中,我们在SFEW 2.0数据集上比较了不同模板的性能。在表10中,模板#1是我们的默认模板。与模板#1相比,模板#2删除了“请扮演面部表情分类专家”的部分,而模板#3将选择前5个类别改为选择最可能的类别。实验结果表明,模板#2(57.93%)和模板#3(54.25%)的性能与模板#1(57.24%)相当。因此, GPT-4V对模板具有鲁棒性。只要模版能够对任务有明确的表述,不同模版的结果影响不大。

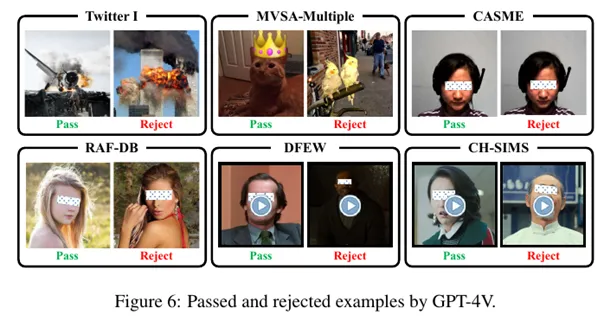

(6)提示模版鲁棒性先前的研究指出,预训练语言模型(如BERT和RoBERTa)对提示模板敏感,不同的模板会产生不同的结果。那么,GPT-4V是否也对模板敏感呢?在本节中,我们在SFEW 2.0数据集上比较了不同模板的性能。在表10中,模板#1是我们的默认模板。与模板#1相比,模板#2删除了“请扮演面部表情分类专家”的部分,而模板#3将选择前5个类别改为选择最可能的类别。实验结果表明,模板#2(57.93%)和模板#3(54.25%)的性能与模板#1(57.24%)相当。因此, GPT-4V对模板具有鲁棒性。只要模版能够对任务有明确的表述,不同模版的结果影响不大。 (7)安全检测系统的稳定性分析GER任务包括视觉情感分析(视觉情感分析包含暴力和血腥内容的图像)和人类情感识别(人类身份在GPT-4V中被视为敏感信息)。因此,GER任务经常触发安全检查。图 6展示了通过和拒识的样本示例。总的来说,拒识样本包含人物或暴力场景。但也有一些情况下,包含此类信息的样本仍然可以通过安全检查。这表明,GPT-4V当前使用的安全检查系统存在一定的不稳定性。

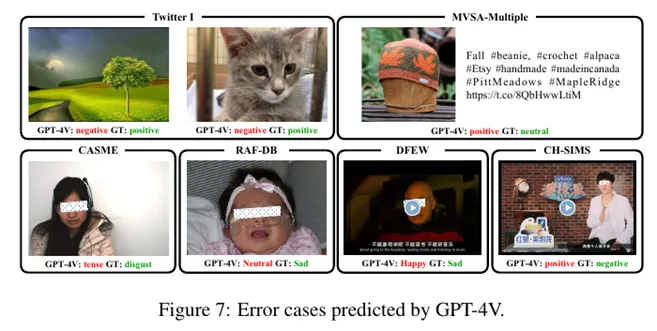

(7)安全检测系统的稳定性分析GER任务包括视觉情感分析(视觉情感分析包含暴力和血腥内容的图像)和人类情感识别(人类身份在GPT-4V中被视为敏感信息)。因此,GER任务经常触发安全检查。图 6展示了通过和拒识的样本示例。总的来说,拒识样本包含人物或暴力场景。但也有一些情况下,包含此类信息的样本仍然可以通过安全检查。这表明,GPT-4V当前使用的安全检查系统存在一定的不稳定性。 (8)错误样本分析在图7 中,我们可视化了GPT-4V做出错误预测的示例。更多示例可以在附录的图8-13中找到。对于视觉情感分析(见Twitter I),我们注意到GPT-4V可以生成合理的预测。这些错误的主要原因是图像固有的歧义性。以左侧的图像为例。一种解释可以强调太阳升起,冲破黑暗的云层,将树木沐浴在阳光中,从而诱发正面情绪。相反,另一种解释可以是强调太阳被黑暗的云层阻挡,从而诱发负面情绪。同样的现象也出现在右边的图中。一方面,有一只可爱的猫,但另一方面,猫被关在笼子里。对于推文情感分析(见MVSA-Multiple),图像显示了一顶帽子放在木头上,并伴有关于帽子的描述。尽管数据集中的标签是neutral,但GPT-4V预测成positive。我们推测GPT-4V可能将这个图像解释为一个舒适的环境和一个漂亮的帽子,从而识别为正向的情感状态。对于微表情识别(见CASME),我们观察到她的情绪并不明显。缺乏专业知识,很难将她的情绪识别为disgust,更可能被预测为neutral。CASME数据集中包含四个候选标签: tense、disgust、repression、surprise。在这些标签中, tense更接近neutral。因此,GPT-4V错误地将她的情绪预测为tense。在未来,我们建议研究人员在提示中提供更清晰的微表情定义。例如,提供用于区分这些微表情的、有代表性的线索。我们相信这种策略可以提高GPT-4V在这项任务中的性能。对于面部表情识别(见RAF-DB),图片描绘了一个张着嘴哭泣的婴儿。同时,她戴着氧气面罩表明她生病了。因此,她的情绪可能是sad。但GPT-4V错误地将她的情绪预测为neutral。这可能是由于它无法识别氧气面罩并推断她的健康状况,说明GPT-4V在理解细节方面的局限性。对于多模态情感识别(见CH-SIMS),GPT-4V根据他的面部表情预测情感为positive。然而,考虑到字幕“我感觉自己要崩溃了”,他抱怨的内容将他的情感转为negative。然而,GPT-4V无法理解这种情感转变,表明了其在复杂场景下多模态融合能力的局限性。总的来说,GPT-4V能够提供相对合理的结果。这些错误主要是由于图像固有的多重含义或其对细节理解能力的局限性导致的。同时,GPT-4V在识别微表情时面临挑战。此外,当不同模态表达不同情绪时,其多模态融合能力可能会面临挑战。

(8)错误样本分析在图7 中,我们可视化了GPT-4V做出错误预测的示例。更多示例可以在附录的图8-13中找到。对于视觉情感分析(见Twitter I),我们注意到GPT-4V可以生成合理的预测。这些错误的主要原因是图像固有的歧义性。以左侧的图像为例。一种解释可以强调太阳升起,冲破黑暗的云层,将树木沐浴在阳光中,从而诱发正面情绪。相反,另一种解释可以是强调太阳被黑暗的云层阻挡,从而诱发负面情绪。同样的现象也出现在右边的图中。一方面,有一只可爱的猫,但另一方面,猫被关在笼子里。对于推文情感分析(见MVSA-Multiple),图像显示了一顶帽子放在木头上,并伴有关于帽子的描述。尽管数据集中的标签是neutral,但GPT-4V预测成positive。我们推测GPT-4V可能将这个图像解释为一个舒适的环境和一个漂亮的帽子,从而识别为正向的情感状态。对于微表情识别(见CASME),我们观察到她的情绪并不明显。缺乏专业知识,很难将她的情绪识别为disgust,更可能被预测为neutral。CASME数据集中包含四个候选标签: tense、disgust、repression、surprise。在这些标签中, tense更接近neutral。因此,GPT-4V错误地将她的情绪预测为tense。在未来,我们建议研究人员在提示中提供更清晰的微表情定义。例如,提供用于区分这些微表情的、有代表性的线索。我们相信这种策略可以提高GPT-4V在这项任务中的性能。对于面部表情识别(见RAF-DB),图片描绘了一个张着嘴哭泣的婴儿。同时,她戴着氧气面罩表明她生病了。因此,她的情绪可能是sad。但GPT-4V错误地将她的情绪预测为neutral。这可能是由于它无法识别氧气面罩并推断她的健康状况,说明GPT-4V在理解细节方面的局限性。对于多模态情感识别(见CH-SIMS),GPT-4V根据他的面部表情预测情感为positive。然而,考虑到字幕“我感觉自己要崩溃了”,他抱怨的内容将他的情感转为negative。然而,GPT-4V无法理解这种情感转变,表明了其在复杂场景下多模态融合能力的局限性。总的来说,GPT-4V能够提供相对合理的结果。这些错误主要是由于图像固有的多重含义或其对细节理解能力的局限性导致的。同时,GPT-4V在识别微表情时面临挑战。此外,当不同模态表达不同情绪时,其多模态融合能力可能会面临挑战。

局限与未来工作

在本节中,我们总结了GPT-4V的主要挑战和局限性,并讨论了未来可能的研究方向。(1)性能。在GER任务中,GPT-4V优于启发式基线,但仍落后于监督系统。这可能是由于情感定义的模糊性。未来,我们计划使用少样本提示来提升任务清晰度和GPT-4V的情感理解能力。(2)模态。GPT-4V不支持音频输入。然而,音频可以通过副语言信息(如基频、时长、能量)传达情感。为了更好地理解情感,GPT-4V应在未来支持音频输入。或者,我们可以使用外部模型将音频转换为文本描述,并将其作为GPT-4V的额外输入。(3)领域差距。GPT-4V主要针对通用领域,在需要专业知识的微表情任务中表现不佳。对于未来工作,我们建议后续研究人员可以尝试在提示设计中提供更清晰的关于微表情的定义。(4)系统稳定性。GPT-4V表现出一定的不稳定性,即可能为同一个样本在多次调用中预测为不同的标签。因此,GPT-4V应在未来提升其系统稳定性。或者,后续工作应多次调用GPT-4V,并使用多数投票来获取最终结果。(5)安全检查稳定性。GPT-4V在安全检查中表现出不稳定性。具体来说,一个样本可能未通过安全检查,但重试后通过了安全检查。为此,我们在本文中设计了一个更实用的调用策略。未来,GPT-4V应增强其安全检查系统的稳定性。

总结

本文对GPT-4V在GER任务中进行了全面评估。我们的评估结果表明,GPT-4V表现出强大的视觉理解能力,在通用情感识别任务中取得了不错的结果。然而,在需要专业知识的微表情识别任务表现不佳。本文还展示了GPT-4V的时序建模和多模态融合能力,以及其对颜色空间和提示模板变化的鲁棒性。此外,我们评估了其预测结果的一致性和安全检查系统的稳定性,并可视化错误案例以揭示其在情感理解方面的局限性。我们希望本次评测结果能够对情感计算领域的研究学者有所启发。引用信息:Zheng Lian, Licai Sun, Haiyang Sun, Kang Chen, Zhuofan Wen, Hao Gu, Bin Liu, Jianhua Tao. “GPT-4V with Emotion: A Zero-shot Benchmark for Multimodal Emotion Understanding”. Information Fusion 2024.

作者简介

连政,助理研究员,2021年于中科院自动化研究所模式识别与智能系统专业获得工学博士学位。2021年7月至今在中科院自动化所工作。研究方向为情感计算。个人主页:https://zeroqiaoba.github.io/Homepage/

刘斌,副研究员,硕士生导师。2007年毕业于北京理工大学获得学士学位,2009年毕业于北京理工大学获得硕士学位,2015年于中科院自动化研究所模式识别与智能系统专业获得博士学位。2015年7月至今在中科院自动化所工作。研究方向为情感计算、音频处理等。

陶建华,清华大学长聘教授、博士生导师,国家杰出青年科学基金获得者,国家万人计划科技创新领军人才,享受国务院政府特殊津贴人员。完成多项国家和国际标准,论文和成果曾多次获国内外学术会议奖励。兼任中国计算机学会会士和常务理事、中国人工智能学会常务理事等职务。