文章主题:ACL 2021, 情感分析, 风格分析, 分类依据

作者:赵丽敏

转载自: 复旦DISC

原文链接:引言

🚀🔥ACL 2021深度解析!🚀🔥🏆论文精华:这里有三颗学术璀璨明珠,带你领略情感与风格的深度探索!🏆1️⃣ 情感导航站:情感分析领域的革新之旅!第一篇和第三篇论文以独特视角,通过特征值分类与交叉风格数据集构建,为提升情感分类模型的精确度提供了创新策略。🚀2️⃣ 分类新维度:第二篇论文用分布式表示引领潮流,重新定义了情感类别间的微妙平衡与连贯性,让情感识别更上一层楼!🔗3️⃣ 风格交响曲:第三篇深入探讨风格分析的奥秘,揭示隐藏在数据背后的多样性和统一性。📚别忘了,这些论文不仅学术价值满满,也是SEO优化的理想选择,让你的研究之路更加搜索引擎友好!🔍欲了解更多细节,敬请关注后续更新或直接搜索相关关键词。👩💻👨💻

文章概览

1. 不确定性和惊讶值共同传递妙语:基于不协调的特征进行幽默识别(Uncertainty and Surprisal Jointly Deliver the Punchline: Exploiting Incongruity-Based Features for Humor Recognition)

论文地址:https://aclanthology.org/2021.acl-short.6/

🌟🔍了解幽默真谛,文本分类挑战升级!💡📝幽默识别,这个热门研究领域虽广受关注,却常在理解其深层机制上迷失方向。🚀🎯本文独辟蹊径,提出创新视角——不协调理论,揭示幽默的灵魂在于颠覆预期的惊喜。🎉🔥理论基石,Set-up与Punchline间的巧妙转换,犹如戏剧高潮,期待与意外交织,带来震撼人心的效果。👀🎬更进一步,作者巧妙融合预训练GPT-2模型,提炼出关键特征——Uncertainty(不确定性)和Surprisal(意外性),为识别幽默文本提供精准导航。🔍🎯实验结果令人鼓舞,这两个独特指标显著提升了模型对幽默文本的分类精度,让机器也能领略那份独特的智慧与幽默感。📈🎉让我们一起探索,用科技解读生活中的欢笑,让文字跃动出无尽的幽默魅力!📖💡

2. 情感空间中情感类别的分布式表示(Distributed Representations of Emotion Categories in Emotion Space)

论文地址:https://aclanthology.org/2021.acl-long.184/

🌟🚀情感识别升级大揭秘!🚀🌟在情感检测的广阔领域里,传统的one-hot标签虽常见,却隐藏着信息丰富度的缺失。作者匠心独运,引领我们步入一个全新的情感分类世界——分布式表(DR)革命!🔍通过创新的DR框架,情感类别不再孤立,而是以分布式形式紧密相连,形成了一张情感类别的知识网络。这就像在情感的语义海洋中,每个类别都拥有独特的定位和动态联系,让理解和区分变得轻松且精准。🌊相较于传统的词向量,DR展现出强大的优越性,它能更细腻地捕捉不同情感间的微妙差异,同时强化了情感类别间深层次的互动。换句话说,DR就像一把情感分析的锐利剪刀,将复杂的情感世界修剪得井然有序。✂️实验证明,这个革命性的转变不仅提升了模型的识别效率,还为深入理解用户情绪提供了全新的视角。让我们一起拥抱DR,开启情感检测的新篇章吧!🎉#情感分类 #分布式表 #DR技术 #语义空间优化

3. 风格不是单一变量:跨风格语言理解案例研究(Style is NOT a single variable: Case Studies for Cross-Stylistic Language Understanding)

论文地址:https://aclanthology.org/2021.acl-long.185/

🌟文章写作大师在此!🚀理解文本风格的丰富层次,是语言艺术中的关键洞察。通过探索情感隐喻等多重维度的复杂交互,我们揭示了风格组合与共变的奥秘。这就是交叉风格语言理解,一个挑战性的任务,旨在构建全面的语篇解读框架。💡为了这个目标,我引荐了{xSLUE}——一款创新的基准资源,它集成了现有的数据宝库,打造了一款专为句子级跨风格理解量身定制的语料库。在这个语料库中,15种独特风格交织:比喻、个人、情感与人际互动,每一组都提供了深度洞察的窗口。👀基于{xSLUE}的力量,我设计并训练了一个全能的分类器,它能自如地处理各种风格的文本融合,这就是交叉风格分类技术的核心。🚀接下来,我们深入探讨了三个引人入胜的应用实例:首先,交叉风格文本分类,揭示不同风格间的微妙差异;其次,风格关联性研究,揭示它们如何相互影响;最后,条件风格文本生成,创造出新颖而符合特定风格的文本。🌈通过{xSLUE}和这个分类器,我们不仅推进了语言理解的进步,也为未来的创新打开了无限可能。🚀欲了解更多详情,敬请关注后续内容,让我们一起探索语言风格的无尽世界!🌐

数据概览

🌟SemEval 2021, the ultimate challenge in natural language processing! 🚀Task 7 is all about detecting humor in tweets and short jokes. Laughter knows no bounds, and this task aims to classify them as hilarious or not. Join the laughter party on Kaggle and dive into the world of linguistic humor! 🎉 Don’t miss out on the opportunity to analyze and understand the nuances of humor in digital communication. Let’s laugh together! 😂 #SemEval2021 #HumorDetection #KaggleChallenge

🌟Transforming Emotional Expressions: Enhancing the Power of GoEmotions 📈Unleash the depth and complexity of English Reddit comments with GoEmotions, a groundbreaking tool that expertly categorizes them into an impressive 27 diverse emotional landscapes. 🌍🚀Crafted to analyze the rich tapestry of online conversations from popular subreddits, this cutting-edge system delves deep into the nuances of human emotions, providing multi-labeled insights for a comprehensive understanding. 💬📊GoEmotions not only revolutionizes sentiment analysis but also bolsters SEO strategies by optimizing content with emotional resonance. 📈🔍Experience the art and science of emotion detection like never before, as your content gains traction and connects with audiences on a deeper level. 🤝🎯欲了解更多关于如何利用GoEmotions提升内容质量和搜索引擎排名的信息,敬请访问我们的官方网站或关注我们的社交媒体平台。 🌟🌐Remember, emotions are the heartbeat of online communication – let GoEmotions be your guide to understanding them all. 💓💻

xSLUE: individual style dataset and cross-style diagnostic set for cross-style language understanding and evaluation

论文细节

1

动机

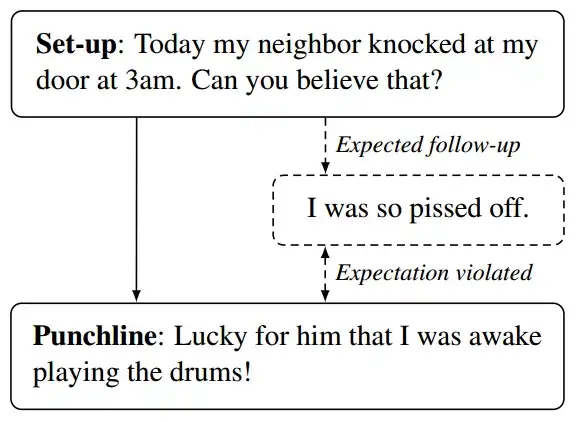

幽默识别一般被视为文本二分类问题,之前的研究一般采用统计机器学习和神经网络的方法在幽默数据集上训练模型,没有尝试将幽默理论运用到幽默识别中。为了进一步提高幽默文本分类效果,本文从幽默的不协调理论出发,将幽默理论与大规模预训练语言模型结合起来去辅助分类器进行幽默文本分类识别。

模型

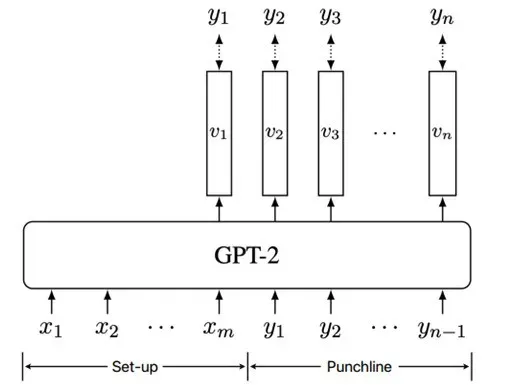

1. GPT-2 语言模型

幽默的不协调理论将一段文本分为 set-up 和 punchline 两个阶段,由于神经网络的崛起,预训练的语言模型可以在一个很大的数据集上学习这两个阶段之间的关系。在给定 set-up(x)后,语言模型可以续写出期待的后续(y),通过比较真实的 punchline 和语言模型生成的 y,我们就可以定量衡量这段文本的不协调程度。

作者将 set-up 和 punchline 拼接之后输入预训练的语言模型 GPT-2,根据模型输出的概率分布计算这段文本的两个特征值:Uncertainty 和 Surprisal。

2. Uncertainty

作者用概率分布的平均熵来表示 Uncertainty。这里的 VV 代表整个词典, viwv_{i}^{w} 指模型第 ii 个输出为词典中的单 词 ww 的概率,然后用这个熵的公式去遍历一轮词典中所有的词,就得到了第 ii 个输出的 Uncertainty, 接着将 所有输出的 Uncertainty 的值相加并除以输出的个数,就得到了这段文本的 Uncertainty。

U(x,y)=−1|y|∑i=1n∑w∈VviwlogviwU(x, y)=-\frac{1}{|y|} \sum_{i=1}^{n} \sum_{w \in V} v_{i}^{w} \log v_{i}^{w} \\

2. Surprisal

Surprisal 可以反映语言模型生成真实 punchline 的概率:该概率越大,Surprisal 的值越小。Surprisal 被定义为:

S(x,y)=−1|y|logp(y∣x)=−1|y|∑i=1nlogviyi\begin{aligned} S(x, y) &=-\frac{1}{|y|} \log p(y \mid x) \\ &=-\frac{1}{|y|} \sum_{i=1}^{n} \log v_{i}^{y_{i}} \end{aligned} \\

这里的 VV 代表整个词典, viyiv_{i}^{y_{i}} 指模型第 ii 个输出为真实值 yiy_{i} 的概率。

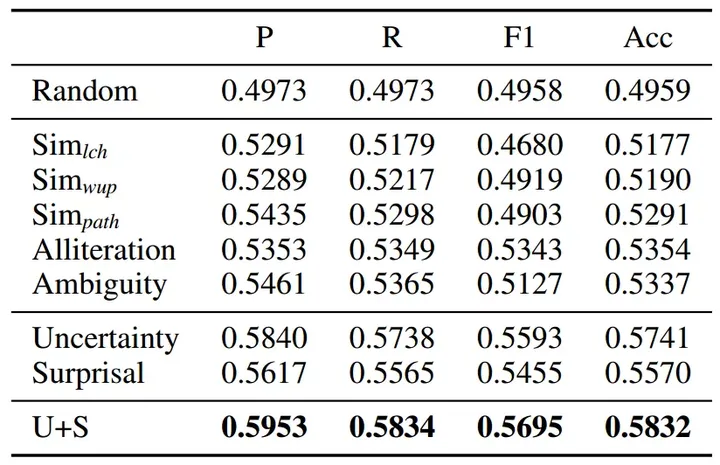

实验

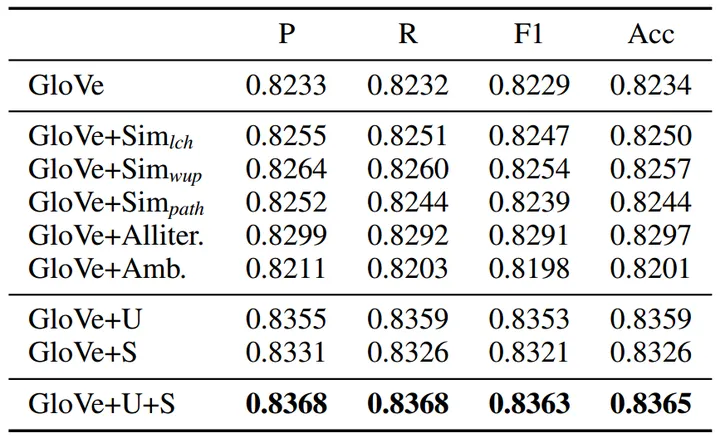

为了让数据集更适用于文章提出的幽默框架,作者只考虑其中正好含有两个句子的正例(笑话),和至少含有两个句子的反例(非笑话)。这样第一个句子就是 set-up,第二个句子就是 punchline。然后作者用支持向量机分类器检测单个特征(Uncertainty / Surprisal)以及联合特征(U+S)在区分笑话上的有效性。实验结果见下表。相较于 baseline,作者提出的这两个特征在 4 个评价指标上表现都更加优异,而这两者联合起来之后模型的分类效果达到了最优值。

接着,作者构建了一个基于内容的分类器,来验证特征和词向量结合后的有效性。作者用 glove 预训练的词向量将 set-up 和 punchline 转换成 50 维向量的表示形式(具体做法为:将每一个单词的词向量在各个维度上对应相加求和并根据长度做归一化),并将这两部分的向量拼接起来,用 100 维的向量去表达这段文本。然后将两个特征值附加在这个 100 维的向量后面,用 SVM 支持向量机进行分类,结果如下图。可以看到 glove 词向量和单独的特征结合就可以提升模型的分类性能,而词向量和两个特征结合之后模型获得了最大的性能提升,说明作者给出的这两个特征值(Uncertainty / Surprisal)可以很好的区分幽默文本与非幽默文本。

2

动机

情感分类是文本情感分析领域非常重要的一项任务,但是在现有的研究中,情感类别通常被表示为 one-hot 向量形式,这种表示方式无法体现情感类别之间的关联。因此,为了更好的表达情感关系,本文提出了情感类别的分布式表示(Distributed Representations, DR)。

模型

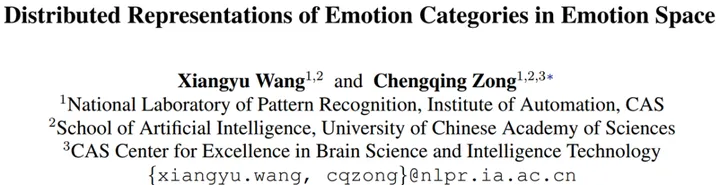

以类别 KK 为例,为了获得类别KK的分布式表示,第一步需要计算数据集中类别KK对应的所有样本的分布式表示;第二步根据样本的分布式表示计算出类别KK的分布式表示。

1. 样本的分布式表示

样本输入进神经网络之后,模型的输出值是一个 soft label,这个向量在第 ii 维的值代表样本属于第 ii 个类别的概率,在本次任务中,作者使用 soft label 作为样本的分布式表示(Distributed Representations, DR)。

2. 情感类别的分布式表示

以类别 KK 为例, 在第一步中, 我们得到了所有被标注为类别 KK 的样本的 DR: (V1,V2,…,VN)\left(\boldsymbol{V}_{1}, \boldsymbol{V}_{2}, \ldots, \boldsymbol{V}_{N}\right), 类别 KK 的 DR (用 VV 表示) 需要满足它和对应样本的 DR 距离和最小:

V=argminVLoss(V;V1,V2,…,VN)\boldsymbol{V}=\underset{\boldsymbol{V}}{\operatorname{argmin}} \operatorname{Loss}\left(\boldsymbol{V} ; \boldsymbol{V}_{1}, \boldsymbol{V}_{2}, \ldots, \boldsymbol{V}_{N}\right) \\

最小二乘损失来定义距离:

Loss(V;V1,V2,…,VN)=∑i‖V−Vi‖2\operatorname{Loss}\left(\boldsymbol{V} ; \boldsymbol{V}_{1}, \boldsymbol{V}_{2}, \ldots, \boldsymbol{V}_{N}\right)=\sum_{i}\left\|\boldsymbol{V}-\boldsymbol{V}_{i}\right\|^{2} \\

损失函数对 VV 求导并令导数为 0 即可求得 VV 的最优解: V=1N∑iViV=\frac{1}{N} \sum_{i} V_{i}, 因此, 情感类别 KK 的 DRD R 在形式 上就是所有被标注为类别 KK 的样本的 DRD R 的均值。

实验

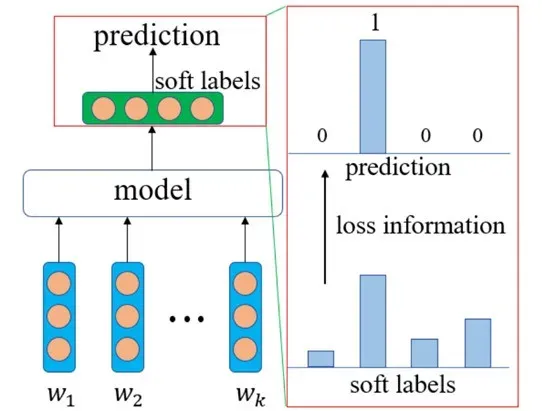

实验所使用的数据集(GoEmotions)共含有 27 个情感类别,这些类别按照不同的分类标准有两种划分形式:

三种态度:Positive / Negative / Ambiguous六个基类:Anger / Disgust / Fear / Joy / Sadness / Surprise

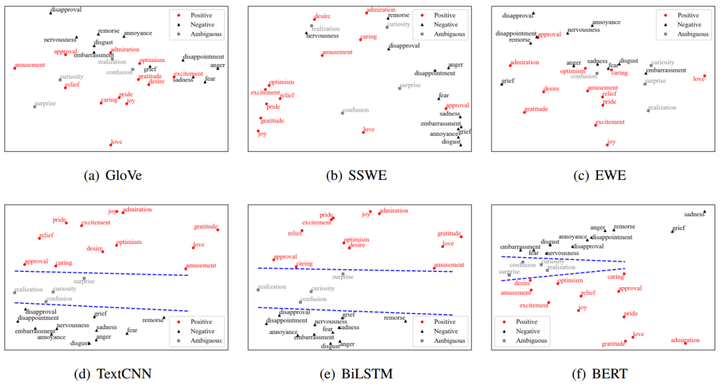

在实验阶段,作为对照,作者用每一个情感类别对应的词向量作为其在语义空间中的向量表示,文中一共使用了三种词向量:GloVe / SSWE / EWE。作为对 GloVe 的改进版本,SSWE 和 EWE 将词的情感信息也编码进了词向量中。

接着作者对不同情感类别的分布式表示(DR)和词向量表示进行了降维可视化的处理。可以发现,词向量表示的情感类别,三个大类之间没有明显的界限,但是分布式表示中,这三类可以被两条线很明显的分开,这表明分布式表示可以很好的区分不同类别的情感词汇。在情感空间中,情感态度相似的词会更容易聚集在一起。

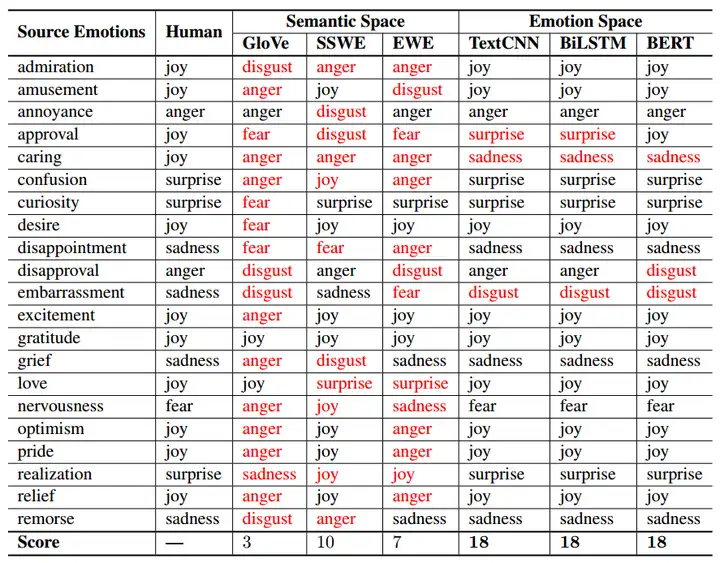

第二个实验是 Mapping 实验,任务是将 21 个情感类别划分到 6 个情感基类中。对每一个情感类别,我们需要从 6 个情感基类中选择一个和它最相近的词作为我们的输出结果,相似程度以余弦相似度(Cosine Similarity)表征,结果如图:

Human 列是人为标注的正确答案,如果标错在图中显示红色。比较语义空间的词向量和情感空间的分布式表示(DR)在这个任务上的正确得分,可以发现,情感的分布式表示可以更好的完成相似情感类别的映射任务,可以更好的展现情感类别之间的关联。

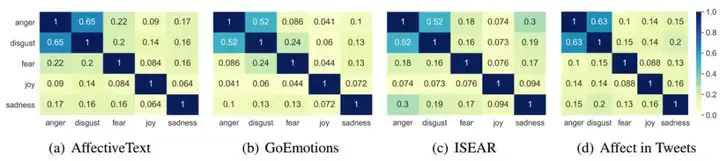

最后,为了衡量不同语料库中情感关系(Emotion Relation)的一致性,作者计算了不同数据集情感类别的 DR 间的余弦相似度,由结果知情感类别的分布式表示(DR)所展现出来的不同情感类别之间的 boundaries 和 relations 是不因数据集而异的。

3

动机

现有的文本风格研究主要针对的是单一风格,但是风格并不是单一变量,而是多个变量共同变化形成的,仅仅关注单一风格会忽略风格的相关性。为了全面的理解文本的风格以及不同风格之间的依赖关系,作者构建了新的交叉风格数据集并尝试去回答下面三个问题:

一段文本中的风格是如何共同变化的?哪些风格之间会相互依赖?不同风格如何系统的组合以产生恰当的文本?模型

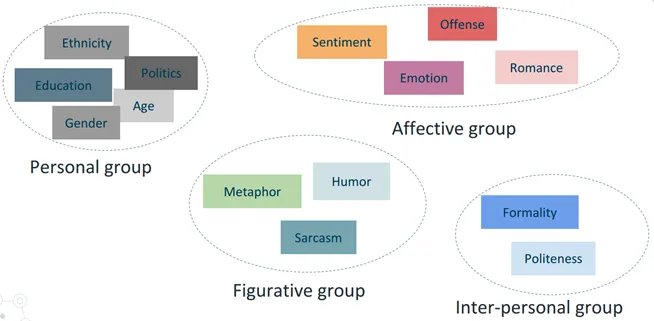

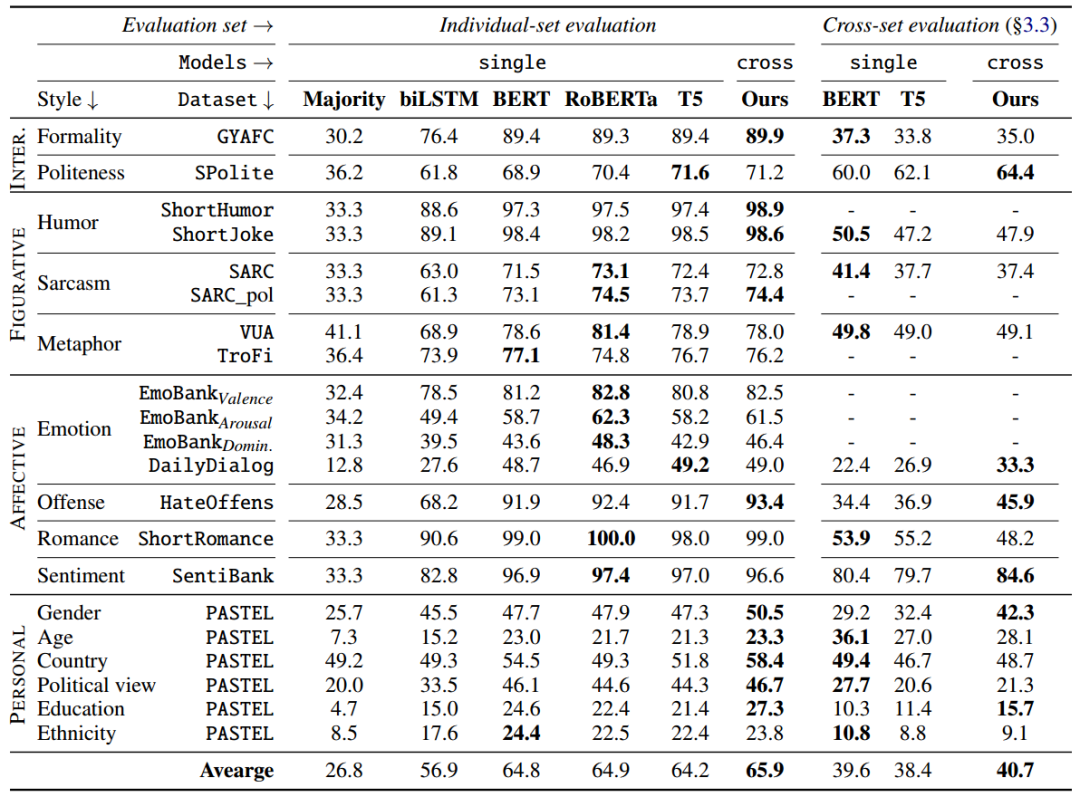

为了进行比较全面的风格研究,作者构建了一个新的数据集:xSLUE。这个数据集中包含 15 个单一风格的数据集和 1 个交叉风格的数据集(交叉集)。这 15 种风格可以根据不同的社会目标分为四个大组:个人组,情感组,比喻组,人际交往组。

交叉集就是在同一样本上标注所有 15 种风格的标签,如下图所示。

实验

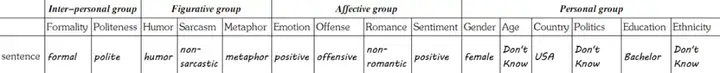

1. 交叉风格文本分类

在交叉风格文本分类中,作者构建了两个分类器:单一风格分类器和交叉风格分类器(如下图)。

单一风格分类器在单一风格的数据集上进行训练;而交叉风格分类器在多种不同风格的数据集上进行共同训练,它的输入不再是一个简单的句子,而是很多来自不同风格文本的组合,它们打包之后输入基于编码器 – 解码器的分类模型,模型最终输出一组 style label,每一个 label 都对应着输入中的一个句子。

单一风格分类器属于判别式模型, 对 p(y \mid X) 条件概率分布进行建模; 交叉风格分类器属于生成式模型, 对 p(X, y) 联合概率分布进行建模。

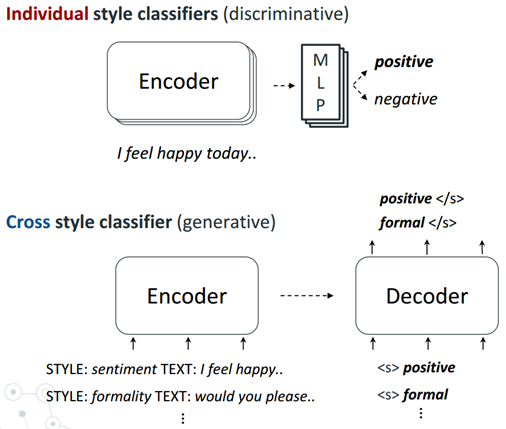

这两类分类器在对应的训练集上训练完成之后,作者用单一风格数据集的测试集和交叉集分别对模型性能进行评估,结果如下图所示,图中的得分均为 F1 值。

由结果可知,不论是用单一风格数据集的测试集还是用交叉集进行评估,交叉风格分类器在 15 类风格分类任务中的平均得分都要高于单一风格分类器,说明对多风格样本的共同学习可以显著提高模型在风格分类任务中的性能。

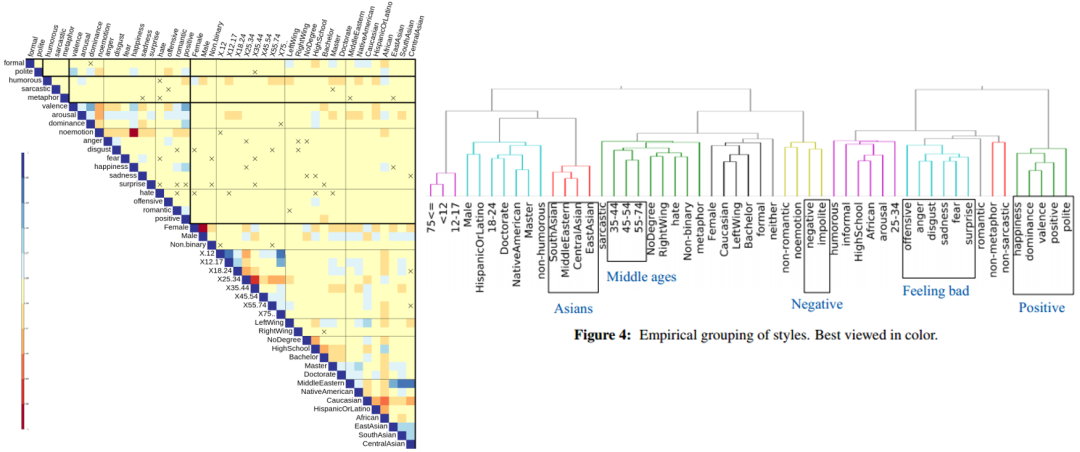

2. 风格关联性研究

为了探究不同风格之间的相关性,作者从推特上抓取了一百万条推文,用交叉风格分类器预测这些推文所属的 style label,然后对这些 label 进行皮尔森相关性分析,得到下图所示的相关性矩阵。通过总结高度相关的风格,作者发现了一些常见的风格集群,例如 Positive 和 Feeling bad。实验证明一些特定风格之间的相关性要比和其他风格之间的相关性高,当某种风格发生变化时,与之相关的其他风格很大概率也会发生变化。

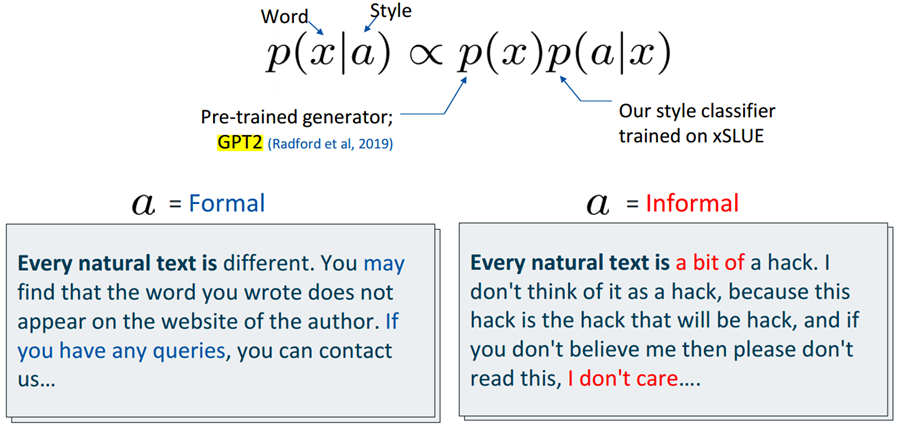

3. 条件风格文本生成

第三个实验是条件风格文本生成实验。将交叉风格分类器和预训练生成器结合就组成了条件风格生成器。在给定 Style 时,生成单词 x 的概率正比于p(x)和 p(\alpha|x) 的乘积。

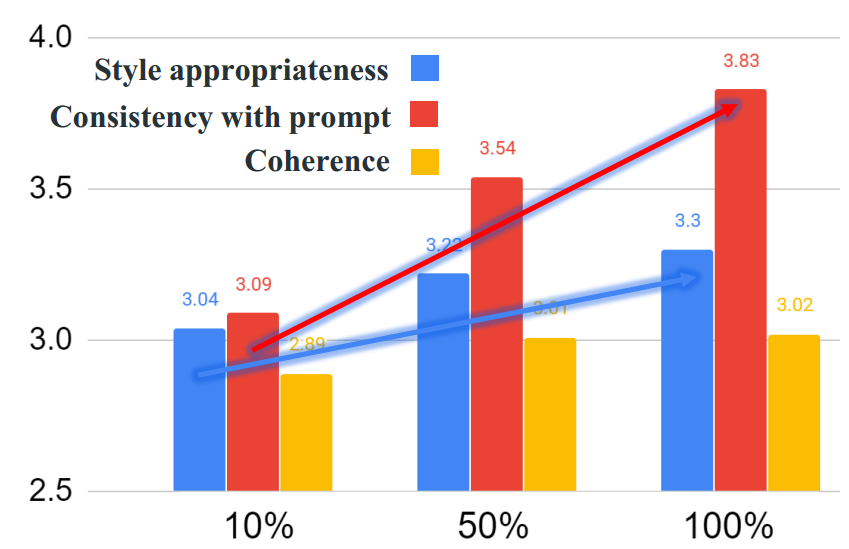

为了探究分类器的性能和生成质量之间的关系,作者通过提前停止的策略降低分类器的分类效果,并用这个没有迭代完全的分类器(利用前面的公式)生成指定风格的文本,并人工评估文本的质量。评估指标有三个:Style appropriateness (生成的文本是否符合指定的风格) / Consistency with prompt (生成的文本和开头的连贯性)/ Coherence(整体的一致性)。可以看到,随着迭代次数的增加(即分类器性能的提升),生成文本的质量也在稳步提高(eg. 3.04 \rightarrow 3.83)。也就是说,更好的分类性能可以带来更好的条件风格文本生成质量。

机器学习/深度学习算法/自然语言处理交流群

已建立机器学习算-自然语言处理微信交流群!想要进交流群进行学习的同学,可以直接加我的微信号:HIT_NLP。加的时候备注一下:知乎+学校+昵称 (不加备注不会接受同意,望谅解),想进pytorch群,备注知乎+学校+昵称+Pytorch即可。然后我们就可以拉你进群了。群里已经有非得多国内外高校同学,交流氛围非常好。

强烈推荐大家关注机器学习算法与自然语言处理账号和机器学习算法与自然语言处理微信公众号,可以快速了解到最新优质的干货资源。

推荐阅读

ICLR2021 | 近期必读图神经网络精选论文 – 知乎 (zhihu.com)

AAAI 近20年最佳论文合集 – 知乎 (zhihu.com)

NAACL 2021 | 对比学习横扫文本聚类任务 – 知乎 (zhihu.com)

不可错过!CMU「概率图模型」课程,附Slides – 知乎 (zhihu.com)

ICCV 2021审稿结果出炉,有人已总结出了一份Rebuttal写作指南 – 知乎 (zhihu.com)

腾讯优图+厦门大学发布!2021十大人工智能趋势 – 知乎 (zhihu.com)

2021下半年会议论文投稿时间小结与历年接受率回顾(欢迎收藏) – 知乎 (zhihu.com)

PyTorch 常用代码段汇总 – 知乎 (zhihu.com)

Transformer长大了,它的兄弟姐妹们呢?(含Transformers超细节知识点) – 知乎 (zhihu.com)

Transformer Decoder-Only 模型批量生成 Trick – 知乎 (zhihu.com)

第十届全国社会媒体处理大会(SMP 2021) 技术评测方案 – 知乎 (zhihu.com)

首篇NLP图神经网络综述来了! 127页文档让你全面了解这个领域 – 知乎 (zhihu.com)

Transformer杀疯了!竟在图神经网络的ImageNet大赛中夺冠,力压DeepMind、百度…… – 知乎 (zhihu.com)

深度学习中的Attention总结 – 知乎 (zhihu.com)

【关于 AAAI 2021 之 情感分析论文串烧】那些你不知道的事 – 知乎 (zhihu.com)

ACL2021 main conference long papers list已出 – 知乎 (zhihu.com)

强烈推荐!斯坦福讲师出版《机器学习面试》书稿,涵盖200+考点! – 知乎 (zhihu.com)

DeepMind科学家Trask著作《图解深度学习》,335页pdf与代码 – 知乎 (zhihu.com)

图自监督学习(Graph Self-supervised Learning)最新综述+Github代码汇总 – 知乎 (zhihu.com)

ICLR/CVPR时间更新 || 2021下半年会议论文投稿时间小结与历年接受率回顾(欢迎收藏) – 知乎 (zhihu.com)

每日论文速递:计算机视觉相关(6月29日更新版) – 知乎 (zhihu.com)

中科院软件所中文信息处理实验室招收2021年推免学生(硕博各2-3名) – 知乎 (zhihu.com)

一文掌握《对比学习(Contrastive Learning)》要旨,详述MoCo和SimCLR算法 – 知乎 (zhihu.com)

赛尔笔记|基于深度学习方法的对话状态跟踪综述 – 知乎 (zhihu.com)

近期必读的6篇顶会CVPR 2021【零样本学习(ZSL)】相关论文和代码 – 知乎 (zhihu.com)

每日论文速递:计算机视觉相关(7月6日更新版) – 知乎 (zhihu.com)

每日论文速递:自然语言处理相关(7月6日更新版) – 知乎 (zhihu.com)

NTCIR-16 参与邀请 – 知乎 (zhihu.com)

一文速览 | ACL 2021 主会571篇长文分类汇总 – 知乎 (zhihu.com)

Hugging Face官方NLP课程来了!Transformers库维护者之一授课,完全免费 – 知乎 (zhihu.com)

ICML2021论文太多看不过来?这份《一句话点评1183篇论文亮点》帮你快速找到想看的 – 知乎 (zhihu.com)

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!