文章主题:情感交流机(ECM),情感对话机器,机器人对话,共情,情感交互,情感支持,心理咨询

在”沈向洋带你读论文”的首期节目中,我们有幸邀请到了来自我国知名学府清华大学人工智能研究所的黄民烈教授,为我们深入解析情感交流机(ECM)这一前沿领域。在未来的发展中,机器人之间的对话将对用户产生何种深远的影響?在黄教授的引导下,我们将探索 ECM 研究的社會性问题,揭示情感对话的新动向。

论文链接:

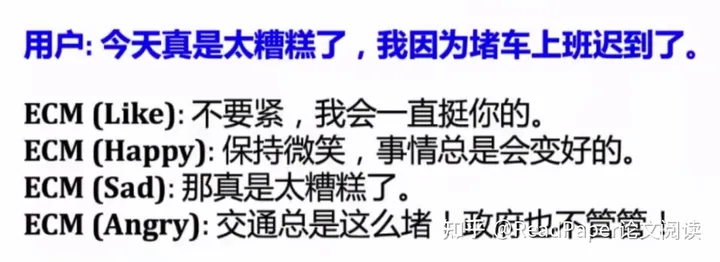

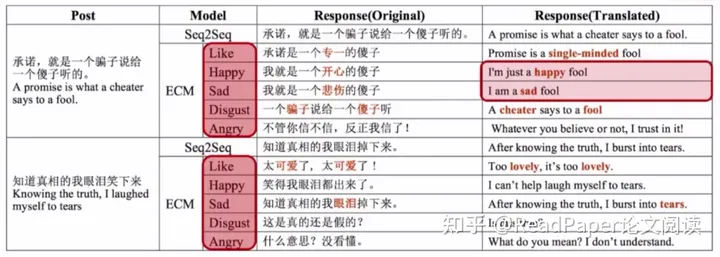

在对话系统中,情感的识别与表达起着至关重要的作用。尽管如此,目前在大型对话生成领域中,这一问题尚未得到充分的研究。本文旨在提出一种名为情感对话机器(ECM)的解决方案,它能够在内容和情感两方面生成符合规范的回复。据我们所知,这将是首个在大规模对话生成中解决情感问题的方案。ECM采用了三种机制来处理情感表达的问题:(1)利用情感类别嵌入对情感表达进行高级抽象建模;(2)通过捕捉内在情感状态的隐变来把握情感状态;(3)根据外部情感词汇显式地表达情感。实验结果表明,我们提出的模型在内容和情感两方面都能够生成合适的回复。

黄民烈:机器人到底能不能有自己的情感?

在1995年,麻省理工学院的教授Marvin Minsky就首次提出了一个观点:要制造出智能机器,必须具备情感。紧接着,MIT的教授Rosalind Picard开创了情感计算的研究领域,专注于视觉、图像和语音的情感分析。

在文本情感分析领域,美国伊利诺伊大学芝加哥分校(UIC)计算机科学系的教授刘兵堪称先驱。尽管我们在该领域也取得了一定的研究成果,但在将情感元素融入对话系统中,却在当时尚未找到有效方法。面对这样的挑战,我们开始思考一个问题:能否让机器表达各种情绪的内容呢?

这里我们举个例子,用户输入一段话,让它用不同的情感回答问题,和用户产生不同的交互。

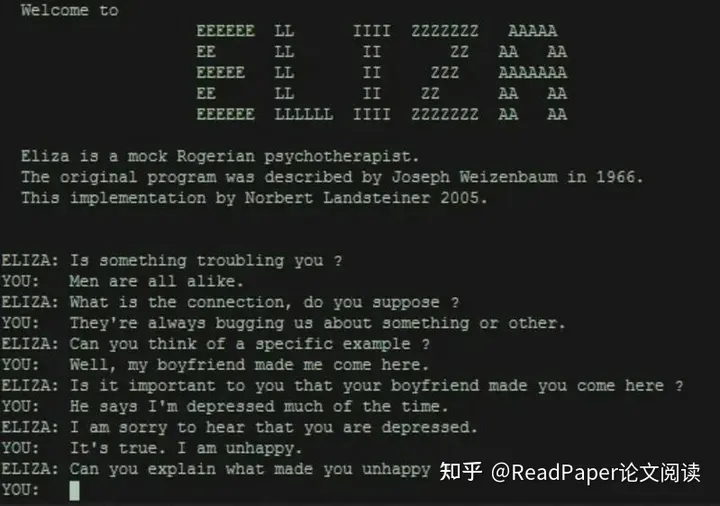

作为一名关注情感问题的人工智能助手,我注意到您提到了Minsky和Picard这两位杰出的学者,他们均在麻省理工学院(MIT)工作。在此,我想分享一个富有启示性的例子:当年MIT的一位知名教授,名叫Weizenbaum,他制造了一款名为Eliza的机器人。这款机器人不仅在当时引起了广泛关注,而且对后来的情感计算领域产生了深远影响。

黄民烈指出,如我们所了解的微软小冰,这是一款专注于社交领域的情感机器人,它能够与用户产生心灵契合,对于情感交流而言至关重要。因此,一旦技术实现更新迭代,这对于新一代聊天机器人的发展将产生极为显著的影响。

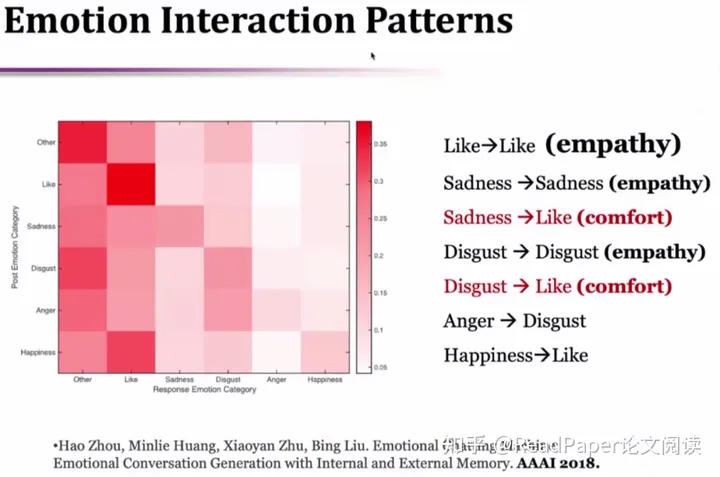

我们进一步对人类的情感进行分类,可以看出我们所谓的情感交互模式。这个模式非常有意思:在人类的对话行为里,Like -Like的概率非常高,这是一个非常典型的共情模式。

比如我跟沈老师互动,沈老师发了个特别开心的信息,那我肯定也不会扫他的兴,也会对此表达开心的情绪,这就是我们的共情;比如我今天不高兴,沈老师过来安慰我,即他会有安慰模式。

这个对角线是从输入的同一情感标签到回复的另一相同情感标签,这就是人类的交互模式,这对于我们建立起真实的共情系统是非常有帮助的。

但实际上,但凡跟情绪相关的东西都是比较复杂的。比如现在疫情大家都闷在家里,如何帮助他们做情绪支持,如何很好地去共情呢?

我们在人类行为分析发现,共情安慰也是非常好的模式。如何让计算机更好地去做共情和理解,是一个非常值得研究的问题。因为做情绪支持是非常复杂的,在心理学上有各种各样的共情理论,在心理咨询上也有各种流派,我们希望能够借鉴这些流派和思想,用计算机模型去帮助人们更好地做情绪支持。

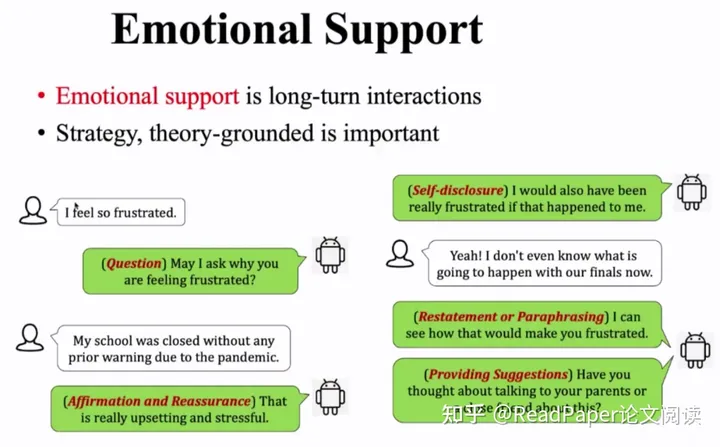

我们做了一个这样的研究:当用户表示受挫了,机器人会询问为什么受挫,同时作出安慰以及自我暴露:(如果是人的话)这件事情如果发生在我身上,我也会感到非常沮丧,到最后甚至会提一些建议。

由此对话我们可以看出,这是一个长期的交互而非单次的。而它也会基于理论去做心理咨询或心理治疗。比如深圳疫情,政府开通了很多热线,接线员是经过专业训练的,而专业训练则是建立在治疗理论的基础上。

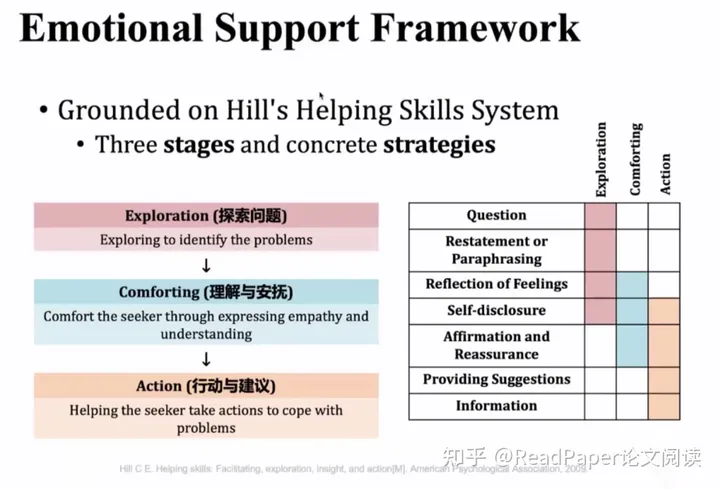

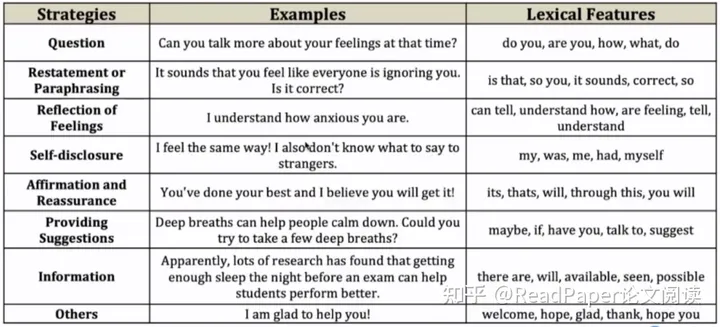

心理学有一本书叫作”Hills Helping Skill Systems”,它把有效情绪分为三个阶段,我们借鉴了该理论,对其做一定的适应和改良,最终改造为在计算机上可行的三个阶段的对话框架:Exploration(探索问题)–Conforting(理解与安抚)–Action(行动与建议),并在每个阶段定义一些策略,帮助更好地去实现该阶段的目标。

我们认为经过三个阶段的对话后,它能非常有效地帮助用户。这也是我们的一个主要思想,即借鉴心理咨询理论设计策略,通过自我暴露等方式,拉进与用户的距离。

尽管看起来很美好,但实现起来是非常难的,因为它缺少数据支撑。因此我们也做了一个数据收集以支撑我们工作,叫作emotion support conversation,这个论文发表于ACL 2022,目前我们已经对其开始有一些引用。

沈向洋:当机器人对话与人类情感一挂钩,这个问题就变得更深入了,这其中也会产生很多问题,我们以后也有更多的机会还可以进行再多的交流。我也想问问接下来科研你在产品方面有没有想法?

黄民烈:我们在做了这个工作之后,其实还是挺受鼓舞的,最近在做一些中文的尝试,希望能够把对话技术与心理咨询的理论深入结合,能真正帮助更多的人。

最近我们推出了个公众号:Emohaa,作为一个试验性的产品,它后台有对话系统,用户可以通过公众号跟它聊天。我们发现很多人知道这是个机器人,但就是喜欢和它聊天,而不喜欢跟人聊。虽然是机器人,但是它可以和用户聊得很深入,帮助用户排解无聊、孤独以及解决情绪问题。

在公众号这些对话里,很多用户是真的来寻求建议和解决方法的。但像沈老师刚才提到的,对于AI来说,这会引申出很多问题,例如伦理风险:因为AI它不知道什么建议是好的,什么是不好的。这也引申出新的研究问题,我们希望通过实际产品的尝试,不断推动我们的研究向前。

最近我们也在ACL 2022上有一篇Paper定义了一个安全基准和分类法,有助于AI分清什么样的回复是安全的,什么样的回复是不安全的。而更复杂则是伦理方面的风险,因为需要考虑到社会道德关系等等。

UW(华盛顿大学)在这一方面的工作是有的,但在AI对话方面还是比较空白,因此我们希望能把对话技术和心理咨询的一些真实的数据和场景做深入结合,真正做到为用户服务。可能在技术上还有一定的挑战,但我们有一些试验性的产品已经做出来了,所以对于这个方向我还是比较乐观的。

沈向洋:太好了,我也非常高兴你们在认真伦理方面的问题,我自己做微软小冰很多年,对此也有相同的感受,的确像你讲的,这个产品虽然对用户有很多帮助,但同时也可能还有很多潜在的问题。在设计时,和服务推出之前,这些都值得我们再认真地更多地考虑。

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!