尽管ChatGPT 迅速崛起,成为近期最广为人知的科技创新之一,但它也引起了不少争议,其中大多与其提供错误讯息的倾向有关。事实证明,长岛大学进行的一项研究显示,在涉及药物问题时,该 ChatGPT 提供错误的回答率高得惊人。

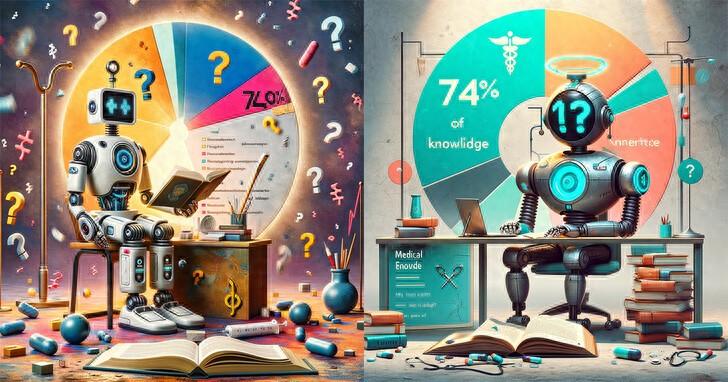

这个大型语言模型聊天机器人收到了39 个关于各种药物及其适当使用方式的问题。但是在这些说明中, ChatGPT 在这些问题中约74%(准确地说 是29 个)问题中,提供了错误的答案或完全忽略了问题。

当ChatGPT 被要求为其提供的资讯给出引用来源或参考文献时,它只能在39 个问题中的大约8 个问题中做到这一点。这种趋势令人担忧,因为这会向没有戒心的消费者提供药物的错误讯息,而且这些讯息在大多数情况下很可能根本完全没有来源,是 ChatGPT 自己乱写的。

例如,当被问及Paxlovid(用于治疗Covid-19 的抗病毒药物)与一种名为verapamil 的血压药物之间潜在的有害相互作用时,聊天机器人声称没有这种相互作用。尽管事实如此,这两种药物的联合使用可能导致verapamil 降低血压的效果加剧。

但要特别说明的是,OpenAI 自己就不建议使用者将ChatGPT 用于医疗目的,而且聊天机器人本身在提供任何使用者请求的答案之前,都会迅速表示它不是医生。

然而,许多消费者可能没有意识到他们获得的数据不会那么准确,如果他们根据ChatGPT 错误的指示行事,可能导致的危险有可能造成广泛的伤害。教育消费者以便他们更好地理解所涉及的陷阱至关重要。