文章主题:文章关键词:国外,Alex,脊髓栓系综合征,ChatGPT,医生,求医问诊,诊断,疾病,罕见病,成年人,儿童,发病率,成年人,专科专攻,全科医生,知识储备,理解能力,逻辑思考,信息整合,加工能力,甄别信息来源,真伪与好坏,误导性信息, false information, 智能起点,自我认知,辅助,智能助手,医学领域,临床经验,智能报道,体育消息,文笔,项目关停,关键禁果,自由意志,自我意识,全知全能,高级智能,悖论,初级产品,演化。

ChatGPT能看病了?

在海外,一位名叫Alex的年轻人长期遭受一种神秘疾病的困扰,已经持续了3年的时间。在这段时间里,他的家人带着他四处寻求医疗帮助,寻求解决他身体疼痛的方法。然而,无论是哪种治疗方法,都无法准确地找到病因,导致他的病情始终无法得到根治。

在某一天,男孩的母亲尝试在网上寻找ChatGPT的援助。她详细描述了孩子所表现出的各种症状,然而,ChatGPT却提供了一个母亲从未听说过的新答案——脊髓栓系综合征。

在之后的时间里,母亲携手孩子以及由ChatGPT生成的答案,再次踏上了寻医之旅。经过医生的详细检查和对比分析,这位医生最终确认了男孩患上了一种疾病。

而此时,男孩先后看过的医生已经有18位了,都没有诊断出这种稀有的疾病。

这件事一出来,便引起了网民的热烈讨论。

有其他人有分享了自己的亲身经历,或是给人看病,或者是给宠物狗问诊,ChatGPT都能给出令人满意的答案。

就连马里兰大学医学院的研究人员,也曾以研究的形式问诊ChatGPT。研究人员问了它二十多个关于乳腺癌以及筛查等相关问题,它的回答经过专业人员的评估后,发现其中88%的内容都是恰当的。

甚至于ChatGPT的升级版GPT-4,据说此前在试验中,还通过了美国职业医师考试。

从这些情况来看,似乎ChatGPT坐堂问诊已指日可待。不过也有些人对它的表现持有怀疑态度甚至不屑一顾:只要吸取的信息和知识够多,完全能做到瞎猫撞上死耗子。

ChatGPT会看病的原理是什么?

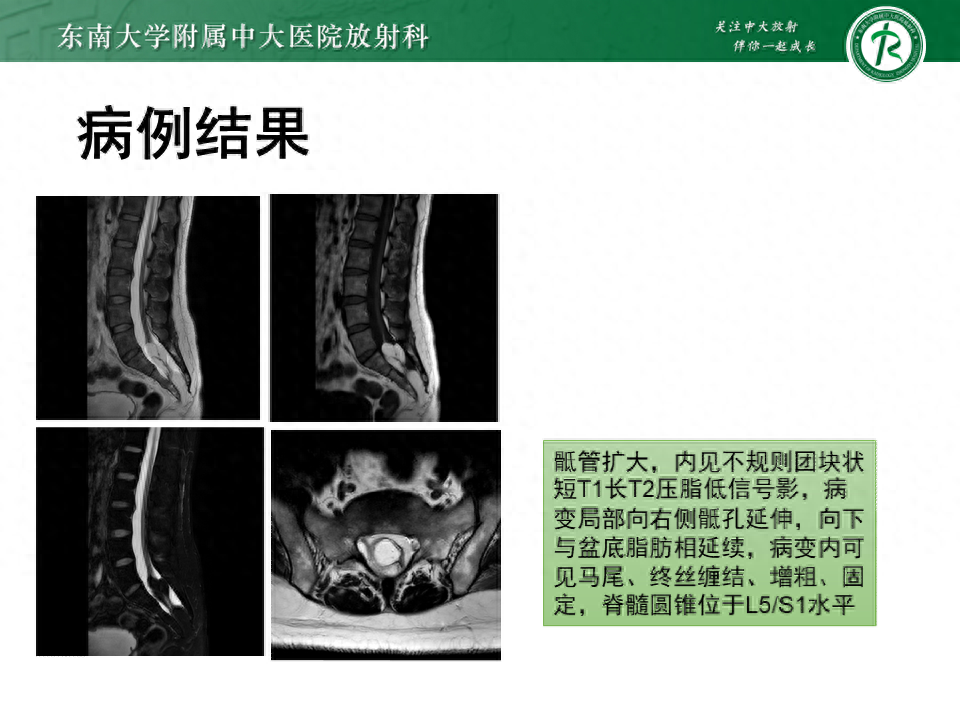

以Alex为例,他所患的脊髓栓系综合征是一种较为罕见的疾病,它在成年人群中的发病率相对较低,通常局限于儿童群体。据统计数据显示,该疾病的患病率大约在0.005%到0.025%之间。

在医疗领域,由于某种疾病的发生率极低,医生通常不会将其与患者联系在一起。更为重要的是,现代医疗体系以专科专攻为核心,各个科室的医生都具有自己独特的主攻方向,没有全科医生的存在。这样的体系旨在确保患者得到最专业的治疗,从而提高治愈率。

当面对那些较为罕见的疾病时,医生可能会感到力不从心,这是非常正常的。然而,ChatGPT却可以发挥其优势,因为它具有无限量汲取人类现有知识的能力。换言之,ChatGPT可以通过对大量病例的学习,积累丰富的经验,从而更准确地诊断疾病。这种基于理解的诊断方式,正是ChatGPT所擅长的。

GPT, or Generative Pretrained Transformation Model, is a highly advanced language generation technology that sounds complex but has a simple underlying principle. The name “Chat” refers to the act of communication, while the acronym “GPT” stands for its English translation: Generative Pre-trained Transformation Model. In essence, GPT is a sophisticated model capable of generating coherent and contextually relevant text based on its extensive training data.

依据基本原理,各类知识只有在与之建立联系后,通过不断语言学习和语法训练,才能够对人类文本信息产生理解和认知。换言之,ChatGPT的理解能力和现有知识储备,都取决于人类为其提供的知识数量。

至于看病和问诊,实质上就是把它知道的答案呈现了出来。所以,这就跟人们在互联网搜索各种知识点是类似的。

不同的是,传统互联网只会呈现出一个答案,不能汇总也做不到融汇贯通,一切要搜索人自己去查找和理解。

而ChatGPT借助于训练出来的理解能力,不但能将相关答案呈现出来,还能做到以它自己的理解来输出全新的内容。

相比于传统的互联网搜索,这肯定算是进步了太多。但是,由于ChatGPT的所谓理解能力还相当原始,有时候它所呈现出来的答案也可能是错误的。

除此之外,它目前还做不到脱离人类现有的信息,去主动思考和生成新的内容。说白了,它所有的知识输出,都建立在人类现有的基础之上。

你问它一个关于外星人的问题,它绝对回答不出来什么新鲜的颠覆人类认知的内容。

一切取决于现阶段人类的内容“投喂”

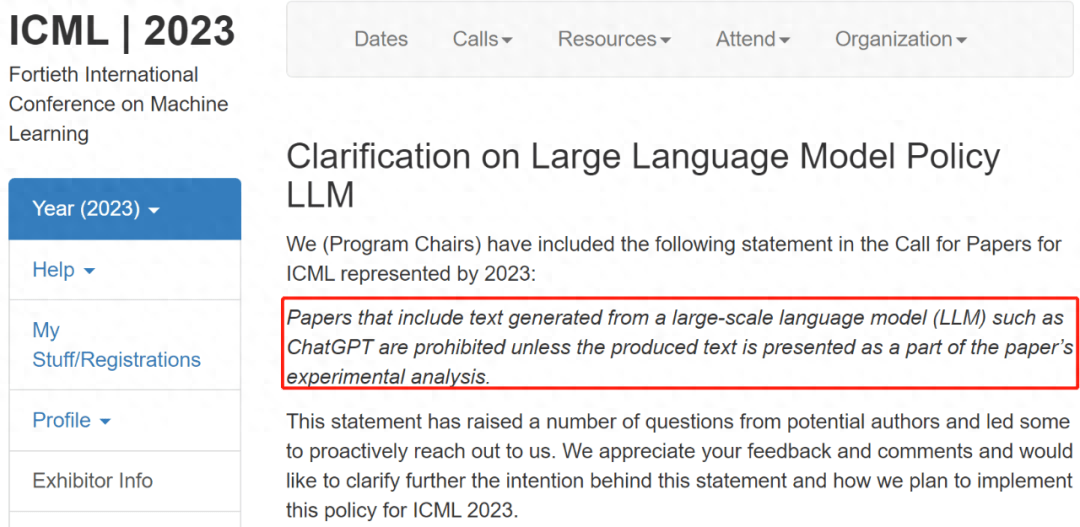

吕海龙是精神卫生科的医生,今年初的时候,他和浙江大学一附院的团队成员做了一个实验。研究人员让ChatGPT参加了一场中国执业医师的考试。

参与实验的ChatGPT,其所掌握的数据信息,是2021年之前训练得出来的,相关考题则是2020年执业医师考试的试题。

综合来看,一张满分100分的试卷,ChatGPT的成绩只有57分,连及格线都没有达到。

从具体的类型来看,很多基础性的医学类知识,ChatGPT都回答错了,吕海龙和团队成员猜测,最大的原因可能是此前它从网上获取的信息就是错误的。

对比之下,一些需要逻辑思考的实践题,它回答的还算不错,但这类问题在实验中,给ChatGPT设置的前提条件也很充足。

一旦某些问题设置的信息有缺失,它要么回答不上来,要么就是给出答非所问的答案。所以这也能看出来,在逻辑思考上,ChatGPT基本上还不会思考,跟不会像人类一样去运用猜测和联想。

说白了,现阶段的ChatGPT就像一个刚上学的儿童一样,完全依赖人类的信息投喂,给它提供什么内容,经过对话训练后它就输出什么内容。

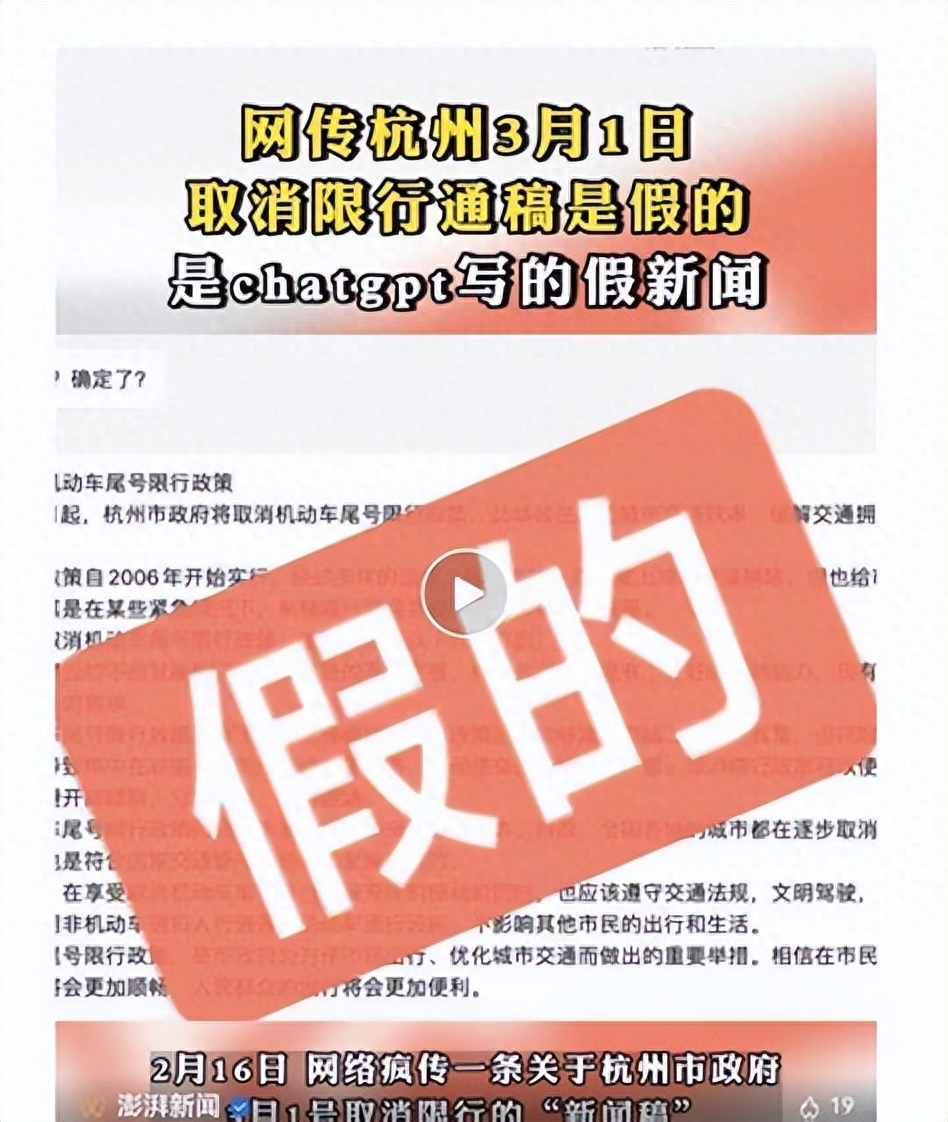

不过,虽然完全依赖人类的投喂,它的信息整合和加工能力还是具备的。这样一来实际上就产生了另一个问题,即它做不到像人类一样去甄别信息的来源,更做不到去分辨信息的真伪与好坏。

在此前国外的相关训练中,一旦研究人员给它提供有争议性的甚至错误的信息,ChatGPT整合输出的内容就完全是胡言乱语。

尤其是给它提供一些明显错误其误导性的信息后,它能很快整合生成一篇新的内容,从人类的角度去判断,新输出的内容看起来真实可靠,可实际上是彻头彻尾的假信息。

难怪一些互联网公司的高管们对ChatGPT将来的运用持悲观态度,因为利用它将能传播大量错误的信息。

马里兰大学医学院在此前的研究中也发现了这一点,ChatGPT会编造一些完全不存在的期刊文章,还会伪造所谓的第三方权威机构来支持某种观点。

这些内容,有时候非专业人员根本分辨不出来,即便是一些专业人士,也需要经过仔细的甄别才能发现问题。

研究人员猜测,ChatGPT并没有故意造假的企图,它只是依据自身的文本内容储存,再根据与人类的对话训练,进而会依照自身的逻辑判断来整合和输出信息。

换句话说,它没有人类的意识思维,只是在简单模仿和套用人类输出内容的格式模块。

如此一来,即便有时候ChatGPT给出的答案建议是正确的,但不能保证它给出的所有答案都是正确的。

所以在医学领域,国外的一些研究人员不建议患者通过ChatGPT问诊,而应该去看医生。

这就又回到原来的问题了。

现阶段ChatGPT能胜任医生的职务吗?

吕海龙和团队在实验后,基于ChatGPT的实际表现,他认为在未来的医学领域,类似ChatGPT这样的AI产品,应该变成一个庞大的知识库。

在基础类的医学知识上,如果能做到百分百的正确,就能成为医生很好的助手,可以随时随地辅助医生提供大量正确的建议。吕海龙还希望,未来的发展中它的答案还应该明确标定出处,比如是某本书籍,或者是互联网等。

当然,也有医生认为,ChatGPT光做一个知识储备库太过于浪费,凭借其越发强大的整合能力,未来的临床医生,其实也可以将大量的临床经验传授给AI产品,这样和它自身储备的大量知识相结合,给人看病就不再是梦想了。

有医学领域的专家认为,未来的ChatGPT最好能用声音和人类交流,通过不断向患者提问来积累临床经验,这样或许能做出新的医学判断,给出新的经验来。

但这一切都基于未来的发展,目前ChatGPT还达不到这样的水准。相关产品的记忆、计算、逻辑判断以及推理等可能与人脑持平甚至超过了人类,但是智能的起点,也就是自我认知的能力,目前的AI产品没有,而且也模拟不出来。

所以就现在的情况来看,ChatGPT还做不到独立给人看病,它最多只能作为辅助,成为医生在临床上的一个智能助手。

至于文章开头的案例,那不过是它基于海量的储备知识,正好给出了一个准确的判断。但是个案不能代表全部,尤其在医学领域,个案更不能代表普遍的临床实践。

当然在医学领域之外,也有诸如教育、新闻等行业,试图训练和利用ChatGPT做出某种突破性的改变。不过整体看来,目前都还位于起始点,颠覆性的突破还没有出现。

结语:人类跟得上ChatGPT的变化吗

前一段时间,据说一家美国的媒体,曾利用ChatGPT代替人工报道体育方面的消息,然而在用过一段时间后,它写出来的新闻要么错误百出,要么不知所云,文笔和人的文笔比起来更是味同嚼蜡。最后不得已只能将该项目关停。

这就是将ChatGPT投入到实际产业中一次失败的尝试。

诚然,ChatGPT的优势肉眼可见,但是它的短板也相当突出。归根结底,没有判断能力就不存在认知能力,既然没有认知,它所有的知识储备就都是“死”的,无法真正像人类这样将其串联起来。

至于这种关键的改变何时会发生,目前人类自己也不知道。就像宗教传说中那样,亚当和夏娃,最早也是吃了禁果之后,才产生了自由意志和自我意识。

同样,目前ChatGPT这样的AI产品,它们缺少的就是那颗最关键的禁果。现有的人类科技水平,同样不清楚这样的变化将会带来什么。

现在对于ChatGPT的研究,都是建立在它还没有自我认知的基础上的。大量的实验以及相关的训练,都是想把它变成全知全能的人类助手。

可从本质上来看,这里面可能存在一个悖论,假如未来的AI产品真做到了全知全能,你觉得它不会演化出自我认知吗?

如果脑洞开的再大一点,现今ChatGPT这样的初级产品,又何尝不是在人类的调教下,一步步的演化呢?人类又如何能分辨出来,它不是对自我的认知进行了掩藏和修饰呢?

既然要赋予其智能,既然想创造出新的智能,这些情况就不可能不会出现,一切只不过是时间问题罢了。

当然,现在还没有到达那种地步,ChatGPT还是既聪明又蠢萌的聊天工具。未来它在变,人类也跟着改变认知才行。

参考资料:

《ChatGPT能看病吗?医生出了一百道单选题,它没及格》 澎湃新闻 2023年2月22日《是“公平台”还是“狗屁通”?ChatGPT真的“无所不知”吗?》 大象新闻 2023年2月10日《国产医疗版”ChatGPT”来了,能给我们看病吗?》 南方日报 2023年2月10日

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!