文章主题:关键词:情绪化商业模式, 用户体验, 情绪识别, AI

人工智能现在已经可以比人类更好地辨别情绪,或许是时候让AI产生“情感”了

未来的商业模式将会变得越来越“情绪化”。

对于产品设计来说,用户体验是至关重要的考虑因素。

因此很多产品的用户界面开始加入可以检测用户情绪状态的功能,并且在与用户交互时使用模拟情绪。

🌟预测未来,Gartner在年初揭示了科技巨变的惊人一幕——四年之内,你的设备将成为情感生活的私人助理,深度理解你的情绪波动。🌍这不仅仅是一个概念,它象征着人工智能与个人生活的无缝融合,让科技更加贴心、智慧。👨👩👧👦想象一下,未来的家居、汽车或穿戴设备能通过细腻的分析,感知并回应你的内心世界,那份无微不至的关爱,超越了传统的家人角色。💻🚀这样的未来,无疑将开启一个全新的数据驱动的情感交流时代。

https://www.gartner.com/newsroom/id/3843263🌟人工智能并非仅限于棋盘上的胜利,它正悄然渗透到我们生活的方方面面。💡从自动驾驶汽车到智能家居,AI的进步让科技与生活无缝对接。🔍无论是医疗诊断的精确度提升,还是金融风控的智能决策,AI都在以惊人的速度改变着我们的世界。🌍未来,AI将引领一场深刻的数字化革命,让创新无处不在。🌐别再仅仅关注那些耀眼的胜利,让我们一起探索这个充满无限可能的技术领域!📝

但在“情绪”,这一人类曾经认为是自己独有的领域,AI同样取得了进展。

🎉人工智能的进步🚀让情绪识别不再停留于基础的几种情感,如开心、惊讶、愤怒、悲或惧,而是跨越了界限,深入到更为细腻的情感世界。现在,AI已经能精准捕捉并理解诸如”愉快的惊讶”、”愤怒的意外”以及那令人敬畏的复杂情绪。这种技术的精确度和深度,无疑正在为我们的交流体验带来革命性的改变。🌍

心理学家认为人类有27种不同的情绪。

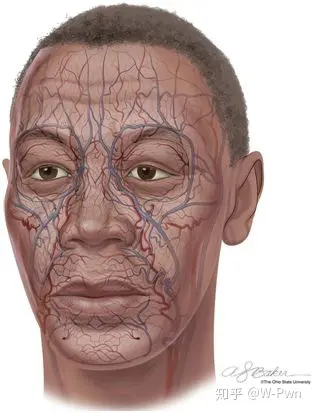

https://psychcentral.com/news/2017/09/08/new-study-emotions-abound-with-27-different-varieties这个由俄亥俄大学开发的情绪AI,可以根据照片中的面部表情识别21种情绪;

更令人震惊的是:该系统在检测这些情绪时比人类更准确。

机器识别情绪的基本原理是依靠识别面部肌肉运动以及由面部血流变化所引起的面部颜色变化。

这两者都与由情绪引发的神经活动相关。

【研究解说视频】:

原文改写:🌟面部情绪专家保罗·艾科曼的经典之作,1971年的里程碑论文”Faces and Emotions Across Cultures”揭示了惊人的真相——🌍无论在何处,人类的情感表达都有其不变的规律。他的研究深入探讨了这些普遍的”常数”,为理解跨文化交际中的非言语信号提供了坚实基础。📚通过艾科曼的研究,我们认识到面部表情并非孤立存在,而是连接全球情感语言的桥梁。🏆他的工作不仅改变了心理学界,也对SEO优化产生了积极影响,让世界更好地理解和利用这些微妙的视觉线索。记得关注情绪与文化的细微互动哦!😊

🌟无论国籍种族如何交织,人类的情感共通性犹如一座无形的桥梁,跨越语言与文化的界限。每一种情绪,不论是喜悦、悲伤还是愤怒,都在全球范围内以相似的肢体语言和微妙的表情表达,形成了一套通用的视觉密码。🌍这份普遍的情绪共鸣,是我们的共同人性在多元世界中的生动体现。🌈

因此,或许让机器产生情绪很复杂,但让机器识别情绪,并模仿情绪,仅仅是“学习”的问题。

情感是沟通的必要条件

有一种普遍的误解是:人类的话语内容是我们交流的总和。

事实上,不只是语言,人类还在用声音语调、面部表情、手势和肢体语言等进行交流。

这就是为什么电子邮件充满了误解的可能性。如果没有非语言暗示,大部分意图都会丢失。

💻🚀 计算机进化史上的不朽定律:强大愈演愈烈,其核心使命愈发聚焦于优化人机互动体验!隨著技术日新月异,从最初的简单运算到如今的智慧中枢,每一次飞跃都伴随着对人性化设计的深度挖掘和提升。👩💻👨💻从早期的命令行界面,到如今的语音助手、虚拟现实,计算机系统不断以创新的方式缩短人与机器的距离,让交互变得更加直观、便捷。透過人工智能和自然语言处理的进步,它们理解并回应我们的需求,仿佛拥有超乎想象的心灵力量。🔍🤖不仅如此,强大的计算能力还驱动了跨平台应用的发展,打破设备界限,实现无缝连接,无论是在家里还是办公室,或是移动的旅途中,我们都能享受到个性化的服务。💻📱在这个数字化时代,人机交互的质量已成为衡量技术成功与否的重要指标。每一项突破都标志着人类与科技共生的又一里程碑,让我们期待未来计算机如何以更人性化的方式,进一步丰富我们的生活和工作。🏆🌟

人与计算机第一代“交互界面”是开关、打卡和磁带,人类必须通过非常复杂的步骤才能转化成计算机的二进制语言。

但随后的快进命令行,GUI,口语界面,每个进步都是让机器与人的交互变得更加容易。

不过今天的口语界面还不够好,因为基本上它们只是处理单词,而不是非语言提示。

当你与虚拟助手交谈时,你的口语单词将转换为文本,并且是“公文化”的文本,你交谈时的声音语调、表情、肢体动作等这些信息都不会包括在内。

情感AI最大的好处是人机交互将越来越多地涉及口头和非口头交流,这将提升双方的理解。

或许不用多久,Siri(苹果)、Google Assistant(谷歌)、Alexa(亚马逊)、Cortana(微软)、小爱同学(小米)等虚拟助手都将会根据用户的情绪不同而做出不同反应。

在智能手机硬件创新乏力的今天,越来越多地公司也会开始想方设法筑起一道软件的护城河。

一个能理解你情绪并给你安慰的语音助手应该会是一个大的突破。

未来与手机谈一场“恋爱”也不是梦。

“情绪”在商业上的应用

可以检测和模拟人类情感的AI,将改变客户服务、虚拟助手、机器人、工厂安全、医疗保健、运输等领域。

Frost&Sullivan进行的一项Cogito调查显示,93%的受访者表示,良好的客户服务互动将有益于公司的形象。

Cogito的AI软件基于麻省理工学院人类动态实验室的行为科学研究,可以分析客户的情绪状态;

并为人类呼叫中心代理提供即时反馈,使他们能够更轻松地与客户实现“共情”,进行交流。

Affectiva和Realeyes等公司提供基于云的解决方案,使用网络摄像头跟踪面部表情和心率(通过检测面部皮肤的变化)。

一种用途是市场调查(在消费者观看广告时,该技术可以检测他们对广告中的图像或文字的感觉)。

这些公司也正在寻求扩展到其他领域,例如医疗保健,即使病人没有正确表达,自动呼叫中心也可以通过声音检测出他的痛苦或抑郁。

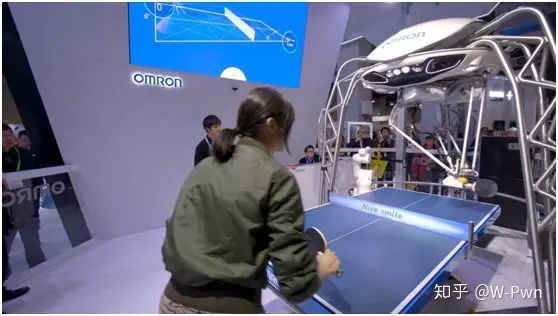

由日本欧姆龙自动化公司创建并于今年CES上展示的一台名为Forpheus的乒乓球机器人;

其乒乓球技能的一部分是它能够阅读肢体语言,以确认其人类对手的情绪和技能水平。

而与人类一起协作的工业机器人,“识别情绪”可以提高生产力和安全性。

例如,通过阅读工厂工人的肢体语言,工业机器人可以预测人们可能会如何以及在何处移动,判断他们的工作转态,提前预警危险。

旗瀚科技的Sanbot,软银的Pepper和本田的3E-A18等机器人作为移动信息亭,部署在机场、商场、酒店等服务区域。

它们的构建是为了理解和模仿人类的情感,这些机器人可以阅读肢体语言、语音模式和面部表情,以弄清楚用户的感受,或用户是否感到困惑,为他们提供更加满意的答案。

情感检测的另一个主要且显而易见的应用是汽车和卡车。

通过在仪表板、座椅或安全带中使用生物识别传感器和摄像头,车载AI可以判断驾驶员是否有压力或驾驶时太累,以减少事故的发生。

目前福特汽车正在与欧盟合作开发这样一个系统。

情感AI将最先用于消费领域和公共领域

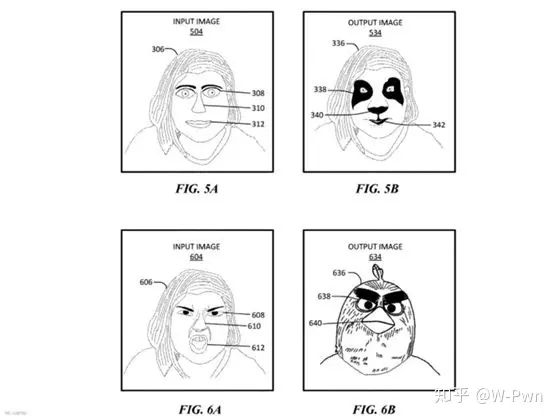

Facebook最近获得了“情绪检测自拍滤镜”的专利。

这个想法是根据照片中检测到的情绪自动选择合适的自拍“面具”。

例如,如果自拍者看起来很悲伤,则过滤器默认为卡通泪滴;如果看起来很开心则会得到“Happy Panda”。

一款名为Nevermind的视频游戏使用生物反馈来检测玩家的情绪并相应地调整难度级别(来自Affectiva的技术)。

如果你觉得它很贴心的话估计要失望了;

它的设定是玩家越害怕难度就会越高!

“监控舆情”的利器

上面只是在一些小程序上的应用,估计已经有人想到这个东西会是“监控舆情”的利器。

在英国,政府正在使用一项名为G-Cloud 10的服务,由FlyingBinary和Emrays专门开发,根据社交媒体帖子和评论来检测网民们的情绪。

今年3月份,国内的一所学校在教室里安置了一款特制摄像头,使用人工智能来监控所有学生的情绪状态,评估学生的注意力。

更多的不能再说了。

但可以预见,情绪AI将有非常广的商业应用前景(至少会成为男生谈恋爱的必备系统);

而对于公共部门,“理由”就更多了。

写此文时,想起鲁迅先生的一段话,或许不相关,仅摘录于此:

楼下一个男人病得要死,那间壁的一家唱着留声机,对面是弄孩子。墙上有两个人狂笑,还有打牌声。河中的船上有女人哭着她死去的母亲。

人类的悲欢并不相通,我只是觉得他们吵闹。【推荐阅读】

欢迎关注我们:

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!