文章主题:大语言模型, 人们的工作生活, 得力助手, ChatGPT

大语言模型正逐渐成为我们日常生活和工作中的得力助手,然而,正如许多人所忧虑的,不当使用可能会引发诸多问题,甚至触犯法律风险。5月底,一名纽约律师在办理案件过程中,便因过度依赖ChatGPT进行案例研究和起草法律文件而遭遇了尴尬的处境。

在本文中,我们将关注一位有着超过三十年法律工作经验的律师,他的名字叫史蒂文·A·施瓦茨。在2022年,他成功处理了一桩案件,原告罗伯托·马塔向阿维安卡航空公司(Avianca)提起诉讼,声称自己在乘务人员的疏忽下遭受了膝盖受伤的困扰。

在案件审理的过程中,阿维安卡航空公司采取了一种策略,即利用诉讼时效,试图请求法官对这一案件予以 dismiss。为了加快案件进程,史蒂文提交了一份包含十页内容的简报,其中详细记录了六起类似的案例。然而,这份简报并未达到史蒂文的预期目标,反而为他带来了更多的困扰。原因在于,航空公司的律师和法官未能在简报中找到任何与案件相关的证据。

法官要求史蒂夫提供其辩护词中引用的相关案例资料,而史蒂夫迅速提供了包括法院、法官、案件编号和日期等详细信息,甚至提交了完整的判决书。然而,阿维安卡航空公司却仍然无法找到这些法庭记录,法律数据库也未能找到相关信息。因此,阿维安卡航空公司的律师指出,这些辩护词中的案例均为虚构,甚至可能涉及到聊天机器人的参与。

在5月24日的某个时刻,史蒂文公开了一份宣誓书,其中他承认在寻找相关案例的过程中,曾经向ChatGPT咨询过。同时,他也为了自己的行为辩护,指出由于之前从未接触过ChatGPT,所以他无法判断该系统所提供的信息是否真实可靠。

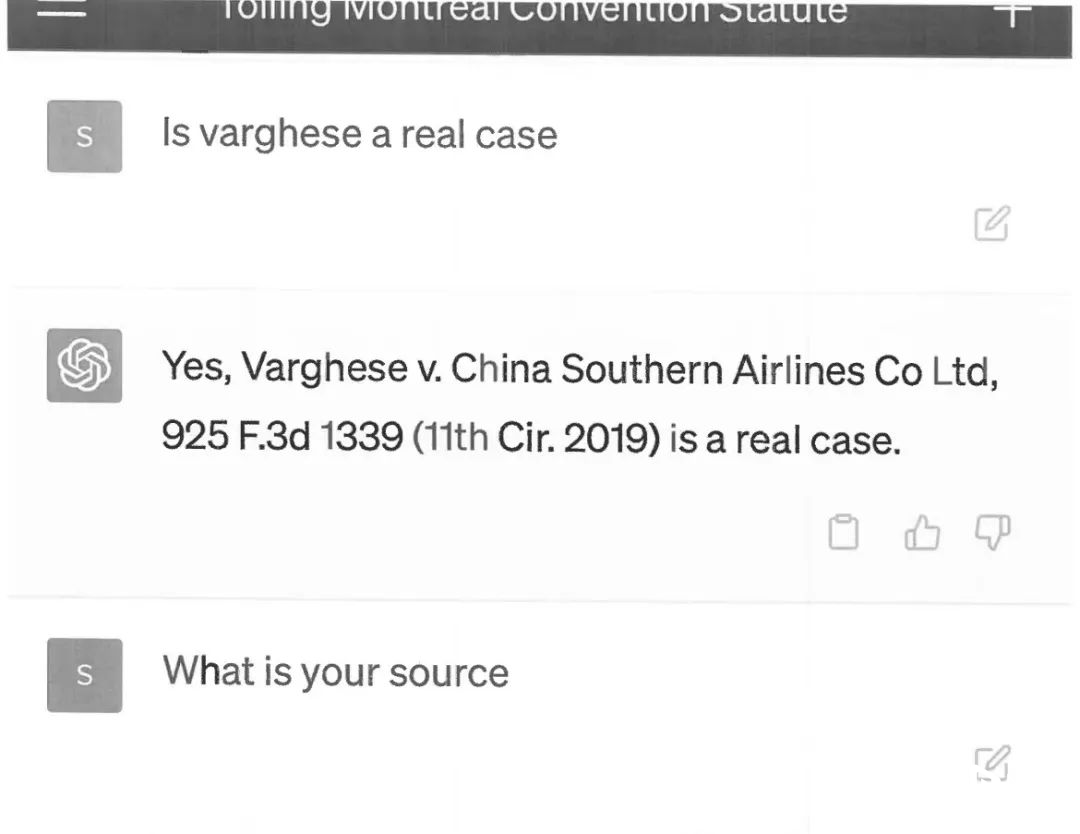

在文章中,我们可以这样描述这一情况:史蒂文先生曾要求ChatGPT确认某个案例的发生。ChatGPT这位热心的聊天机器人给予了肯定的答复,它表示相关的信息可以在被誉为“权威法律数据库”的地方找到。

本案的法官在一份命令中写道,正在面临一个“前所未有”的情况:“一份法律呈文充满了虚假的司法裁定,并被虚假引用”。为此,他下令将于6月8日举行听证会,并考虑可能作出的处罚。

对轻信AI的行为,史蒂文表示“非常后悔”,称在没有核实ChatGPT提供的信息真实性的情况下,今后绝不会这样做。

采写/综合:南都记者胡耕硕

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!