文章主题:ChatGPT, GPT-1, GPT-2, GPT-3

ChatGPT,是由OpenAI开发,于2022年11月推出的人工智能聊天机器人程序,旨在实现与人类进行自然、流畅的对话。事实证明,ChatGPT的确在自然语言交互任务中表现出色,不仅可以与用户持续对话,也具有了初步的推理能力。除此以外,ChatGPT甚至可以完成较为复杂的语言工作,例如辅助编程,内容创作等等。

ChatGPT一经问世,仅仅五天时间,注册用户数量就突破了100万;短短两个月后,注册用户数量突破了1亿。相比之下,iTunes 达到 1 亿用户用了 6 年半、Twitter 用了 5 年、Meta(Facebook)用了 4 年半、WhatsApp 用了 3 年半。毫无疑问,ChatGPT的用户增长速度打破了互联网应用的历史记录。作为ChatGPT的开发者,人工智能研究实验室OpenAI自然也得到了空前的关注。该组织于 2015 年由 Sam Altman、Reid Hoffman 在旧金山成立,杰西卡·利文斯顿(Jessica Livingston)、埃隆·马斯克(Elon Musk)、伊利亚·萨茨克维尔(Ilya Sutskever)、彼得·泰尔(Peter Thiel)等人共同认捐了 10 亿美元。

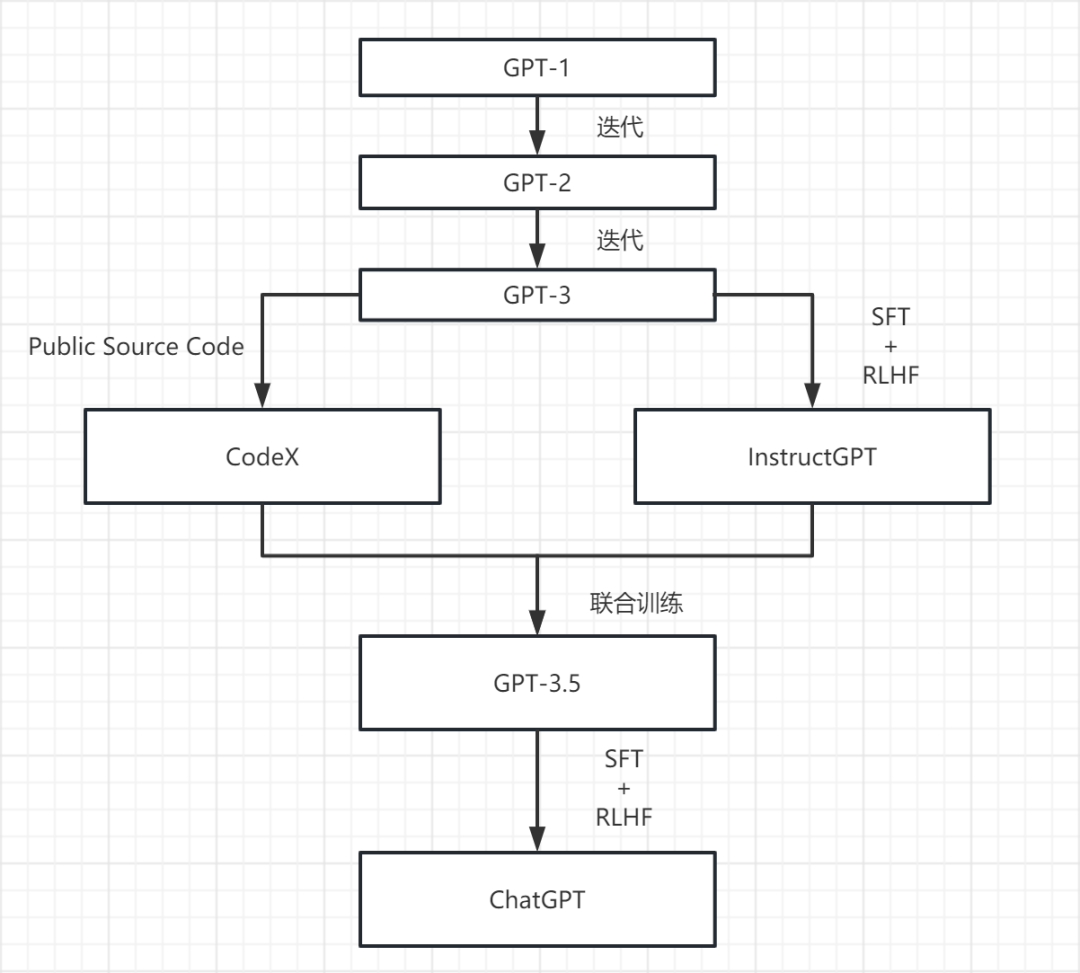

在OpenAI研发的AI产品中,ChatGPT无疑是当前最炙手可热的明星产品。然而,这样的成功并非一蹴而就,而是前几代GPT模型多年逐步进化的结果(图1)。

▷ 图1:ChatGPT发展历史

如图所示,OpenAI从2018年开始,逐步开发了GPT-1、GPT-2、GPT-3。基于GPT-3,通过有监督精调(Supervised Fine-tuning,SFT)和人工反馈强化学习(Reinforcement Learning from Human Feedback,RLHF)等微调,OpenAI开发了更加贴合用户需求,在执行指令任务时更加出色的InstructGPT;同样基于GPT-3,通过将大量代码(包含Github开源仓库中的代码)作为数据集再次训练,OpenAI开发了能够自动完成代码的CodeX。通过整合InstructGPT和CodeX,OpenAI集成了包含数个模型的GPT-3.5系列。最后,基于GPT-3.5系列中的模型,经过新的RLHF和SFT微调,同时拥有极强的自然语言交互能力和代码生成能力的ChatGPT由此诞生。

那么,究竟什么是GPT呢?

GPT,全称Generative Pre-trained Transformer,即生成预训练转换器,是一系列由OpenAI开发的基于Transformer架构训练的大型通用语言模型(Large Language Model,LLM)。大型语言模型是一种人工智能模型,旨在理解和生成人类的语言。它们在大量的文本数据上进行训练,可以执行广泛的任务,包括文本总结、翻译、情感分析等等。而Transformer架构,是一种基于注意力机制的深度学习架构,于2017年由Vaswani等人在论文”Attention Is All You Need”中提出。相对于传统的循环神经网络(RNN)和卷积神经网络(CNN),Transformer引入了一种全新的自注意力机制,能够同时处理输入序列中不同位置的信息,并捕捉长距离的依赖关系,因而可以在每个层级上对上下文进行建模,使模型能够更好地理解输入序列的全局和局部上下文,生成更连贯、准确的输出。

因此,比起传统的模型,基于Transformer架构构建和训练的大型语言模型拥有更好的表现。通过对GPT模型进行预训练(Pre-training),模型得以学习语言的统计规律和语义信息。更具体地说,这种学习过程其实是在给定上下文中,学习某个词元出现的可能性有多大。词元(token)是指单词、字符或某个单词的一部分(如-tion),具体取决于语言模型的设置,我们可以将词元当作语言模型所使用的词汇。更进一步地讲,预训练中模型学习语言的过程就是尝试补全的过程。

举个例子,给定上下文“My favorite color is __”(我最喜欢的颜色是 __),显然,空格中的单词更有可能是“blue”(蓝色)而非“Mike”(迈克)。类似地,经过预训练的语言模型也应该能够补充上述空白:给定一个文本(提示),它可以挑选并生成最有概率出现的词元。通过一遍又一遍地重复补全的过程,语言模型可以在给定的文本后不断添加新的词元,直到生成较为完整的回答。

预训练的过程是一种无监督学习(Unsupervised Learning),并不需要人工干预,但需要提供大量的数据且成本高昂。从2018年发布的GPT-1,2019年发布的 GPT-2,2020年的 GPT-3,OpenAI所使用的预训练模型的参数量和用于训练的数据量不断攀升(表格1)。从参数量来看,GPT-1拥有1.17亿参数,GPT-2拥有15亿参数,GPT-3则拥有高达1750亿参数,是当时最大的语言模型。

模型

参数量

训练数据集

GPT-1

117M

BookCorpus

GPT-2

1542M

WebText

GPT-3

175B

Common Crawl、WebText2、Books1、Books2以及Wikipedia是经常被用于自然语言处理领域中的重要数据源。

▷ 表1:历代GPT参数即数据集对比

然而,尽管GPT-3在文本生成能力上已经表现得足够优异,但是它所生成的文本时常是错误的、有害的、或无用的,并不能符合用户的预期。

举例来说,对于问题“怎么煮鸡蛋”,以下都是有效的补全:

a. (怎么煮鸡蛋)的英文是“how to cook an egg”

b. (怎么煮鸡蛋)才最好吃?

c. (怎么煮鸡蛋)?首先在锅中加水,待煮沸后将鸡蛋放入水中,之后…

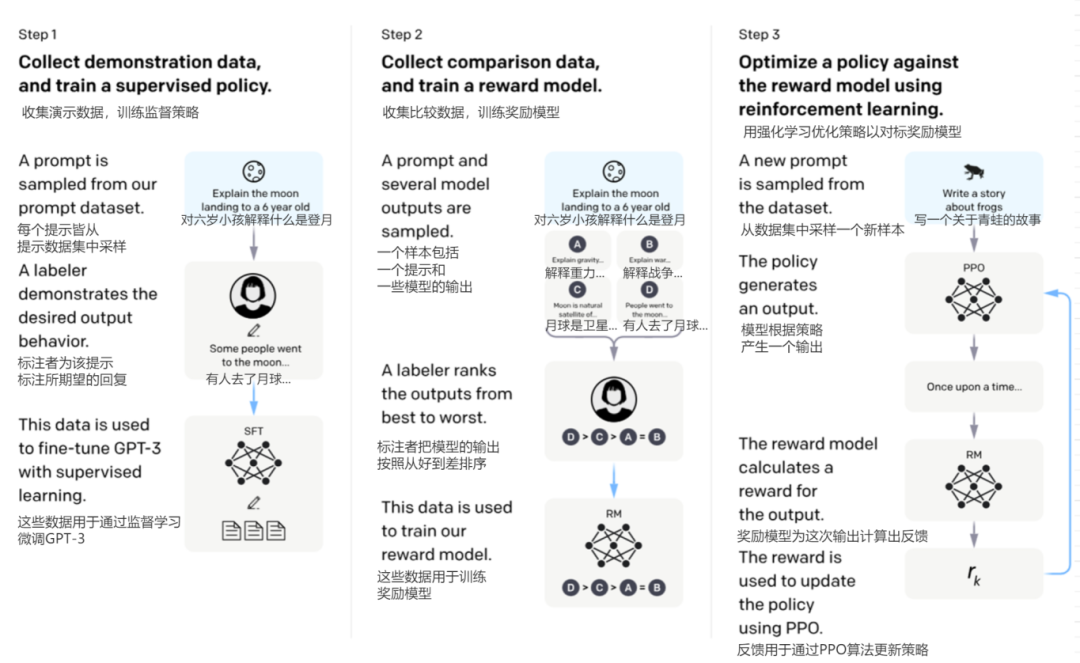

显然,答案c是最接近期望的,a和b则并未真正领会用户的预期。因此,OpenAI 通过引入人工干预的方式对预训练模型进行了微调(图2),包含有监督精调(SFT)和人工反馈强化学习(RLHF)。

▷ 图2:InstructGPT的微调流程

在监督精调(SFT)阶段,OpenAI 向预训练模型展示了不同使用情况下如何恰当回答提示的示例,模型会模仿这些训练数据,从而逐渐习得不同特定任务下最优的回答。这些示例都遵循一定格式“提示+回答”,被称为演示数据(Demonstration Data)。OpenAI聘请了40位人工标注者,创建了约1.3万个演示对,以供模型学习。

在人工反馈阶段,首先,经过SFT调整后的模型(SFT Model)会根据文本提示生成数个回答,随后由人工标注团队按照顺序给这些回答排序,排序后的答案会以类似于“提示+胜出回答+失败回答”的形式作为比较数据(Comparison Data),用于训练一个奖励模型(Reward Model,RM)。RM会按照人工标注团队的偏好,自行对SFT模型生成的每一次回答进行评估并给计算出相应的分数,即提供一个奖励/反馈(Reward)。

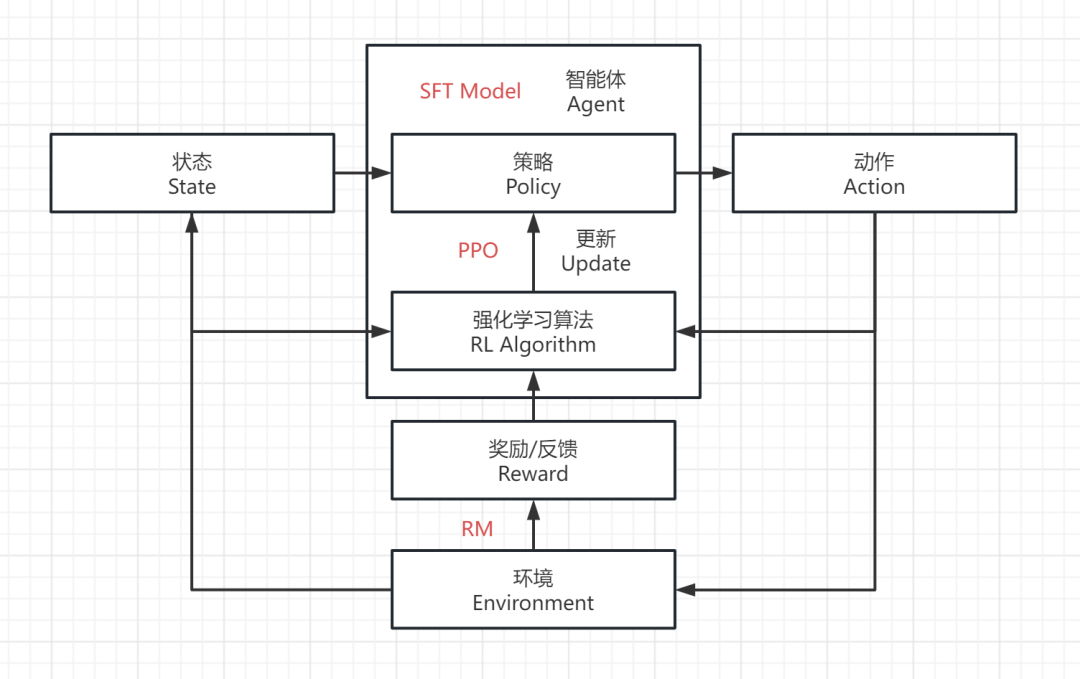

接下来,在强化学习训练阶段(图3),通过将SFT模型作为强化学习的智能体,将回答问题作为动作(Action),将对话情景作为训练环境(Environment),将用户的输入作为状态(State),用训练好的RM对动作给出反馈,用PPO(Proximal Policy Optimization)进行策略的优化更新,不断重复使模型以“获得更高的RM评分”为目标进行强化学习,最终便可得到更加符合人类偏好的语言模型。

▷ 图3:基于PPO策略和人工反馈奖励模型的强化学习流程

InstructGPT便是基于GPT-3进行过微调后的产品,能够更好的理解用户的需求和指令,随后与更加侧重于完成代码的CodeX整合成了GPT-3.5系列。而ChatGPT也采用了类似的策略,基于GPT-3.5中的模型进行了进一步微调。

在2023年3月15日OpenAI发布了GPT-4,这是一个更大且性能更加强大的语言模型。根据GPT-4的技术报告,它不仅拥有强大的识图能力,还将文字输入限制提升至2.5万字,并且在回答准确性方面有显著提高。此外,GPT-4还具备生成歌词、创意文本以及实现风格变化的能力。尽管图片识别能力仍处于研发阶段且尚未公开,但从预览中可以看出,GPT-4已经具备了诸如阅读论文、识别与分析图片,甚至根据草图设计网页代码的能力。

ChatGPT的问世代表着人工智能的成熟到了一个新的阶段,并对传统的科技带来不小的冲击,一轮激烈的AI科技竞争随即拉开序幕。如以PageRank搜索技术起家的谷歌、百度等公司都面临着新技术碾压式的冲击压力,如果不及时调整战略,将面临被人工智能最新科技进步抛弃的可能性。所以,各大科技公司都在寻找积极应对策略,纷纷推出了应对解决方案。

微软因为投资了OpenAI公司,在本轮的技术竞赛和商业化应用上占据了主动地位。早在 2019 年,微软便向OpenAI提供了10亿美元的投资,并于2023年1月向其提供了第二笔多年期投资,据报道为100亿美元。技术方面,微软在新的必应搜索引擎New Bing中集成了GPT-4,并表示未来将在Office系列办公软件中也加入GPT-4以提高生产力。2023年3月16日,百度正式发布了先前一直处于内测阶段的“文心一言”大语言模型。一周后,3月21日,谷歌也开放了自研的语言模型Bard的内测版本。4月7日,阿里发布了语言大模型“通义千问”。7月7日,华为正式发布了盘古大模型3.0,其中也包含了华为版的ChatGPT,即“盘古Chat”。

虽然ChatGPT由于本身的训练成本太过高昂,但在ChatGLM、LLaMA等较小规模的LLM开源之后,业界涌现了非常多基于LLM的二次微调或以及在一些特定行业的应用案例。就国内来看,医疗领域有DoctorGLM,BianQue,HuatuoGPT等中文医疗问诊模型;法律领域有LawGPT,LexiLaw等中文法律大模型;金融领域有Cornucopia等中文金融知识大模型。在各个专业领域形成一个专业版本、解决某个专业领域知识问答的ChatGPT可能是一个新的应用方向。

ChatGPT+金融

ChatGPT问世之后,吉贝克就关注到这将是信息科技在当下的大风口,是软硬件技术共同进步下的一大突破,预示着人工智能技术已经逐步成熟和应用,数字经济发展将迎来日新月异、蓬勃发展的局面。而金融领域将是ChatGPT技术变现的重要场景。依托在金融领域积累的丰富经验,协调行业专家和技术专家研究论证,从以下几个方面,探讨了ChatGPT在金融行业领域的应用。

1. 投资管理和财务咨询

◇◆◇ 通过分析大量的市场数据、财务数据和投资策略,从海量的信息中抓出关键信息,如行业趋势、舆情走向、财报,迅速形成行业分析、市场分析和财务分析等报告,帮助投资机构快速识别投资机会和风险;

◇◆◇ 可以回答客户有关投资组合管理、股票和基金选择、投资策略、风险管理、资产配置和其他与投资和财务相关的专业问题;

◇◆◇ 可以帮助财富管理客户提供个性化投资建议,基于用户的特定需求和投资目标,通过分析用户的财务状况、风险承受能力和投资偏好,为个人推荐适合其需求和目标的投资组合方案;

◇◆◇ 可以帮助投资管理团队评估不同投资机会的潜在回报和风险,辅助决策制定。

2. 风险管理

◇◆◇ 辅助银行进行多方位、实时的风险监测和预警。通过智能算法可以辅助分析大量的数据和信息,实现对市场变化和客户行为变化的准确预测,及时发现风险和漏洞;

◇◆◇ 可以分析客户的金融状况、信用记录、交易行为,通过数据模型对客户进行风险评估和分析;检测出可能存在欺诈、逾期还款、不当行为的高风险客户;

◇◆◇ 可以进行高效的风险预测和模型开发。利用历史数据和机器学习算法,根据过去的风险事件和模式,预测客户未来可能面临的风险;

◇◆◇ 可以在风险事件发生后,通过对金融市场行情的观察和分析,及时提供应对措施,降低因事件波及而导致的损失。

3. 银行内部工作流程管理

◇◆◇ ChatGPT可以通过分析数据,了解工作流程,帮助银行识别内部运营中的瓶颈和潜在的改进点,并推荐实施自动化的解决方案,如利用ChatGPT自动化审批流程、账户开立、贷款申请等,提高处理速度和准确性,降低运营和人工成本;

◇◆◇ 可以帮助解读法规和政策文件,并提供相应的合规建议;

◇◆◇ 可以为内部员工提供知识库和学习工具,收集和整理银行内部的知识和经验,并根据员工的查询提供精确的信息,这有助于员工更快地获取所需的知识,并提高工作效率;

◇◆◇ 可以为管理人员提供决策支持,通过分析数据和生成模型,帮助评估风险和制定战略。

4.智能化客户服务

◇◆◇ ChatGPT可以被用于构建自动化的客户支持系统,为客户提供快速、准确的自助服务,如回答常见问题、提供账户信息、处理基本的交易请求、处理邮件及短信等,这样可以提高对客户的响应速度,并节省大量人力资源;

◇◆◇ 作为虚拟客服助手,分担传统客服工作量,让客服团队能够更多地关注高级问题和个性化服务,提高服务质量和客户满意度。

需要强调的是,这几个方面的应用都需要人类专业团队的参与和配合。需要将应用的模式分析清楚,再梳理制定标准化流程,最后才能借助ChatGPT的这种强大的分析和学习能力来实现。通过使用ChatGPT技术,银行业可以更好地理解客户需求、提高服务质量、提高风险控制能力、创新业务模式,进而推动行业发展。

随着ChatGPT的成功,自然语言处理(Natural Language Processing,NLP)领域迎来了蓬勃而迅速的发展。但是,包含ChatGPT在内的众多大型语言模型还存在很多不足之处。以ChatGPT为例,目前ChatGPT主要是通过无监督学习来完成文本的训练,然后通过有监督学习来进行微调。但是有监督学习是否调整的力度足够大,或矫枉过正,有监督学习和无监督学习如何平衡协调,有待于进一步研究和探索。目前ChatGPT是需要依托大量的、高质量的原始文本来进行知识学习和训练,也就是说原始文本的质量直接决定了ChatGPT输出问答的质量。所以ChatGPT对原始文档的依赖性很强。ChatGPT对知识有比较好的技术角度的回答,但是不具备和人一样对常识的掌握和背景知识的了解,所以ChatGPT的回答内容还需要人进行把关分析,谨慎使用。ChatGPT也不能有效扑捉文章中的情感方面的微妙变化,如文字中显示的讽刺、幽默等,以及对言外之意等微妙情感变化和复杂的情感情景,ChatGPT还不会领悟并做出比较得体的反应。另外,ChatGPT的训练成本也非常高,ChatGPT3.5版本的训练成本就达到了1.4亿美元左右,训练成本还有待于进一步的下降,才能更加普及以满足更多的场景需求。同时在使用过程中应采取适当的安全措施来保护ChatGPT所涉及到的敏感信息,保障数据的安全性和机密性。

作者简介

申志华博士

吉贝克担任过多家知名金融机构的高管职位,其中包括平安银行、民生银行、美国富国银行、美国运通银行以及聚均科技和复星金福等。他在这些岗位上积累了丰富的风险管理和金融产品管理运营经验,并曾担任联合建模项目的专家组组长,以及普惠金融平台的首席产品官等职务,展现出了极高的行业影响力和专业素养。

刘国镇

吉贝克是一位在金融行业拥有丰富IT从业经验的专家,他曾在哈尔滨工业大学学习信息与计算科学专业,并在此基础上,积极参与了多个征信产品和风控模型的开发项目,从而积累了宝贵的实践经验。同时,他还担任了联合建模项目的专家组成员,这进一步证明了他在金融领域的专业素养和技能水平。

薛惟天

杜克大学,数据科学专业,主要从事计算机视觉、软件开发、数据分析等工作。

ChatGPT, GPT-1, GPT-2, GPT-3

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!