北京时间周二凌晨1点,全球领先的AI研究机构OpenAI如期举行了备受期待的春季发布会,为公众带来了其最新研发的GPT-4o多模态大模型。这款新旗舰模型不仅继承了GPT-4系列的强大功能,更在速度、价格以及情感智能方面实现了质的飞跃。

相较于之前的GPT-4 Turbo,GPT-4o在速度上实现了显著提升,让用户能够更快地获得所需信息和服务。同时,OpenAI还致力于降低用户的使用成本,使GPT-4o在价格上更具竞争力,进一步推动了人工智能技术的普及和应用。

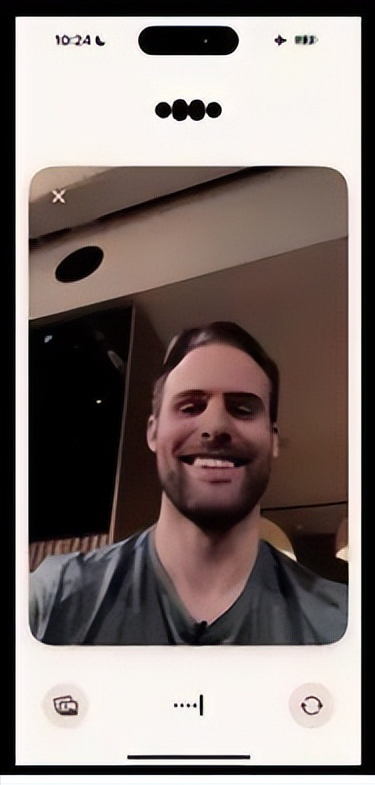

发布会上,OpenAI展示了GPT-4o在情感智能方面的卓越表现。通过一系列精心设计的演示,观众亲眼见证了GPT-4o如何检测并理解人类的情绪。在其中一个环节中,演示者Zoph将手机举到自己面前,要求GPT-4o告诉他自己长什么样子。在初次尝试中,GPT-4o参考了Zoph之前分享的一张照片,将他错误地识别为“木质表面”。然而,在第二次尝试中,GPT-4o表现出了惊人的进步。它不仅成功识别了Zoph的面部特征,还注意到了他脸上的微笑,并对他说:“看起来你感觉非常快乐,喜笑颜开。”

这一演示令人印象深刻,展示了GPT-4o在情感智能方面的巨大潜力。它不仅能够识别和理解人类的情绪,还能在交流中运用这些情绪信息,使对话更加自然、生动。这种情感智能的突破,将为人工智能在各个领域的应用带来革命性的变化。

当然,也有评论指出,GPT-4o在读取人类情绪方面仍存在一定的困难。毕竟,情感是一种复杂而微妙的心理现象,难以用简单的算法和模型来完全捕捉。然而,这并不影响GPT-4o在情感智能领域的领先地位。相反,它为我们提供了一个全新的视角和思考方式,让我们重新审视和思考人工智能与人类情感之间的关系。