1 前言

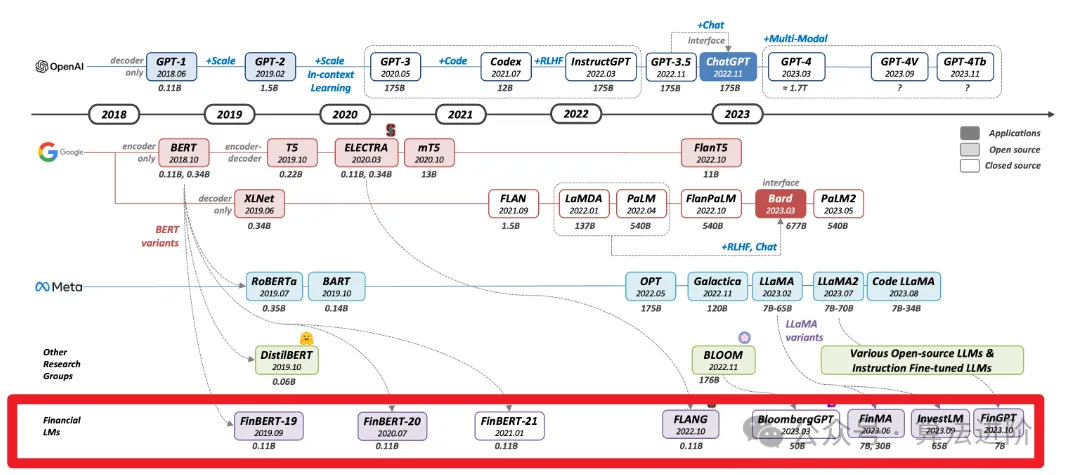

本综述调查了大语言模型(LLM)在金融领域的应用,重点关注现有解决方案。我们回顾了利用预训练模型、微调特定领域数据以及从头开始训练定制LLM的方法,为金融专业人士根据数据、计算和性能需求选择合适的LLM解决方案。最后,我们讨论了金融应用中利用LLM的局限性和挑战,为金融人工智能提供路线图。

2 语言模型的基础知识

语言模型是一种统计模型,用于预测词序列的概率分布。其目标是计算概率P(W),可以表示为:?(?)=?(?1,?2,…,??)=?(?1)?(?2|?1)?(?3|?1,?2)…?(??|?1,?2, …,??−1)其中W表示词序列。条件概率P(wi|w1,w2,…,wi-1)表示给定前几个词时单词wi的可能性。它经历了从n元语法模型到基于循环神经网络(RNN)的模型,再到transformer架构的演变。Transformer采用自注意力机制,能捕捉长期依赖关系,提高了大规模数据集的训练效率。这些模型的发展主要得益于计算能力的进步、大规模数据集的可用性和新型神经网络架构的发展。语言模型的应用领域广泛,包括自然语言处理(NLP)等。

3 AI在金融领域的应用概述

3.1 当前人工智能在金融领域的应用

近年来,人工智能在金融领域得到广泛应用,包括交易和投资组合管理(量化交易)、金融风险建模、金融文本挖掘和金融咨询及客户服务。

交易和投资组合管理采用机器学习和深度学习模型进行价格预测;

金融风险建模利用深度学习进行欺诈检测、信用评分和破产预测;

金融文本挖掘从非结构化数据中提取有价值信息;

财务咨询和客户服务则利用人工智能聊天机器人提供经济高效的客户服务。

深度学习模型在短时间内从大量数据中提取有价值见解的能力,为金融行业提供了及时、准确的信息,随着LLM的出现,人工智能在金融行业的潜在应用得到进一步扩大。如下常见金融任务的大模型表现情况:

– 情绪分析(SA)

– 文本分类(TC)

– 命名实体识别(NER)

– 问答(QA)

– 股票走势预测(SMP)

– 文本摘要(Summ)

3.2 大型语言模型(LLM)在金融领域的优势

LLM在金融领域具有优势,能够处理自然语言指令,通过零样本学习执行任务,具有适应性和灵活性,可同时进行情感分析、总结和关键字提取。LLM擅长将复杂任务分解为可操作计划,适合金融客户服务或咨询。然而,需要注意其局限性和风险。

4 金融领域的LLM技术

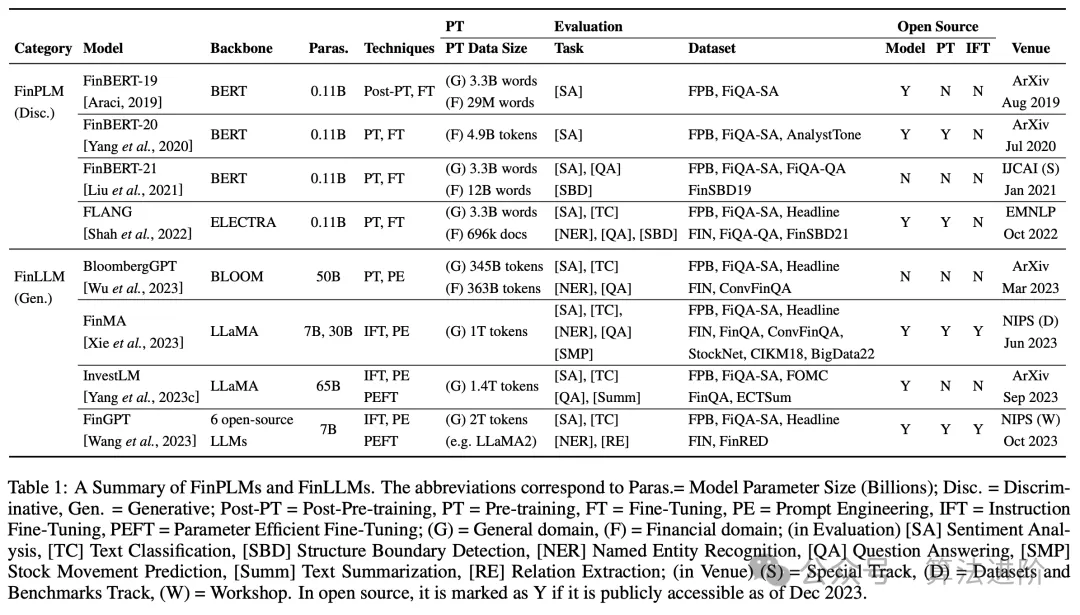

FinBert-19: FinBERT:使用预训练语言模型进行金融情绪分析。

FinBert-20: FinBERT:金融通信的预训练语言模型。

FinBert-21: FinBERT:用于金融文本挖掘的预训练金融语言表示模型。

FLANG:当 FLUE 遇见 FLANG:金融领域的基准和大型预训练语言模型。

BloombergGPT: BloombergGPT:大型金融语言模型

FinMA: PIXIU:大型金融语言模型、指令数据和评估基准。

InvestLM: InvestLM:使用金融领域指令调整的大型投资语言模型。

FinGPT: FinGPT:金融数据集中开源大型语言模型的指令调优基准

4.1 在金融应用中利用少样本/零样本学习

访问金融领域的LLM解决方案可以通过API或开源LLM实现。OpenAI、Google和微软等公司提供API服务,不仅提供基础语言模型功能,还提供针对特定用例定制的附加功能。虽然无专门为金融应用程序设计的专用LLM服务,但通用LLM服务可能适用于常见任务。例如,OpenAI的GPT4服务应用于财务报表分析。开源LLM如LLAMA、BLOOM、Flan-T5可从Hugging Face模型库下载,自行托管和运行。与使用API不同,利用开源模型可提供更大的灵活性、隐私保护和零样本或少热点学习,但与专有模型之间存在性能差距。

4.2 微调模型

金融领域微调LLM可增强领域特定语言和语境理解,提高金融相关任务性能,生成更准确定制输出。

4.2.1 LLM微调的常用技术

现代微调LLM技术分为标准微调和教学微调两类。标准微调在原始数据集上训练,教学微调则创建特定任务数据集。LoRA和量化等技术可降低计算需求。LoRA对低秩分解因子进行微调,减少可训练参数数量。量化使用较低精度浮点数,减少内存占用,提高计算速度。

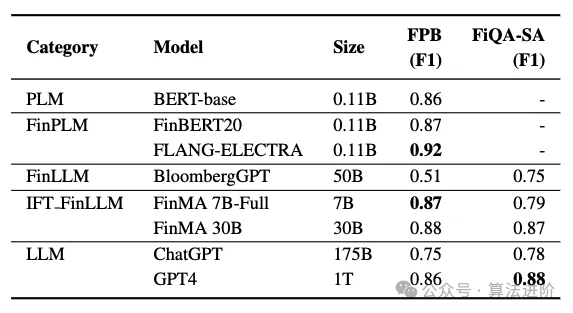

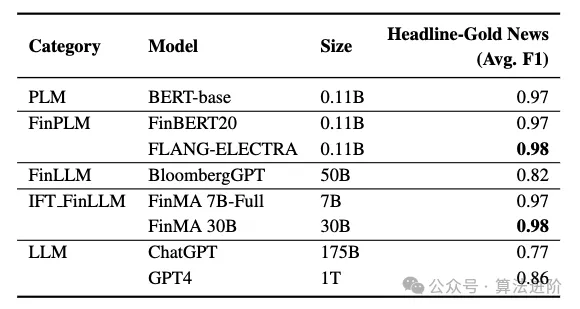

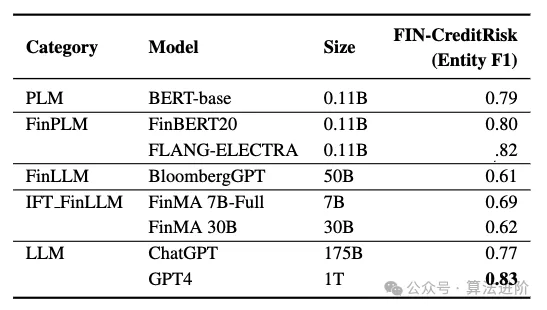

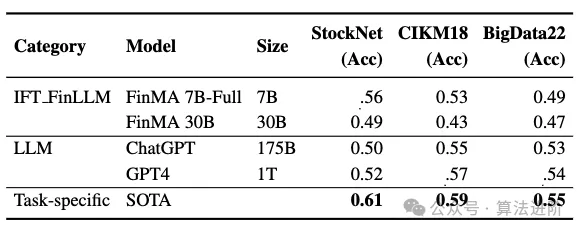

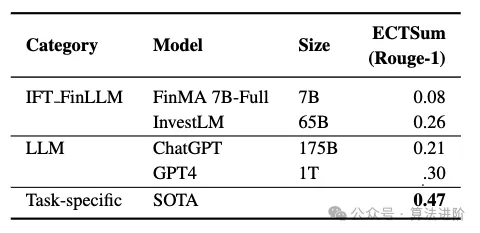

4.2.2 微调金融LLM评估

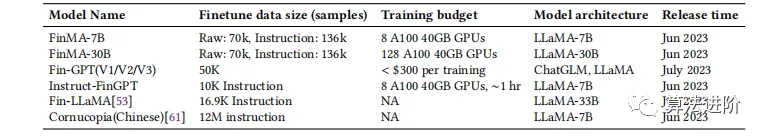

微调金融LLM性能可按两类评估:金融分类任务和金融生成任务。分类任务包括情绪分析和新闻标题分类,生成任务重点则是问答、新闻摘要和命名实体识别。表1提供了所有微调金融LLM的详细信息,我们将讨论三个重点:(1)PIXIU,微调136K特定任务指令样本的LLaMA。(2)FinGPT,为金融行业提供端到端训练和应用FinLLMs框架,利用LoRA技术微调开源LLM,仅限于金融分类任务。(3)Instruct-FinGPT,微调10k指令样本的LLaMA,仅评估金融分类任务。微调后的金融LLM在所有金融领域任务中表现更好,优于彭博社GPT。相较于强大的通用LLM,微调后的金融LLM在金融分类任务中表现出色,但在金融生成任务中表现相似或更差,需要更多领域特定数据集来提高其生成能力。

表1 微调金融LLM快速概览

4.3 从头开始预训练

从头开始训练LLM的目标是开发出对金融领域具有更好适应性的模型。表2显示了目前从头开始训练的金融LLM:BloombergGPT、Xuan Yuan 2.0和Fin-T5。在预训练阶段,公共数据集与金融专用数据集结合的趋势明显,彭博社GPT是一个例子,其语料库由普通文本和金融相关文本混合组成,主要依赖于50亿个彭博社专有代号的子集。彭博社GPT和Fin-T5比原始模型表现出更优的性能,在市场情绪分类、多分类和多标签分类等活动任务中成绩突出。这两个模型在金融相关的生成任务中表现明显优于各自的一般模型,取得了显著的成绩。与类似规模的公共模型相比,它们表现出相似或更优的性能。总体而言,BloombergGPT在各种通用生成任务中表现出值得称赞的性能,在同类规模的模型中占据有利地位。

表2 从头开始训练的金融LLM快速概述

5 如何将LLM应用于金融应用的决策过程

5.1 确定LLM的必要性

LLM在缺乏训练数据、需要常识知识或新兴能力时具有优势,适合处理分布外数据和高度差异的对话。LLM可以作为不同模型和工具之间的编排者,整合和利用各种工具。然而,使用LLM会带来巨大成本,因此在任务有明确定义、有大量带注释的训练数据或对常识知识或新兴能力依赖程度最低的情况下,在最初阶段依赖LLM可能不是必要的或合理的。

5.2 在金融任务上应用LLM的一般决策指导

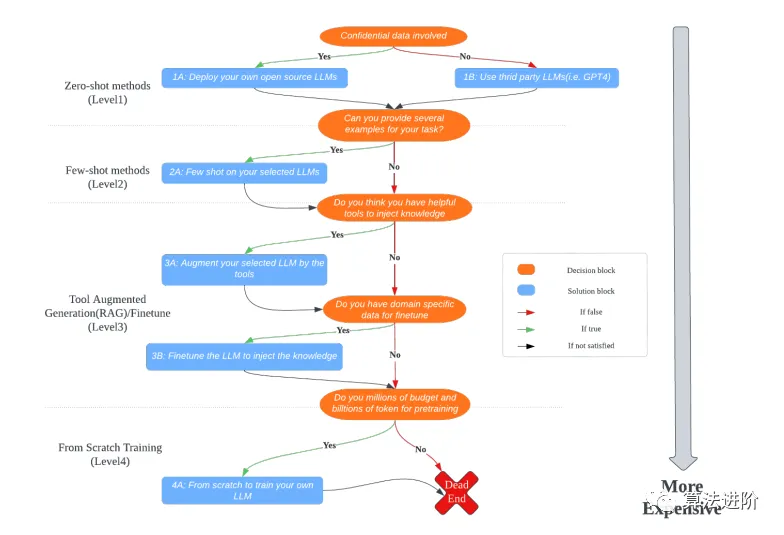

使用LLM进行金融任务时,遵循决策指导框架以确保高效实施,如图1所示。框架分为四个级别,逐级成本增加。建议从级别1开始,当模型性能不令人满意时再升级。每个级别都有详细解释和成本范围。

图1 决策过程流程图

5.2.1 级别1:零样本应用决策块决定使用现有LLM服务或开源模型。涉及机密数据时,需进行1A操作块,包括LLAMA、OpenLLAMA、Alpaca和Vicuna。LLAMA提供7B至65B模型,仅限研究目的;OpenLLAMA提供3B、7B和13B模型,支持商业用途。Alpaca和Vicuna基于LLAMA微调,提供7B和13B选项。部署需GPU强大本地机器。无数据隐私考虑时,建议选择GPT3.5/GPT4或谷歌BARD等第三方LLM,费用与API调用相关。5.2.2 级别 2:少样本应用当模型性能不佳时,可尝试少样本学习,提供示例问题及其答案。成本与前几个级别相似,每次需提供示例。一般需1-10个示例。挑战在于确定最佳示例数量和选择相关示例,需实验和测试以达到所需性能。5.2.3 级别3:工具增强生成和微调在复杂任务中,可使用外部工具或插件与LLM结合,如计算器、搜索引擎等。工具与LLM的集成需提供工具描述,可能面临成本较高、输入长度限制等问题。若性能不佳,可尝试微调LLM,需要注释数据、计算资源(GPU、CPU等)和专业知识,如表1所示。5.2.4 级别4:从头开始训练LLM若结果不满意,需从头开始训练特定领域LLM,但伴随高昂计算成本和数据要求,通常需数百万美元和数万亿标记数据集。训练过程复杂,需专业团队数月甚至数年完成。遵循此框架,金融专业人士和研究人员可做出明智选择,符合需求和资源限制。5.3 评估金融领域LLM评估可通过多种方法进行,包括直接评估模型在下游任务中的表现。评估指标可分为准确性和性能两类。准确性包括回归和分类指标,性能包括特定任务中的表现。评估可在历史数据、回溯测试或线上实验进行。除了特定任务评估,还可应用LLM通用指标,如综合评估系统,涵盖准确性、公平性、鲁棒性、偏见等方面。5.4 限制虽然LLM在金融领域应用取得重大进展,但需承认其局限性,主要挑战是虚假信息产生和偏见。为确保信息准确性和减轻幻觉,可实施检索增强生成等措施。为解决偏见问题,可采用内容审查和输出限制技术来控制生成内容并减少偏见。在监管和治理方面,LLM的可解释性有限,需持续研究并实施保障措施以确保伦理和负责任地使用。参考资料:《 Large Language Models in Finance: A Survey》相关资源:https://github.com/adlnlp/finllms对金融量化交易有兴趣的伙伴,可以扫码加群/个人微信【Ai_Algorithms】,回复【量化】可以加群及获取资料,免费开通量化账号等全流程指导!

关注?公众号,后台回复【金融LLM】可获取相关论文

更多精彩内容请点击:AI领域文章精选!