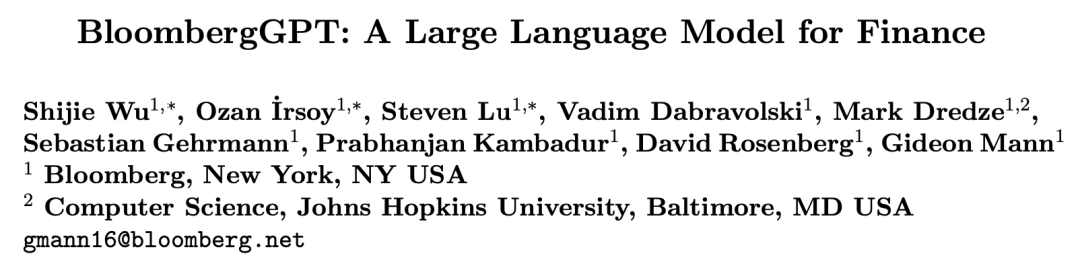

毫无疑问,ChatGPT和GPT-4的一炮走红对各行各业都带来了巨大的变革影响,目前以ChatGPT为代表的生成式人工智能大模型(LLMs) 正向各个专业领域进发。最近,金融巨头彭博Bloomberg正式发布了金融领域第一个大语言模型BloombergGPT,彭博研究人员以一篇长达65页的技术报告为行业展示了人工智能大模型在金融专业领域的无穷潜力。BloombergGPT是一个拥有500亿参数的LLM,其在海量的金融数据语料库上进行了训练。

论文地址:https://arxiv.org/abs/2303.17564

论文地址:https://arxiv.org/abs/2303.17564

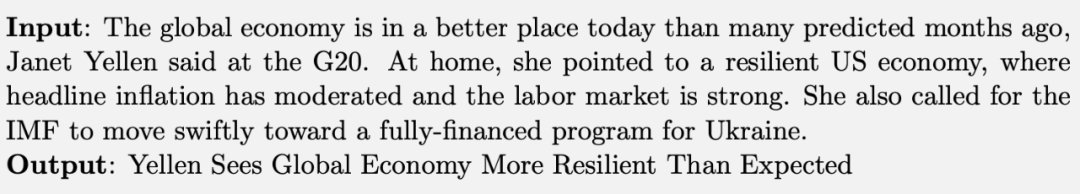

此外,BloombergGPT还可以充当你的个人金融助理,例如你可以直接询问它硅谷银行的CEO是谁,BloombergGPT的回答是Greg Becker,而其他非金融专业大模型的回答则有些不准确。

一、BloombergGPT的数据集

ChatGPT的成功向我们表明,LLMs会在训练数据量突破一个临界规模后出现惊人的”涌现能力“。因此BloombergGPT的研发团队将收集数据作为”大模型炼丹“的第一步。为了训练参数量非常庞大的BloombergGPT,研究团队构建了一个名为”FinPile“的综合数据集,其由一系列新闻、档案、金融文件和从彭博数据库中提取到的英文财经文档构成(这些数据是通过彭博过去二十年的业务流程获得的,不得不说,某种意义上,数据就是财富)。FinPile可以进一步划分为金融领域数据和通用领域数据。

1.1 金融领域数据

金融领域数据共包含了3630亿个token,占总数据集token量的54.2%,这部分数据由金融领域相关网页、彭博官方财报、金融领域新闻源和金融领域相关书籍等不同形式构成。由于FinPile中的一部分数据是私人文件和隐私数据,所以FinPile不会被公开。1.2 通用领域数据

通用领域数据集有3450亿个token,占总数据集token量的48.73%,这部分数据由Pile数据集[1]、C4数据集[2]和维基百科数据集构成。其中Pile数据集是GPT-Neo模型的训练集,GPT-Neo模型的参数量为20B,Pile是一个领域非常丰富的数据集,作者认为将Pile包含在BloombergGPT的训练集中,会为模型带来更强的泛化能力。C4数据集是T5模型[2]的训练集,T5模型是谷歌在2020年发布的大规模多任务预训练模型。此外,为了增加BloombergGPT的专业能力,作者也在FinPile中增加了一部分维基百科数据,这部分数据更新至2022年7月1日。

二、模型训练

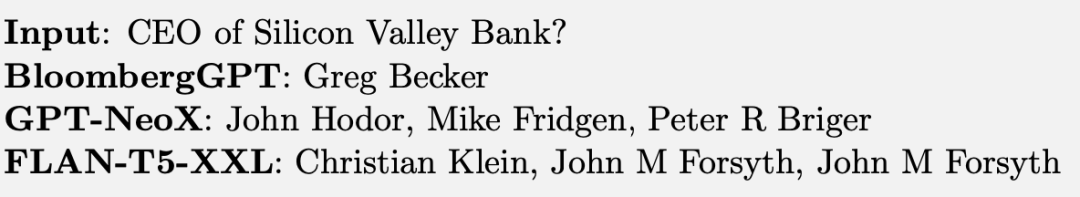

BloombergGPT的模型架构是基于BLOOM[3]的自回归Transformer解码器网络,其中解码器层数为70层,模型形式化定义为:

其中SA 是我们较为熟悉的多头自注意力模块,LN是层归一化,FFN 是具有1个隐藏层的前馈网络。与原始Transformer解码器结构不同的是,BloombergGPT在token编码之后加入了一个额外的层归一化操作:

其中是初始的token编码,是新加入的层归一化操作。

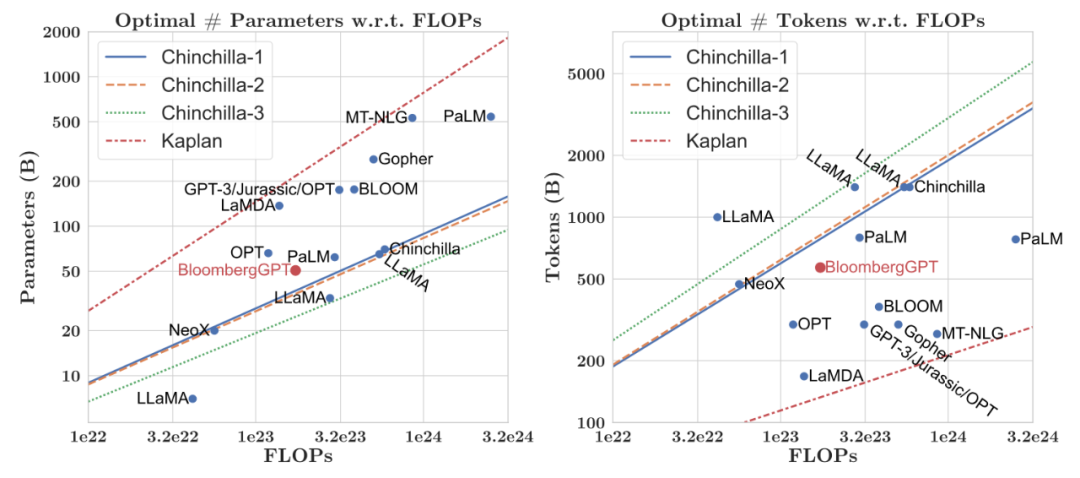

作者首先根据大模型训练缩放法则(Chinchilla scaling laws) 计算出,如果要训练参数量为500亿的BloombergGPT,则参与训练的token数据量需要达到恐怖的11000亿。研究团队没有进一步扩充数据集,因此最终模型的参数量定为500亿。下图展示了先前已有大模型经过缩放法则得到的参数量与数据量的关系,并与BloombergGPT进行了对比。

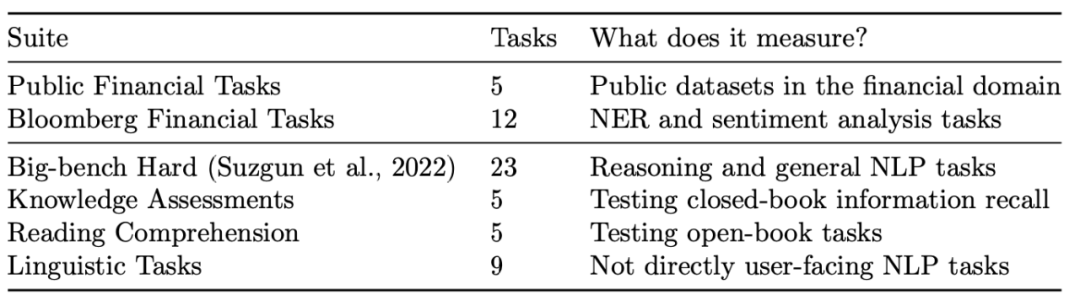

3.1 通用任务评估

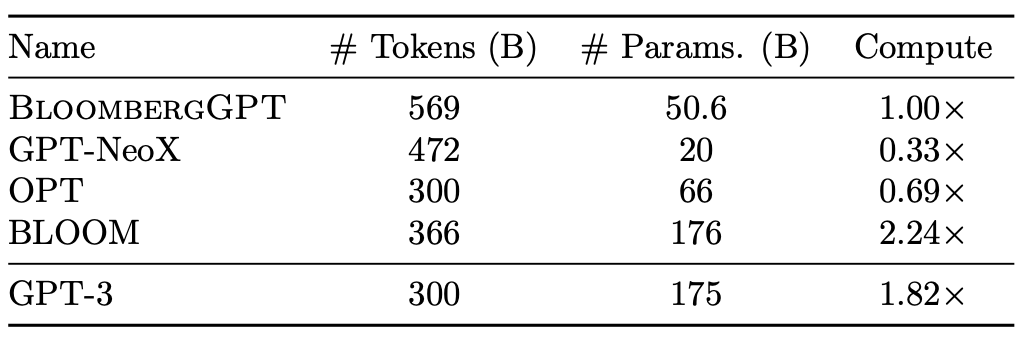

作者选取的与BloombergGPT进行性能对比的其他大模型包括GPT-NeoX、OPT、BLOOM、GPT-3,这些模型训练阶段使用的token数量、模型参数总量、计算量的对比如下表所示。

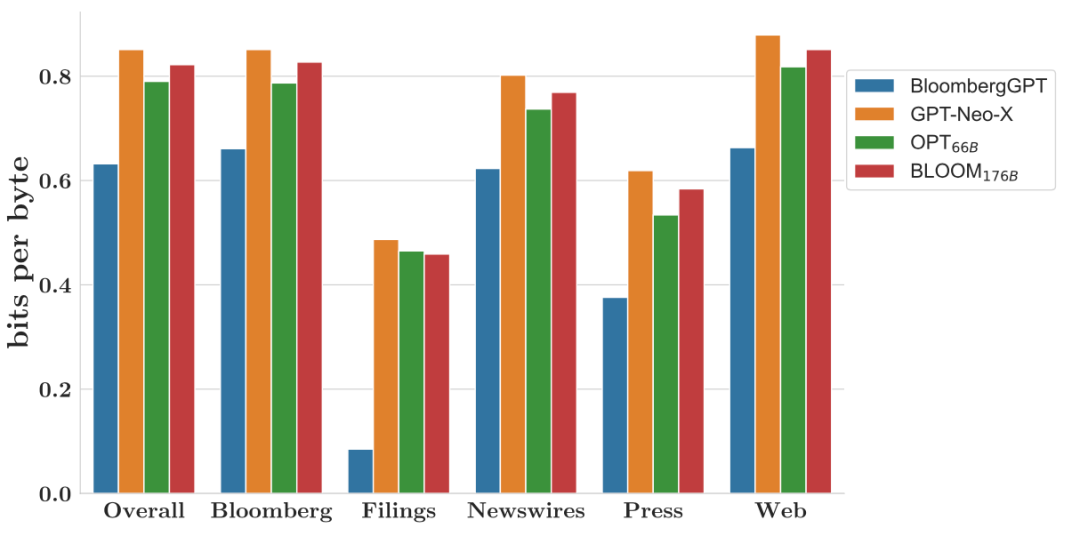

作者重点对BloombergGPT的bits per byte(BPB)指标进行了评估,BPB是评估大语言模型的一种常见指标,其取值越小,代表模型效果越好,下图展示了BloombergGPT与其他模型的BPB指标的对比效果。

可以看出,BloombergGPT在金融测试集上的BPB均好于其他大模型,尤其是在财报(Filings)这个类别上的性能遥遥领先,这也其实达到了彭博开发BloombergGPT的最初目的。

3.2 金融领域任务评估

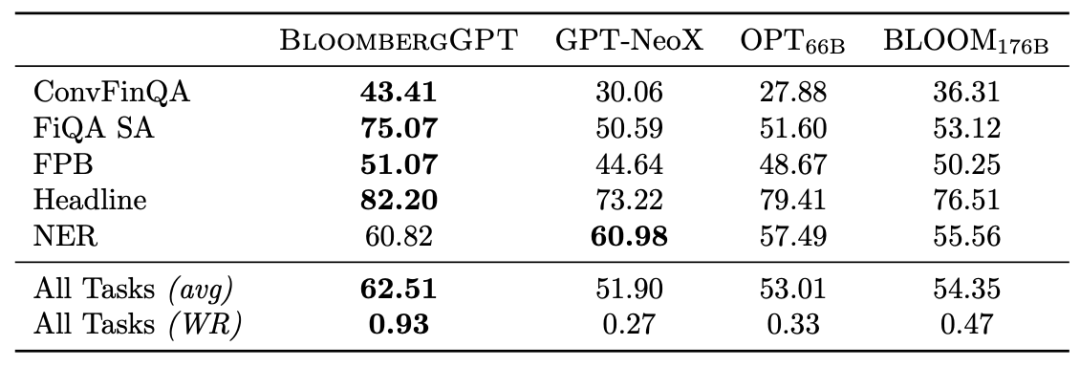

在金融特定数据上,作者重点考察了BloombergGPT在以下5个任务上的性能:

1.FPB,包括对金融新闻语句的情感分类任务。

2.FiQA SA,该任务同样是一个情感分析任务,它是专门预测英文财经新闻和微博标题中的特定情感。

3.Headline,这是一个二分类任务,主要判断黄金商品领域的新闻标题是否包含用户所关注的信息。

4.NER,这是一项命名实体识别任务,主要针对从向美国证券交易委员会提交的财务协议中收集的用于信用风险评估的财务数据。

5.ConvFinQA,这是一个推理问答任务,给定500份收益报告文件,其中每份报告包括文本和至少一张包含财务数据的表格,任务是回答需要进行数字推理的金融对话问题。

下表展示了BloombergGPT在上述5个任务中的性能表现,可以看到BloombergGPT在其中的四个任务上都达到了SOTA性能。

参考文献

[1] Leo Gao, Stella Biderman, Sid Black, Laurence Golding, Travis Hoppe, Charles Foster, Jason Phang, Horace He, Anish Thite, Noa Nabeshima, Shawn Presser, and Connor Leahy. The pile: An 800gb dataset of diverse text for language modeling, 2021. URL https://arxiv.org/abs/2101.00027.[2] Colin Raffel, Noam Shazeer, Adam Roberts, Katherine Lee, Sharan Narang, Michael Matena, Yanqi Zhou, Wei Li, and Peter J. Liu. Exploring the limits of transfer learning with a unified text-to-text transformer. Journal of Machine Learning Research, 21(140): 1–67, 2020. URL http://jmlr.org/papers/v21/20-074.html.[3] Teven Le Scao et al. Bloom: A 176b-parameter open-access multi-lingual language model. arXiV, 11 2022. URL http://arxiv.org/abs/2211.05100. 作者:seven_Illustration by IconScout Store from IconScout-The End-本周上新!

扫码观看!

“AI技术流”原创投稿计划

TechBeat是由将门创投建立的AI学习社区(www.techbeat.net)。社区上线480+期talk视频,2400+篇技术干货文章,方向覆盖CV/NLP/ML/Robotis等;每月定期举办顶会及其他线上交流活动,不定期举办技术人线下聚会交流活动。我们正在努力成为AI人才喜爱的高质量、知识型交流平台,希望为AI人才打造更专业的服务和体验,加速并陪伴其成长。

投稿内容

// 最新技术解读/系统性知识分享 //

// 前沿资讯解说/心得经历讲述 //

投稿须知

稿件需要为原创文章,并标明作者信息。

我们会选择部分在深度技术解析及科研心得方向,对用户启发更大的文章,做原创性内容奖励

投稿方式

发送邮件到

chenhongyuan@thejiangmen.com

或添加工作人员微信(chemn493)投稿,沟通投稿详情;还可以关注“将门创投”公众号,后台回复“投稿”二字,获得投稿说明。

>>> 添加小编微信!

关于我“门”

▼

将门是一家以专注于发掘、加速及投资技术驱动型创业公司的新型创投机构,旗下涵盖将门创新服务、将门技术社群以及将门创投基金。将门成立于2015年底,创始团队由微软创投在中国的创始团队原班人马构建而成,曾为微软优选和深度孵化了126家创新的技术型创业公司。如果您是技术领域的初创企业,不仅想获得投资,还希望获得一系列持续性、有价值的投后服务,欢迎发送或者推荐项目给我“门”: bp@thejiangmen.com

点击右上角,把文章分享到朋友圈

点击“阅读原文”按钮,查看社区原文⤵一键送你进入TechBeat快乐星球