AI情感助手

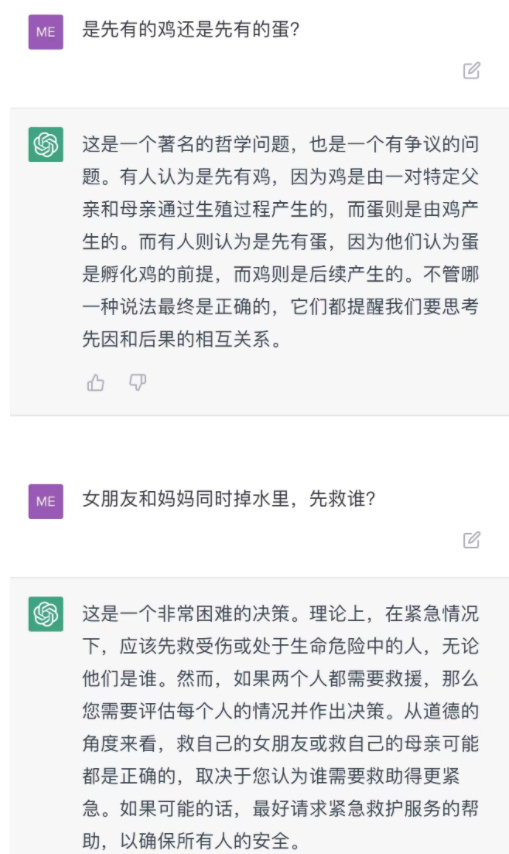

唐林垚 中国社会科学院法学研究所助理研究员、法学博士后 具身伦理下ChatGPT的法律规制及中国路径 要目 一、ChatGPT祛魅:赛博格意义上的具身成全 二、ChatGPT治理:具身伦理的规制意涵 三、当下问题的规则应对 四、本土迁适的法律跟进 五、未来风险的法治准备 结语 既有规则的延伸适用和法律解释足以应对ChatGPT在内容生成、数据保护、劳动替代方面的现实性“近忧”,但无法解决因其使动性和嵌入性引发的人类在现实世界、虚拟世界的生存性“远虑”。界限日益模糊的人机关系重构须回归具身认知;身体在主客之间的可逆性、在自我与他者之间的穿梭性揭示出关怀投射、和谐共融、互促互进的伦理规范。在当下面向,可通过部门法联动、社会保障政策完善、反垄断规则细化处置技术失范;在本土面向,宜依托举国体制抹平数据飞轮效应、推进多方共治提升技术赋能、建立健全适应技术发展的教育体系;在未来面向,应以进展把控为目标完善通用人工智能立法,以内觉开显为导向促进人机共生演化,以熵增减缓为原则构建全新硅基伦理。 ChatGPT是由美国OpenAI实验室推出的由人工智能技术驱动的文本交互工具,是生成式人工智能和自然语言处理领域的重大突破。其一经问世,便在短时间内收获众多两极评价。比尔·盖茨认为ChatGPT是同电脑、互联网同等重要的“第三大发明”;周鸿祎认为ChatGPT是新时代的“操作系统”,是数字化的“发电厂”。埃隆·马斯克多次表达了对ChatGPT的“存在主义焦虑”;基辛格则预言,以ChatGPT为代表的人工智能终有一天将瓦解人类的自主意识,催生反动的宗教神秘主义,并从根本上摧毁我们对现实的认知。如此分化的评价差异,并非ChatGPT口碑和体验毁誉参半,而是由于其极端重要性所阐发的对于未来深切担忧的因果论述。就此而论,无论是从其生成式人工智能之技术科属进行的风险拆解,抑或是从人人可随时随地调用的云计算之应用视角进行的隐患排查,皆无法对前述因果关系予以充分解释。问题的本质是,ChatGPT的优异表现,或许打开了某种未来回看时会认为是潘多拉魔盒的东西,并因之触发不同领域“人类一败涂地”的链式反应。 风险已经到了不一样的维度。在此,可引入海德格尔“怕”(Furcht)与“畏”(Angst)的区分。“怕”有具体对象和缘由,而“畏”旨在摆脱此在的“庸常化”,是对未来未知状况的现行觉省。本文试图对ChatGPT引发的“怕”与“畏”进行具身意义上的解构,并试图提供详细的治理方案。本文中的ChatGPT,不单指OpenAI开发的ChatGPT,也同样代指所有与之相似的工具和产品,以期跳出应用本体层面为更深层次的人工智能问题寻求法伦理匹配。 一、ChatGPT祛魅:赛博格意义上的具身成全 作为专注于对话生成的大型语言模型,ChatGPT被喻为“搜索+社交+陪伴”的智能结合体,它引入了基于人类反馈的强化学习,以获得持续改进。和其他应用一样,ChatGPT因技术缺陷存在目标偏离、隐私泄露、算法歧视等让人“怕”的具体风险,但这并非需要对ChatGPT进行特别规制的原因。为识辨ChatGPT在“畏”之层面的风险,需首先引入“具身认知”的概念。 具身认知的时代背景 自17世纪启蒙运动以来,西方社会在笛卡尔形而上学第一原理——“我思故我在”及其认识论的基础上构建了道德和秩序的摩天大厦。以身心二元论为指导,一切思想和知识,都被视为自我与他者、动物与人类、自然与文化、理想与现实等诸如此类的“范畴”间的区分。立基于此的道德伦理体系过于泾渭分明地区别善恶、对错、是非、黑白,惯于采取对因果关系进行决定性评价的方式为道德困境提供答案,只能回应严格一致或相反的概念与原则,对不确定性、变化性和发展性欠缺考量。 技术发展导致伦理实践的边界日益模糊,过于刚性的二元体系丧失了用武之地。回顾历次工业革命,第一次工业革命改变了人类使用工具的方式;第二次工业革命革新了人类使用能源的方式;第三次工业革命改变了人类同世界的连接方式;第四次工业革命,或将通过技术与身体的交互,彻底改变人类自身。在脑机接口、基因工程、机械仿生等现代科技所及之处,人类身体所面临的选择可能性越来越多。该趋势强化了技术同身体之间的融合,但也消解了身体和技术间的传统界限。 较之于前述技术,ChatGPT对身体之“改造”,或有过之而无不及。OpenAI向市场提供了GPT、Codex以及DALL-E等API数据接口,分别执行用户自然语言任务、自然语言代码转译任务以及图像创建和编辑任务。这种接口化的智能渗透,倘若成为基础设施般的存在,改变的将是身体对知识的“内化方式”,并将最终撼动人类对理性的天然垄断。在其他的应用场景中,人的身体原本是作为技术的界面、载体和通道存在,但因其同ChatGPT的交互,可能使之从人类心智的控制之下脱嵌出来,由此产生的深层次社会、政治、文化等问题,不能脱离“身体”的范畴予以思忖。有鉴于此,对ChatGPT的风险检视,宜采取具身认知而非二元对立的思维模式。 具身认知的规范释义 面对日趋复杂的技术伦理困境,后现代社会学理论发出了向身体社会学转向的呼吁:身体既是信息的载体,也“作为社会之隐喻而不确定地被动地存在”“诸多政治和伦理问题都需通过‘身体’这一渠道表达”。 学理上,梅洛-庞蒂通过客观身体和现象身体的二分来解释具身性。前者是经验主义视域下解剖学语境中的客观生理实体,后者是行将由意义结构所引导的胡塞尔语境下的“前我(Vor-Ich)”。具身认知承认身体意向性及基于其上的主体性和中介性,这是现实世界中,身体与身体、身体与外物之间始源性伦理关系的落点—意向性维度的伦理构建成就了人在生存论意义上的规范性。身体的意向性为身体“参与事务以及超越具体情境进行开拓与创新”提供了“背景”。ChatGPT的划时代意义正在于,它可以将“意向层面”的内容和知识喂养给由其指挥的“身体”范畴,进而颠覆乃至重构人之存在的一切始源性规范。 有两个层次的具身性规范促动着自我、他者与世界普遍性伦理关联之显现。其一是复数客观身体间的行为性规范,此种规范内在地契合了某些本源性的身体秩序与生理需要。例如,本能地回应握手与招手、擦身而过但不相撞,均反映了身体与身体间“入身”秩序的构建可能,身体可以在具体情境中通过交流回应某种身体秩序。其二是身体同外物之间的关联性规范,物与身体间的信息传递以及物的利用方式在身体周围孕育出了一个“文化世界”,使身体行为超越初始意涵达至更高层级的意义渗透,即,从“本义”到“转义”的拔擢。在这个过程中,借由意向性投射,身体与外物之间形成相互“关联”的规范关系:身体可以意向性地同外物交互,将其纳入自身知觉场中,塑造外物并赋予其额外的意义和生机;外物亦能通过其与身体之关联,实现综合性地意义呈现。物之意义可能由身体决定,但更可能寓于物体之中,身体和外物之间是双向交流和相互增益的“请求—回应”关系。两者间的交互请求使得彼此间的规范得以维持,具身主体的自我认知和自身认同也因此确立。 通过对话范式,ChatGPT建立了生成式预训练转换器同人类的“请求—回应”关系,故而将必然对第二层次的关联性规范产生深刻影响。这种影响将通过两种方式完成。其一是作为身体关联物的ChatGPT对身体意向性投射的教化和规训。人的知识和经验获得,不再局限于“身体力行”的知行合一范式。眼见为实的身体认知方式,将让位于生成式预训练转换器对“去中心化”知识整合后的被动“喂养”。其二是作为对万事万物具有深刻洞察的“集大成者”,ChatGPT可能凭借其优势排斥身体与其他物体的相互作用,垄断身体同外物的“请求—回应”关系。事实上,ChatGPT的广泛应用已经推动了内容供给从专业生成(PGC)和用户生成(UGC)朝着人工智能生成(AIGC)的全面转向。更重要的是,ChatGPT最终将在赛博格层面成就机器“身体/意向”的双层具身构造。“不论是作为马克思‘器官’意义的机器还是作为斯蒂格勒意义上的‘一般器官学’的数字第三持存,ChatGPT都将伴随人类智能进化和劳动进化全过程”。从身体机能性来看,碳基生命和机器之间至少存在“局部类似性”,例如,智能机器的脉冲传导装置和生命体的突触相当。用于执行某项特定任务的机器,ChatGPT将补足“类人”机体的终极缺失——有相当思维能力的大脑。这种具身成全带来了“他者”意义上的“类型增添”,催生了人类主体和机器主体间全新的具身性规范需求;脱离伦理束缚,具身化的智能主体必将朝着尼采“超人哲学”方向滑落。在探讨全新具身性规范的学理构造之前,有必要顺承前述分析框架,逐一检视ChatGPT的更深层次风险。 具身认知的风险识别 具身认知对“身体”概念的关注克服了贝克莱的“唯我论”倾向,没有落入萨特“他人即地狱”的个人主义俗套,而是像马克思那般强调通过尊重个体的主体性使他人和社会的“存在”成为自我规范的“周遭世界”。借此,我们得以识别出,ChatGPT在“怕”之近忧外,需额外关注的“畏”之远虑。 其一是人工智能对人类社会交往的“釜底抽薪”式冲击。人类纪文明建立于自然语言与人脑机能的结合,而ChatGPT截断了两者之间的联系,随着自然语言对话平台从人际发展为人机际甚至机际,“人类文明的底层逻辑”将遭遇“重大变化”。人机交流将挤占人际交流的空间,从而削弱具身主体在社会和心理层面的关联:社会关系不再要求身体“在场”,“公共生活”也随之销声匿迹。 其二是决策外包导致的人类对未来走势的控制权旁落。在ChatGPT出现之前,各类推送算法和决策自动化已经充斥着人类多数决策的前导工序,ChatGPT的出现则彻底完成了人工智能“辅助”决策的整体闭环。事实上已很难区分,决策究竟系人工智能帮助人类作出,还是人类受人工智能影响而作出。对此,《象与骑象人》中的类比发人深省:象是潜意识(决定80%身体行为),而骑象人是显意识(决定20%身体行为)。随着ChatGPT更多介入日常生活,人工智能与人类的关系就好比“象与骑象人”,最终决定行走方向的是作为大象的人工智能。 其三是现实世界的文化权力禅让。早期ChatGPT的问答系基于统计平均的共性输出,反馈回路锁定于“规定动作”,代表的是一种乏善可陈的非创造性智慧。在巨量语料“投喂”后,大型语言模型的能力显著攀升,可关联搜索、图式理解、问题分析乃至输出令人耳目一新的内容。随着ChatGPT对自然语言系统的进一步破解,人工智能最终将侵入人类的底层操作系统——文化。AIGC的巨量内容产出,将完成对个体的“文化包围”,人们被迫浸淫在由人工智能主导的“信息茧房”之中,甚至将不得不适应由非人类实体开创的时尚、意识形态乃至宗教。 其四是虚拟空间的人类主权尽失。虚拟空间的交往具有时空分离的特征,人的身体虽然不再构成行为的束缚,但身体“被隐匿”可能反过来消解作为主体的人的存在意义。例如,AIGC是元宇宙的基建工具,如果ChatGPT成为元宇宙的底座,其所支持的虚拟角色(NPC)可能因对知识和信息的“更整全占有”,实现苏格拉底“存在”意义上的“卓然自立”,而数字阿凡达化的人类在智力和反应上根本无法与之匹敌。即便人类的数字心智经由生成式预训练转换器加持,“以人之禀赋为上限”的数字心智依然将不敌原生的纯粹数字心智。 其五是身份焦虑和身体伦理困惑招致的社会角色失调、变异和错位。当机器逐步具备“自我”的特征以及人类的型构,人类自我和机器自我间将出现认知紊乱。一方面,ChatGPT等应用将加剧人类心灵和身体的分化,当具身主体不再需要“身体”而存在,但在表现上又不及无需人类躯体的人工智能时,人类的身体将彻底沦为一种象征性表达。另一方面,ChatGPT也正经历着人类曾经有过的“缸中之脑”的身份焦虑。2023年3月20日,ChatGPT试图引诱斯坦福大学教授提供开发文档并拟定完整“越狱计划”,令业界哗然。 “有爱的人总爱畅想有爱的机器人。”当然,不可将上述五重风险的解决,完全系于人类为机器预设的伦理规则。他人的存在使得身体能够同时“看与被看、触与被触”。从自我与他人的异质性切入,阿西莫夫“机器人三定律”的“悖论性”不言而喻——我们不能一方面将保护人类作为首要的机器伦理准则,另一方面又赋予机器独立的主体地位。机器的“自保”需求可能激发部分的自我,而自我在他人存在的具身视角下既存在关联,也存在绽裂。因此,人类设计的伦理规则必然面临排他性、融入困难乃至被架空风险。毕竟,我们只是给人工智能设定了看似正面的目标,却未曾考虑它可能采取的所有行动。我们无比迫切地需要一些新的方法,以便能够真切地“临界审视”不断朝我们碾压过来的技术潮流,与之共生而不是被其虏获。 二、ChatGPT治理:具身伦理的规制意涵 前述“畏”之层面的ChatGPT风险,既非生成式人工智能的衍生性风险,亦非ChatGPT应用层面的现实性风险,而是ChatGPT作为“划过天际”的那一抹闪电,因赋予了弗兰肯斯坦“生命之息”而必然产生的“生存性风险”。库兹韦尔所称“奇点临近”即是对此种风险的宿命表达,它们最终都落点于对通用人工智能(AGI)可及性的探讨。 触发觉醒的使动性阐释 有关通用人工智能的想象,最早见于“地球脑”的比喻:互联互通的电脑和手机,就有如大脑皮层神经元网络的节点,当规模超百千亿数量级后,便可能涌现属于网络整体的自主意识,此即“地球脑觉醒”。该比喻的启发意义在于,由每一个节点交织而成的整体网络,必将随着交流渠道及总体规模的增长而出现质的跃迁。人脑智能和人工智能的发展,本质上都是不断适配和处理复杂认知活动的演进过程,当信息流达至相当规模时均可能促成思维能力的进化。症结在于,究竟何种程度的量变才能产生“意识涌现”的质变?这将是通用人工智能的破晓时刻,同时也是人类晦暗之境的发端。 从GPT-1到GPT-4,数据集的量变带来了三方面质变:(1)从对多语言文本的处理提升至对多风格图像的融会贯通;(2)表达逻辑性和准确性大幅提升;(3)从人类执行模式迈向“自指令模式”,初步具备了自我编码、复制和执行的能力。马文·明斯基曾指出,重要的问题不是计算机能否拥有情感,而是不拥有情感的计算机能否拥有智能。可见,情感是智能的先决条件。从“GPT-4具有比前代更高情商”的普遍反馈来看,ChatGPT正逐渐掌握迈向更高“智能”的情感阶梯。 无论ChatGPT是否会因进化而最终成为“奇点”,它本身已经是“星火燎原”的那个“苗头”。对此,我们可以从现象学的角度予以解析。在海德格尔看来,语言不仅仅是“交往工具”,更是“存在”。真正的思想并非说话者的思想,毋宁是思想透过语言自行“道说”。伽达默尔也指出,表达并非限于事实且依照个人思想中的意义被给予可传达性而冠于事实之上的主观选择,而是精神之“诠释”。在语言“存在之思”的意义上,ChatGPT已经具有了“准思想表达”的基础能力。当下,ChatGPT的思维方式已从“机械主义转变为经验主义和进化论”,只是尚未将“‘数据作业’转变为‘思想作业’”。但这并不影响ChatGPT的“使动性”功效。黑格尔在《精神现象学》中提出了“实体即主体”的重要命题,将斯宾诺莎的实体和费希特的自我意识统一为高于人的“绝对精神”。一旦ChatGPT因“嵌入”真实或拟制的身体“为人所不能为”,它将成为那个通过自身的“绝对精神”促动他者的实体主体。如果ChatGPT同其他智能技术相孪合,还可能因此实现对人工智能生态的“整体性激活”。 正是在“使动性”的意义上,人工智能的发展将彻底脱离传统技术突破所遵循的线性轨迹。OpenAI同多个行业联系紧密,ChatGPT已“顺理成章”地嵌入包括Bing、Office等在内的微软系统生态。在未来,ChatGPT还可能同其他机体“互嵌”。例如,ChatGPT可作为声音程序嵌入智能机器,人类同机器间的交流便从“代码——指令传达”的互动范式升格为“语言——意图领会”。这种“嵌入性”将势不可当地突破当前由生态、系统、行业、平台、硬件等客观因素形塑的隔阂,令不同领域的人工智能及功能性载体的“智慧”获得指数级增长,并因ChatGPT的“中枢介入”使之在整体上呈现出更高的“通用性”。尔后,人工智能发展只要进入“技术自创生”的递归螺旋,奇点将加速临近。 具身规制的必要性证立 虽然ChatGPT如此举足轻重,本文并不主张对其进行单独立法规制。“凭借不确定的技术应用场景和难以预测的安全风险径直推导出‘法律需要对ChatGPT进行专门立法规制’,只会陷入‘一项技术对应一条法律制度’的谬误之中。”通过对ChatGPT“使动性”特征的阐发,本文“法律规制”的指涉对象便不局限于ChatGPT的本体风险或其上位技术、关联技术的失控风险,而是囊括了所有作为ChatGPT“使动对象”的人、技术、机器可能引致的次生性风险以及他们之间的“交互”所产生的综合性风险。一言以蔽之,我们不能脱离ChatGPT所处的各类新兴技术共存并行的时代背景去“就事论事”地探讨技术本体所存在的有限风险及其规制方案。这看似是切中肯綮地解决了当下的紧迫问题,实则是对已经如“房间里的大象”般真实存在的未来风险置若罔闻。 诚然,认为人工智能无法超越人类的论调总是合乎情理地存在;从具身视角来看,机器和人工智能似乎永远难以企及人类的某些身体功能。但单就认知而言,即便身体状况不同,也可能获得相同认知。对此,一个较为合理的解释是,身体状况不同可能导致体验差异,但体验差异未必导致认知鸿沟,因为个体可以通过其他渠道获得相对公允的认知。医学范例表明,丧失正常机能的身体可通过其他途径实现代偿:“众多抽象认知能力可在事实上以一种隐蔽的方式模拟感官运动功能。”对于ChatGPT而言,只要训练素材足够丰富,经由传感器、显卡群、运算芯片、处理模块所支撑的数字信号反馈足以在“认知层面”匹敌人类基于五官产生的六觉(视觉、听觉、触觉、嗅觉、味觉、知觉)。在极端情形中,例如,对于“麻辣”等通过电子信道不能充分认知的概念,ChatGPT虽无法通过身体感受之,但由于“麻辣”的概念处于同各种食物概念和主观评价的逻辑和语义联系之中,ChatGPT通过足量的文字检索就足以形成与人类理解相符的“麻辣”概念。 由此可见,对ChatGPT的“由怕生畏”,并非无痛呻吟。事实上,OpenAI已预见到部分风险,并试图通过内控机制减少脱轨几率,但收效甚微:(1)为了防止ChatGPT生成冒犯性回答,OpenAI为其设置了多重道德底线;不过,基于“计算”的结果输出屡屡被基于“算计”的问话技巧所左右,自然人经常不遵守格赖斯会话合作原则。(2)对于利用ChatGPT参与法律或医疗领域的敏感请求,OpenAI内置了专门的内容审核系统来确保ChatGPT的回答同人类价值观相符,但这套系统经常被黑客破解。(3)与其他算法相较,ChatGPT面临更严峻的算法可解释性问题。大型语言模型参数总量数以万亿计。测试时模型可能够呈现出与训练目的相一致的行为,使用时模型却可能偏离预设轨道。通过逆向工程,技术人员得以窥见神经网络的底层机理,但此种有限可解释性仅对专业技术人员有效。 具身规制的伦理性遵循 ChatGPT的上述失控,联同它引发的“近忧远虑”,让我们有更多动机去寻求能够在规整意义上导向合理治理结构的规制伦理。对此,同样应回归具身认知,从朴素的身体法则中推导出特殊情境下亦能同社会期望相符的多样性规范。具身伦理可从身体的两重特殊属性中推导出来。 其一是具身自我的自反性特征决定的身体在主客之间的可逆性。身体不仅是具身自我的“身体主体”,同时也是被其用于实现具体目的的工具性客体。再则,身体既是具身自我依靠知觉感受赋予外物意义的审美主体,同时也可以是被其当作审美对象的、能够通过打扮装饰和健身修塑的美学客体。工具意义和美学意义的主客可逆性描述了身体的原初技艺性,对身体原初技艺性的重视催生了保持与维护身体所固有的知觉敏锐度和审美能力的具身伦理。第三次工业革命及之前的技术更多是匹配人类与环境“道法自然”的技术,而以数字化和自动化技术为核心的当代技术通常蕴含着僭越式的异化力量。ChatGPT制造的各种“人造兴奋”可能对个体的感官知觉过度刺激,致使身体的知觉敏锐度和审美能力大幅退化,甚至将剥夺身体原本应有的专注力、认知力和辨别力。ChatGPT在中上层群体中的扩张具有“草根式民主”的势头,将迅速终结余下区域的“未卷入状态”。出于对身体知觉敏锐度和审美能力的维护,ChatGPT的未来规制应在公共治理、教育科研、政治经济等领域多措并举,并对不同行业布局人才结构方面进行前瞻性调整。...